Redis自动插入数据的脚本写法和简单实用方案分享

- 问答

- 2026-01-24 02:37:57

- 2

主要参考了Redis官方文档关于数据类型的介绍、网络技术博客中关于缓存预热和定时任务的讨论,以及常见的自动化脚本编写实践)

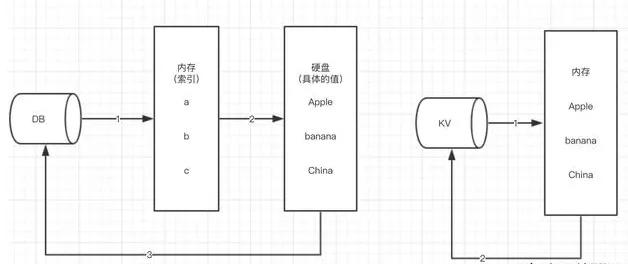

Redis本身是一个内存数据库,它没有像传统关系型数据库那样内置的、复杂的自动作业调度器(比如MySQL的事件调度器),所谓的“自动插入数据”,通常需要我们借助外部工具或编程语言来实现,这里分享几种最常见和实用的方案,从简单到复杂。

最基础的方法:使用Shell脚本和Linux的Cron定时任务

这是最直接、最容易上手的方案,适合那些对Linux系统比较熟悉,并且需要插入的数据逻辑比较简单的场景。

-

脚本写法(Shell脚本): 我们写一个简单的Shell脚本,使用Redis的命令行工具

redis-cli来执行插入操作,假设我们想每天凌晨1点,自动向一个名为daily_visits的键设置一个初始值0。-

创建一个脚本文件,比如叫

redis_daily_init.sh。

-

#!/bin/bash # 设置Redis服务器的连接信息,如果在本机默认端口,可以省略 REDIS_HOST="127.0.0.1" REDIS_PORT=6379 # 如果有密码,需要设置 # REDIS_PASSWORD="your_password" # 使用redis-cli连接Redis并执行命令 # 如果无密码 redis-cli -h $REDIS_HOST -p $REDIS_PORT SET daily_visits 0 # 如果有密码,可以这样写 # redis-cli -h $REDIS_HOST -p $REDIS_PORT -a $REDIS_PASSWORD SET daily_visits 0 # 可以同时执行多条命令 # redis-cli -h $REDIS_HOST -p $REDIS_PORT <<EOF # SET user:count 1000 # EXPIRE daily_visits 86400 # 设置一天后过期 # EOF echo "$(date): Redis data initialized."

-

给脚本添加可执行权限:

chmod +x redis_daily_init.sh。

-

-

实用方案(配置Cron任务):

- 打开当前用户的Cron任务列表:

crontab -e。 - 在文件末尾添加一行,配置定时任务,下面的意思是每天凌晨1点执行我们的脚本。

0 1 * * * /path/to/your/redis_daily_init.sh >> /path/to/your/redis_job.log 2>&1 - 保存并退出,这样,Linux系统就会在每天凌晨1点自动运行这个脚本,完成数据的插入或更新。

>> ...部分是将脚本的输出(包括echo信息和可能的错误)重定向到一个日志文件,方便查看执行情况。

- 打开当前用户的Cron任务列表:

更灵活的方法:使用Python/Node.js等编程语言脚本

当需要插入的数据逻辑比较复杂,比如需要从文件、数据库或其他API接口获取数据后再写入Redis时,使用Python这类编程语言会灵活得多。

-

脚本写法(Python示例): 假设我们需要从一个JSON文件中读取用户信息,然后批量插入到Redis的Hash结构中。

-

确保安装了Python的Redis客户端库:

pip install redis。 -

创建一个Python脚本,比如

import_users_to_redis.py。 -

import redis import json import time # 连接Redis服务器 r = redis.Redis(host='localhost', port=6379, db=0, decode_responses=True) # 如果有密码 # r = redis.Redis(host='localhost', port=6379, password='your_password', db=0, decode_responses=True) try: # 模拟从文件或API获取数据 # 这里用一个字典列表模拟用户数据 users_data = [ {"id": 1, "name": "张三", "email": "zhangsan@example.com"}, {"id": 2, "name": "李四", "email": "lisi@example.com"}, {"id": 3, "name": "王五", "email": "wangwu@example.com"} ] # 批量插入到Redis,使用Hash类型,key为 user:{id} for user in users_data: user_key = f"user:{user['id']}" # 使用hset插入Hash字段,mapping参数可以接收一个字典 r.hset(user_key, mapping=user) # 可以顺便设置一个过期时间,比如一周(可选) r.expire(user_key, 7*24*60*60) print(f"{time.strftime('%Y-%m-%d %H:%M:%S')} - 成功导入 {len(users_data)} 条用户数据") except Exception as e: print(f"{time.strftime('%Y-%m-%d %H:%M:%S')} - 发生错误: {e}")

-

-

实用方案: 这种脚本的自动化执行方式可以和第一种方法一样,使用Linux的Cron来定时调用Python解释器执行这个脚本。 Cron任务可以这样写:

# 每天凌晨2点执行一次用户数据同步 0 2 * * * /usr/bin/python3 /path/to/your/import_users_to_redis.py >> /path/to/your/python_redis_job.log 2>&1注意这里要写全Python解释器的路径(可以通过

which python3命令查看)。

专门的任务调度工具:如Celery(针对Python生态)

对于企业级应用,需要更复杂、更可靠的任务调度(比如重试机制、任务监控、分布式执行),可以使用专门的任务队列,Celery是一个强大的异步任务队列/作业系统,常用于Python应用。

-

简单方案描述:

- 在你的Python项目中安装并配置Celery和Redis(Celery本身可以用Redis作为消息代理)。

- 定义一个Celery任务函数,在这个函数里编写你需要自动插入Redis数据的逻辑。

- 使用Celery的定时任务功能(Celery Beat)来规划这个任务的执行周期,比如每5分钟执行一次。

这种方式比Cron更强大,因为它与你的应用代码结合更紧密,能够管理任务状态,但设置起来也比前两种方法要复杂一些,更适合已经在使用Python Web框架(如Django、Flask)的项目。

总结一下

选择哪种方案,主要看你的具体需求:

- 简单、一次性或低频任务:直接手动执行Shell或Python脚本。

- 逻辑简单、周期固定的系统级任务:Shell脚本 + Cron是最佳选择,轻量且可靠。

- 逻辑复杂、需要与业务代码交互的任务:编程语言脚本(如Python) + Cron提供了极大的灵活性。

- 企业级、需要高可靠性和可管理性的任务:考虑使用Celery这类专业的任务调度框架。

无论用哪种方法,都要注意安全(如Redis密码、服务器权限)、错误处理(脚本要有日志输出)和资源管理(避免频繁插入大量数据影响Redis性能)。

本文由太叔访天于2026-01-24发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://waw.haoid.cn/wenda/84824.html