Redis多实例同时读写那点事,怎么才能快起来呢?

- 问答

- 2026-01-17 05:42:57

- 2

说到Redis多实例同时读写,想让它快起来,这事儿其实挺有意思的,它不像我们平时给一台电脑加个内存条那么简单,而是更像管理一个团队,看你怎么分工协作,让每个人(每个实例)都发挥出最大效率,还不互相打架。

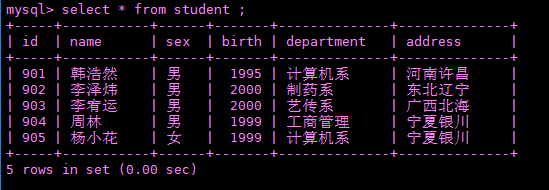

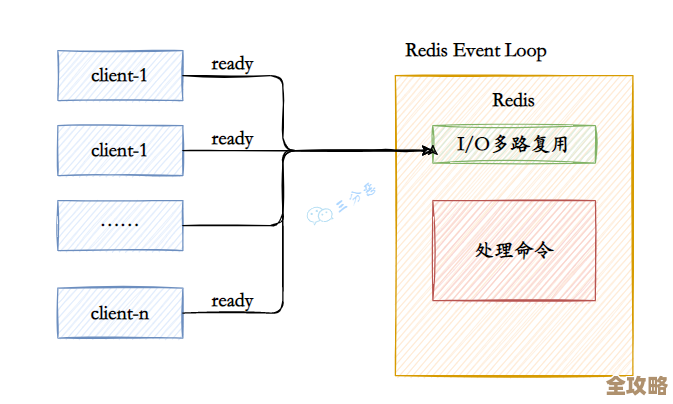

咱们得搞清楚一个最根本的问题:为什么单个Redis实例会碰到瓶颈? (来源:Redis官方文档关于持久化的说明)Redis为了保证数据不丢,有个叫持久化的机制,简单说就是定期把内存里的数据写到硬盘上,这个过程,尤其是做快照(RDB)的时候,Redis可能会为了保持数据一致性而暂时不太能全力处理新的命令,虽然新版本优化了很多,但在数据量巨大时仍可能对性能有影响,单个实例的CPU核心是有限的,网络带宽也是固定的,当读写请求多到一定程度,它自然就忙不过来了。

核心思路就是“别把鸡蛋放在一个篮子里”,也就是做分布式部署,主要有以下几种常见的招数,咱们一个一个说。

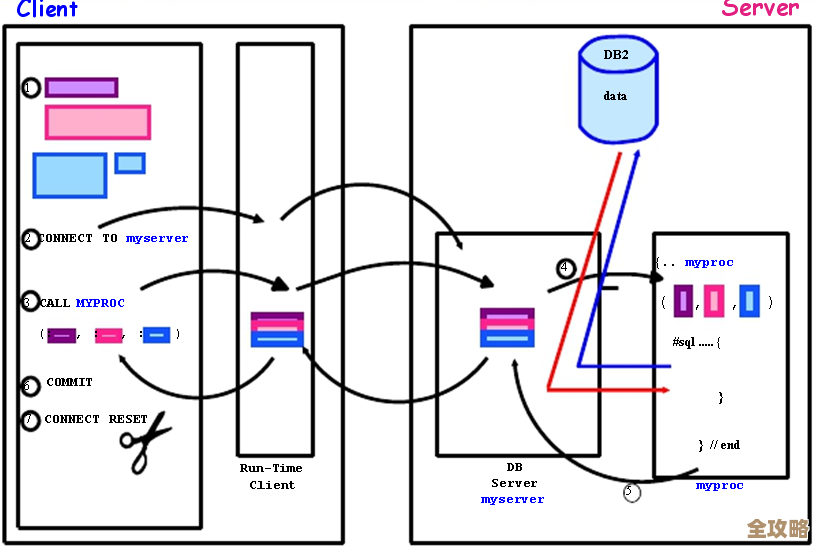

第一招,也是最基础的:主从复制(Replication)。(来源:普遍认可的Redis基础架构模式)这个模式很简单,就是弄一个主实例(Master)专门负责写操作,然后挂上好几个从实例(Slave)来同步主实例的数据,并专门负责读操作,这样一来,写的压力全在主实例身上,读的压力可以分散到多个从实例上,这就好比一个公司,老板(Master)负责做重大决策(写),然后有一堆员工(Slave)负责执行和对外提供咨询(读),这个方法对读多写少的场景特别管用,瞬间就能把读性能提升好几倍,但它的软肋是,写的压力一点都没减少,全指着主实例那一个“老板”,万一老板累倒了(主实例宕机),虽然可以选个员工当新老板(故障切换),但切换期间整个系统可能会短暂不可用。

第二招,解决写瓶颈的利器:分片(Sharding),也常被叫做分区。(来源:Redis官方对数据分区的介绍)这个思路更彻底,它觉得光分担读压力不够,写压力也得拆开,怎么拆呢?就是把整个数据集合砍成好几块,每一块数据放到一个独立的Redis实例里,比如说,你可以决定所有以字母A-M开头的键放到实例1,N-Z开头的键放到实例2,这样,客户端读写不同键的时候,就会被自动引导到不同的实例上去操作,这就好比把一个超大仓库分成了好几个小库房,每个库房有自己独立的出入口和管理员,同时进货出货,效率自然高,现在最流行的Redis集群(Redis Cluster)就是官方给出的一个完整的分片解决方案,它帮你自动管理数据该放在哪片,以及当某个实例宕机时怎么恢复,分片是真正实现读写性能线性扩展的关键,理论上,只要你增加实例,性能就能一直往上走。

第三招,在应用层动脑筋:客户端缓存。(来源:Redis官方博客关于客户端缓存的探讨)这个方法有点“作弊”的意思,但非常有效,它的想法是:干嘛所有请求都非要跑到Redis那里去呢?对于一些不怎么变化的热点数据(比如用户的个人信息、商品分类目录),能不能直接在访问Redis的应用程序自己的内存里存一份?这样,绝大部分的读请求根本不用走网络,直接在应用本地就返回了,速度是纳秒级的,快得飞起,这带来了一个新问题:如果Redis里的数据被修改了,怎么通知应用程序把它本地的缓存删掉或更新?Redis 6.0版本之后提供了一个叫“客户端跟踪”的功能,能很好地解决这个问题,这招相当于给每个应用程序发了一个小本本,记下最常用的信息,只有小本本上没有或者信息可能过期时,才去翻中央档案室(Redis)。

除了这三板斧,想让多实例环境快起来,还得注意一些“细节”。

比如网络延迟,如果你把Redis实例都放在同一个机房的内网里,它们之间通信速度很快,但要是你把几个实例分散到天南海北的数据中心,那光在路上传输数据就要花很多时间,再好的架构也快不起来,实例之间的网络质量是生命线。

再比如数据持久化策略,就像开头说的,持久化会影响性能,在多实例环境下,你可以灵活配置,对主实例配置一个比较保守的持久化策略,保证数据安全;而对只读的从实例,可以配置更激进的策略,或者干脆关闭持久化,让它心无旁骛地处理读请求,最大化性能。

还有键的设计,在分片环境下,怎么设计键名变得特别重要,如果你能把一批需要同时访问的数据,通过键名设计,让它们落在同一个分片实例上,就能避免跨实例的复杂操作,效率会高很多。

总结一下,让Redis多实例快起来,没有一颗银弹,通常你需要根据自己业务的实际情况,像搭积木一样组合使用这些方法,读压力大,就先上主从复制;读压力写压力都大,就必须得分片;对极致性能有追求,再配合上客户端缓存,把网络、配置、键设计这些细节做到位,这样才能真正让你的Redis“团队”协同高效,跑出飞一样的速度。

本文由帖慧艳于2026-01-17发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://waw.haoid.cn/wenda/82231.html