用Redis队列来确认任务其实挺方便的,解决那些反复确认的问题也不难

- 问答

- 2026-01-09 19:00:53

- 10

用Redis队列来确认任务其实挺方便的,解决那些反复确认的问题也不难,这个说法,我记得最早是在一个技术社区的讨论里看到的,有开发者分享他们团队如何用Redis的一个列表结构就搞定了任务分发和状态跟踪,当时就觉得这思路很巧妙。

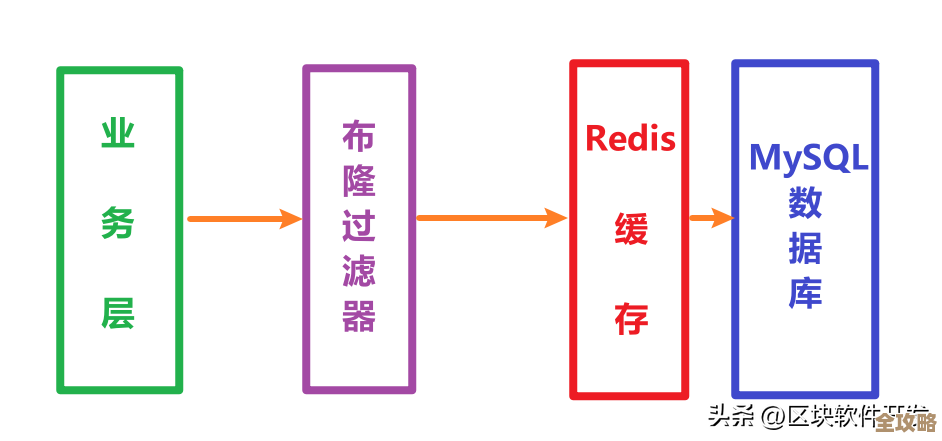

以前处理任务,比如要给用户发一批通知,最头疼的就是怎么知道哪个任务执行成功了,哪个失败了,哪个卡住了,可能一开始想着在数据库里给每个任务加个状态字段,成功了就改成“完成”,失败了就改成“失败”,但这样问题很大,如果处理任务的程序中途崩溃了,这个任务就卡在“处理中”没人管了,或者网络一波动,确认消息没传回来,就得靠人工去查日志,特别麻烦。

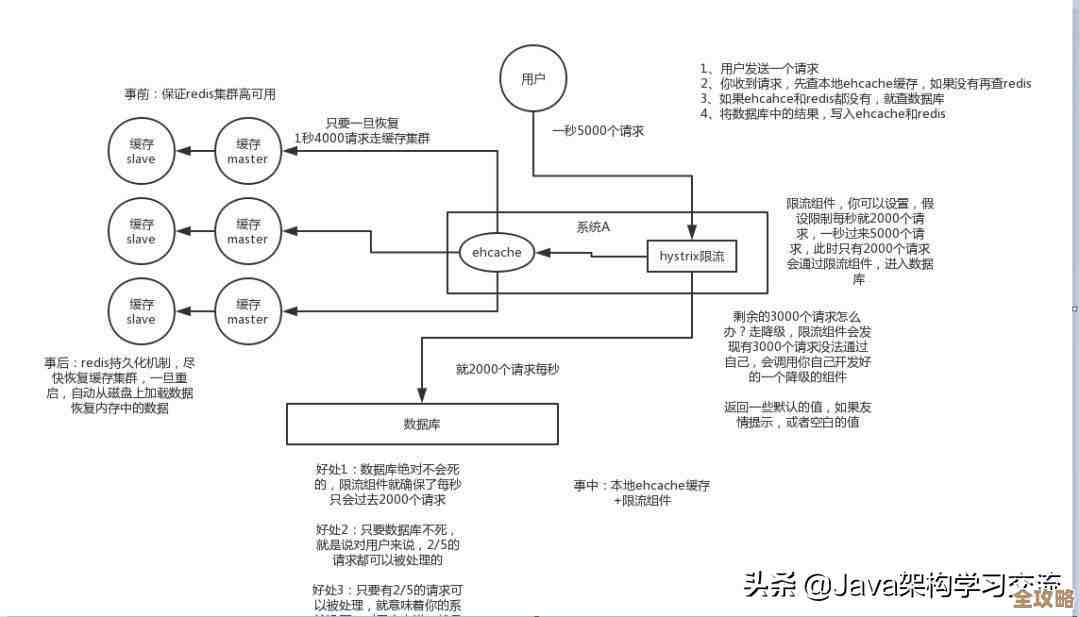

用Redis队列来做这个事,感觉就清爽多了,它的基本想法是把任务和确认分开成两个通道,就像你去银行办业务,先拿个号(任务放入队列),柜员叫到你的号就处理(工作进程从队列取任务),处理完了,你再在另一个本子上签个字(确认信息放入另一个队列),这样,发任务的程序只管发号,它不用一直盯着哪个号被叫了;干活的程序只管叫号干活,干完签个字就行;还有一个专门的角色,就盯着那个签字的本子,看谁办完了,谁一直没签字。

可以这么做:创建一个任务队列,比如叫 task_queue,当有新的任务需要处理时,发任务的程序就简单地把任务内容,可能就是一个JSON字符串,用 LPUSH 命令塞进这个队列的左边,多个工作进程(消费者)就在另一边用 BRPOP 命令等着从队列右边取任务。BRPOP 这个命令的好处是,如果队列是空的,它会一直阻塞等待,直到有任务进来,这样工作进程就不用傻傻地不停去问“有活吗?有活吗?”,节省了资源。

关键的一步是确认机制,不能工作进程说干完了就完了,得有个可靠的记录,在开始处理任务之前,工作进程可以先把任务从一个“待处理”的状态转移出去,一个常见的做法是使用Redis的有序集合(Sorted Set),当工作进程从 task_queue 里取到一个任务时,它同时把这个任务的ID和当前的时间戳(作为分数)加入到另一个有序集合里,比如叫 processing_tasks,这个有序集合就相当于一个“正在处理中”的任务清单。

工作进程就去吭哧吭哧地执行实际的任务逻辑了,比如调用某个接口、处理数据,等任务真正执行成功后,工作进程再把这个任务的ID从 processing_tasks 集合里移除掉(用 ZREM 命令),这样,这个任务就彻底完成了。

那些“反复确认的问题”怎么解决呢?就是对付那些可能因为程序崩溃、网络问题而永远没被确认的任务,这就要靠第三个角色——一个独立的监控进程(或者叫看门狗进程),这个监控进程可以定时运行,比如每隔一分钟跑一次,它的工作很简单:检查那个 processing_tasks 有序集合。

它用 ZRANGEBYSCORE 命令,找出那些分数(也就是开始处理的时间戳)距离现在已经过去很久的任务,比如超过了设定的超时时间(如10分钟),这些任务很可能就是出了问题的“僵尸任务”——干活的工作进程可能已经崩溃了,所以一直没来确认移除。

监控进程找到这些超时任务后,就可以采取行动了,最直接的办法就是把这些任务重新放回最开始的任务队列 task_queue 里,让其他正常的工作进程重新领取并处理,这就相当于给任务一次重试的机会,为了安全起见,可以给每个任务记录一个重试次数,如果重试太多次都失败了,就把它移到一个“失败任务”队列里,报警让人工来处理。

这种模式的好处非常明显,它很解耦,发任务、干活、监控,各干各的,互不干扰,性能很好,Redis的内存操作速度极快,能承受很高的并发,它很可靠,通过有序集合和超时检查,基本上不会丢任务,也能自动处理大部分异常情况,它还很灵活,可以很容易地增加工作进程的数量来提升处理速度,也就是水平扩展很方便。

我记得那个分享的开发者最后总结说,别看这套逻辑简单,但确实解决了他们系统中任务管理的大麻烦,让整个异步处理流程变得可控和透明,确实,有时候一个好的设计,不一定需要多么复杂的技术,用像Redis这样简单高效的工具,就能优雅地解决实际问题。

本文由颜泰平于2026-01-09发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://waw.haoid.cn/wenda/77601.html