硬件加速技术:解锁高效计算新境界的关键路径

- 游戏动态

- 2025-10-11 06:00:12

- 1

好,咱们来聊聊硬件加速技术吧,这话题听起来挺硬核的,但我觉得它其实特别像给电脑“打鸡血”——不是那种按部就班的升级,而是直接换一种思路去解决问题,你想想,普通CPU就像个全能选手,啥都能干,但真遇到重复性的大规模计算,比如训练AI模型或者渲染视频,它就有点力不从心了,毕竟要一边处理指令一边兼顾各种杂事。🤔

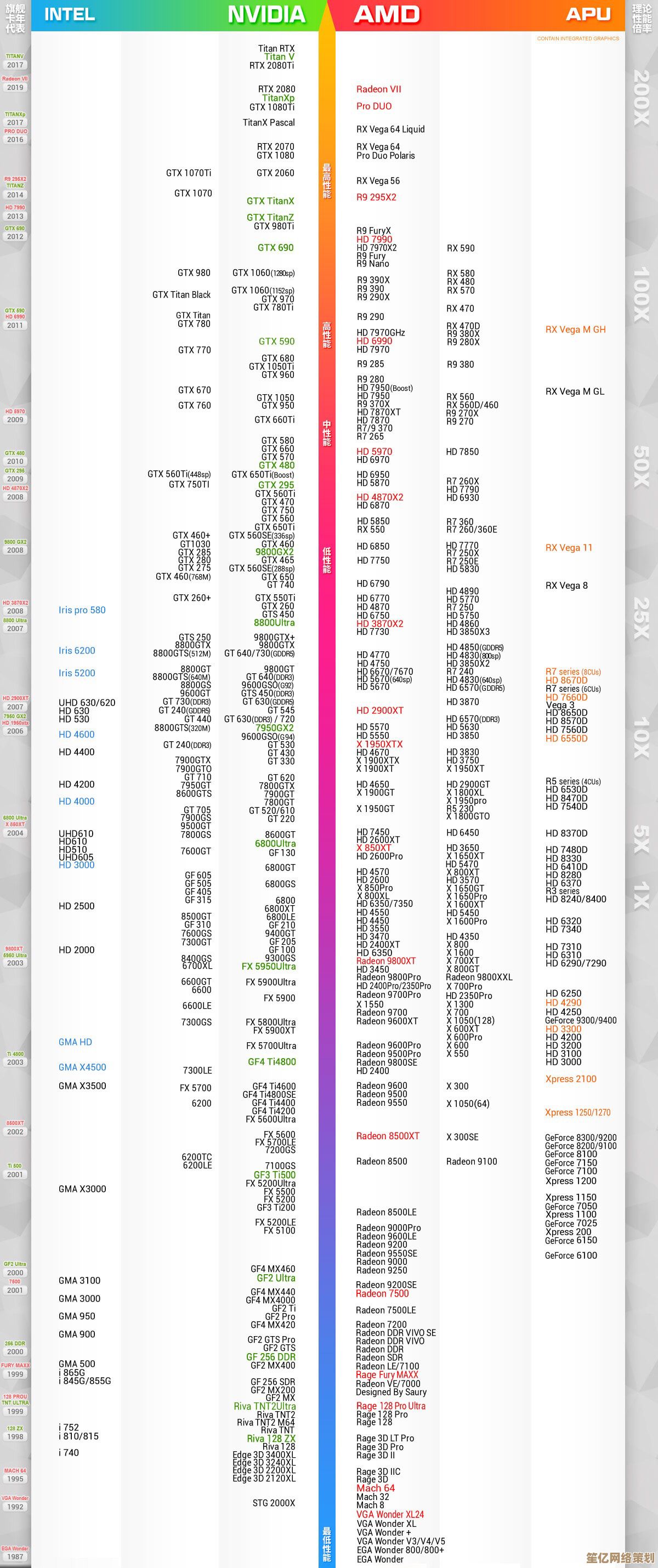

我最早接触硬件加速是因为几年前挖矿热(对,就是比特币那时候),显卡被抢疯了,当时我就纳闷:为什么是GPU而不是CPU更擅长干这个?后来才明白,GPU的设计本质是并行处理——它能同时处理成千上万个简单任务,而CPU更擅长逐个解决复杂逻辑,这种“分工思维”简直颠覆了我对计算效率的认知,比如现在玩AI,没有GPU加速,很多模型训练动不动就得几个月,但用上专用芯片(比如英伟达的A100),可能几天就搞定了,这差距,就像骑自行车和坐火箭的区别吧?🚀

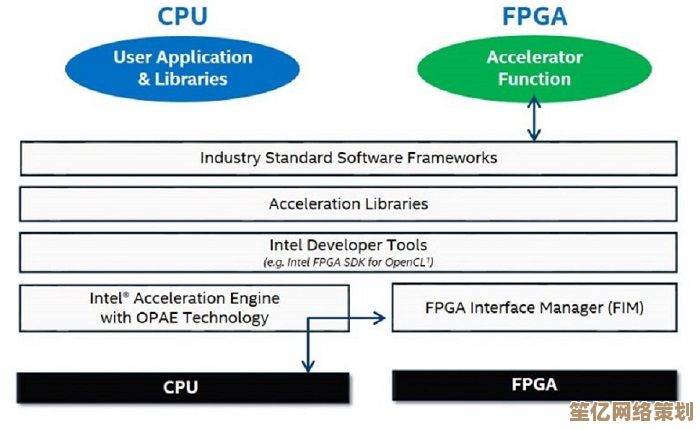

不过硬件加速也不是万能药,我有个做游戏开发的朋友吐槽过,他们团队曾为了优化画面渲染,硬着头皮把部分计算塞进FPGA(可编程芯片),结果调试到头皮发麻——因为硬件一旦定型,改起来比软件麻烦多了,但最后效果确实惊艳:画面延迟降低了40%,玩家反馈说“流畅得不像同一款游戏”,这种又爱又恨的感觉,大概就是技术迭代的常态?💻

还有个例子是苹果的M系列芯片,它把CPU、GPU、神经网络引擎全塞进一块SOC里,让内存共享,减少数据搬运的损耗,我用M1 MacBook写代码时,能明显感觉到编译速度比英特尔时代快了一截,而且风扇居然不怎么转!这种“悄无声息的高效”背后,其实是硬件加速思维渗透到了芯片设计的毛细血管里,苹果的封闭生态也让人又爱又恨——你只能跟着它的节奏走,但不得不承认,它确实把软硬件协同做到了极致。🍎

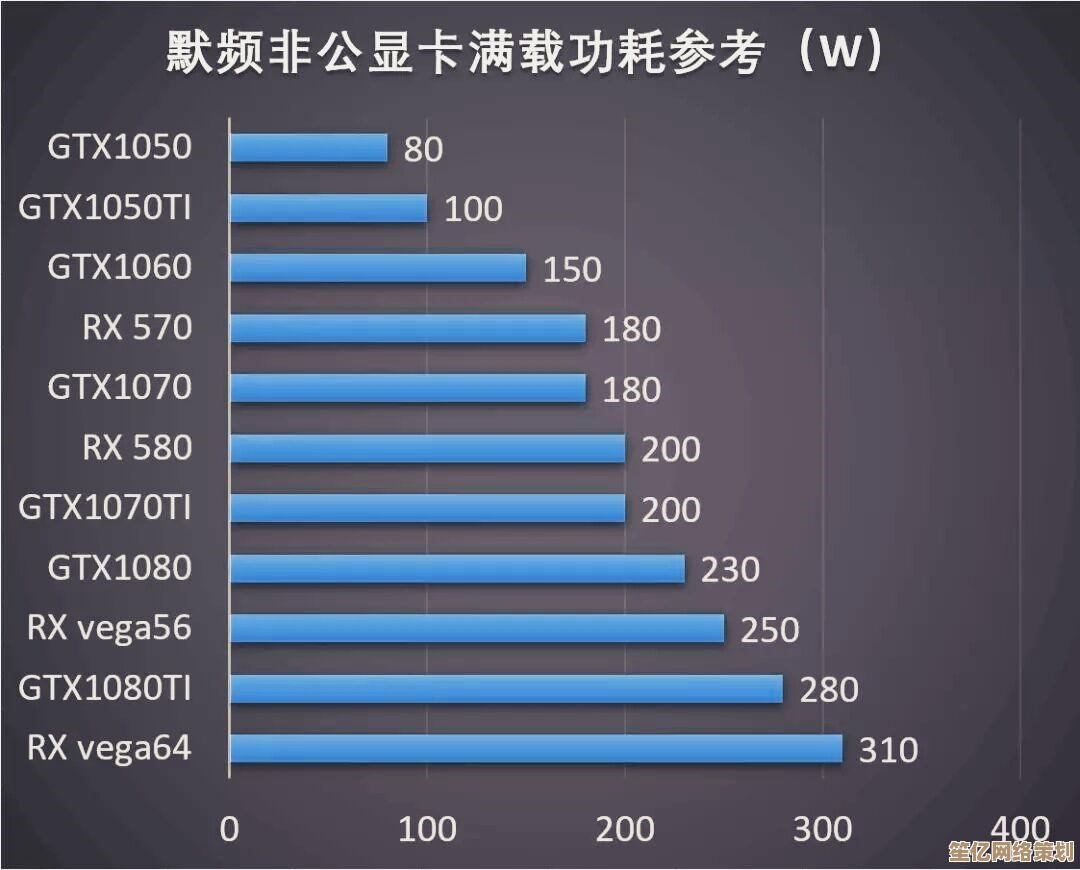

不过话说回来,硬件加速的“坑”也不少,比如专用芯片成本高、灵活性差,可能今年火的AI模型,明年就需要新的架构支持,而且功耗问题一直是个暗雷——有些加速卡跑起来像电暖器,电费蹭蹭涨🌡️,所以我觉得,未来的关键路径可能不是一味追求“更专的硬件”,而是如何让通用和专用计算动态平衡,就像交响乐团里指挥协调不同乐器一样。

硬件加速技术正在把计算从“能跑”变成“飞驰”,但这条路得一边试错一边走,有时候我觉得,技术进化就像玩拼图,你永远不知道下一块会带来什么惊喜——或者麻烦(笑),但正是这种不确定性,才让搞技术的人又头疼又上瘾吧?🧩

本文由呼沛容于2025-10-11发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://waw.haoid.cn/yxdt/23730.html