MySQL报错ER_IB_MSG_LOG_CHECKPOINT_FOUND导致故障,远程帮忙修复问题中

- 问答

- 2026-01-25 01:54:30

- 4

MySQL报错ER_IB_MSG_LOG_CHECKPOINT_FOUND导致故障,远程帮忙修复问题中

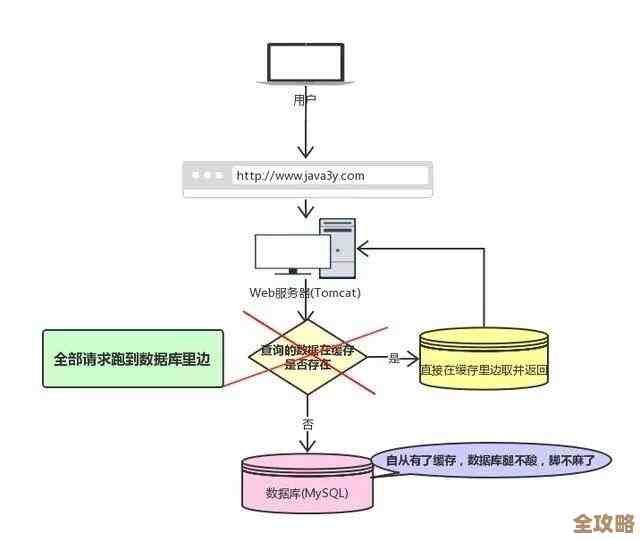

这次遇到的是一个关于MySQL数据库启动失败的紧急情况,用户那边反馈说数据库服务器意外重启后,MySQL服务怎么也启动不起来了,查看错误日志,里面反复出现一条让人头疼的记录:“ER_IB_MSG_LOG_CHECKPOINT_FOUND”,这条错误信息,用简单的话来说,就是MySQL数据库的核心存储引擎InnoDB在尝试恢复数据时,在它的重做日志文件里发现了一个检查点记录,但这个发现过程本身可能意味着日志文件出现了不一致或损坏,导致恢复流程卡住,无法继续,数据库就这么一直僵在那里,启动失败,上面的所有应用自然也就全部中断了。

根据MySQL官方文档和许多技术社区(例如Percona、MariaDB的知识库以及阿里云、腾讯云等云服务商发布的故障处理案例)的记载,这个错误通常指向InnoDB的重做日志系统出了问题,InnoDB引擎为了保证数据的安全和崩溃恢复能力,会把所有即将发生的数据变更先写到一种叫做“重做日志”的文件里,而不是直接修改硬盘上的数据页,日志文件中会有一些被称为“检查点”的特殊标记,用来告诉数据库恢复时应该从哪个位置开始,当InnoDB在启动过程中,试图定位最新的有效检查点来开始恢复时,如果它读取到的信息是混乱的、矛盾的或者指向了不存在的日志区域,就会抛出这个ER_IB_MSG_LOG_CHECKPOINT_FOUND错误,常见的原因包括:服务器在写入日志时突然断电或系统崩溃,导致日志文件只写了一部分,形成了所谓的“残缺页”;或者是磁盘本身出现了坏道,损坏了日志文件的内容;也有可能是某些极端情况下,多个日志文件之间的顺序和关联被破坏。

远程协助处理这个问题,首要原则是:尽可能保住数据,第一步绝对不是贸然去删除或修改任何文件,我们通常会要求用户先对整个MySQL的数据目录(尤其是ibdata1、ib_logfile0、ib_logfile1等核心文件)进行完整的磁盘级备份,哪怕是用压缩工具打个包也好,以防修复操作不当导致情况恶化。

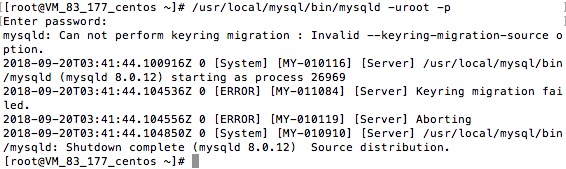

会尝试使用MySQL自带但有一定风险的工具进行修复,根据MySQL官方手册中关于InnoDB恢复的章节,一个关键的步骤是尝试利用InnoDB引擎的强制恢复能力,这需要通过修改MySQL的配置文件my.cnf,在[mysqld]部分下添加一行指令:innodb_force_recovery = 6,这个参数的值从1到6,代表强制恢复的强度等级,6是最高级别,设置后启动MySQL,InnoDB会尝试跳过一些恢复环节,比如回滚未完成的事务等,以只读模式启动服务,这个过程中,它可能会忽略掉一些日志错误,如果能够启动成功,那么首要任务就是立即使用mysqldump等逻辑备份工具,将所有数据库的数据以SQL语句的形式导出备份,这是一次“抢救性”的备份,因为数据库处于强制恢复模式下,可能是不稳定的,不能用于正常业务。

如果连强制恢复模式都无法启动,那么问题可能更严重,根据一些资深数据库工程师在个人博客和技术论坛(如Stack Overflow)上分享的经验,有时需要手动干预日志文件,一个可能的方法是:安全地移除旧的日志文件(即重命名或移动到备份位置ib_logfile0和ib_logfile1),然后尝试以默认配置启动,这时,InnoDB会发现没有重做日志文件,从而尝试创建全新的、干净的一套。这是一个非常危险的操作,因为重做日志里可能包含尚未写入数据文件的更改,这样做之后,即使数据库能启动,也极有可能造成数据丢失或数据表损坏,数据库启动后,必须立即对所有的表执行检查修复操作,例如使用CHECK TABLE和REPAIR TABLE命令,或者使用mysqlcheck工具,很多情况下,用户报告在采取此步骤后,数据库得以重新上线,但部分表需要修复,且自上次完整检查点之后的数据变更可能会永久丢失。

在整个远程协助过程中,沟通非常重要,需要向用户清晰地解释每一步操作的目的和潜在风险,获取他们的明确同意,也要引导他们查看操作系统日志(如dmesg)以排除硬件故障,并建议他们在问题解决后,务必加强备份策略(如定期全量备份和二进制日志备份),并考虑配置不同断电源(UPS)或使用更高可靠性的存储设备,以防止类似因突然断电导致的日志损坏问题再次发生,整个处理过程,实际上是一场与时间赛跑的数据抢救行动,核心思路就是先想方设法让数据库“活”过来以导出数据,再重建一个健康的环境。

本文由盘雅霜于2026-01-25发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://waw.haoid.cn/wenda/85440.html