Redis里那些热点数据到底咋设置才靠谱,方案和思路聊聊

- 问答

- 2026-01-19 13:13:20

- 4

说到Redis里热点数据的设置,这确实是个挺关键的事儿,处理好了,系统嗖嗖快;处理不好,关键时刻就卡壳,咱们今天就不整那些高大上的术语,就聊点实在的思路和方案。

啥是热点数据?先得把它揪出来

咱得明白咱们要对付的是谁,热点数据,说白了就是被访问得特别频繁的那一小撮数据,它可能是某个明星的一条爆款微博、一场热门直播的房间信息、一个秒杀商品的具体详情,或者是一个全站通用的配置项,它的特点就是“二八定律”的极端体现:可能不到1%的数据,承载了超过90%的访问压力。

所以第一步,不是急着往Redis里塞,而是要想办法把这家伙找出来,一般有几种路子(根据《Redis开发与运维》等资料里的常见方法):

- 业务预估:这是最直接的方法,比如你要搞秒杀,那秒杀商品的信息和库存肯定是热点;要做排行榜,排名前一百的数据就是热点,根据业务经验,提前把它们圈定出来。

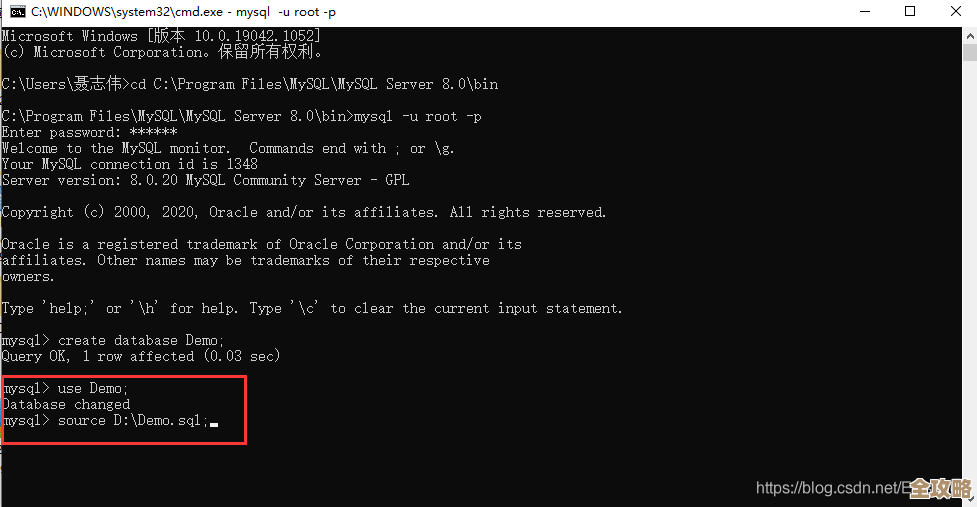

- 数据统计分析:系统跑起来之后,通过监控工具来分析,可以用Redis自带的

monitor命令(生产环境慎用,影响性能)或者更专业的APM(应用性能管理)工具,看哪些key被访问的次数最多,也有些公司会在大数据平台对访问日志进行分析,精准定位热点key。 - 客户端记录:在业务代码里埋点,记录对Redis每个key的访问频次,然后上报分析。

把热点数据识别出来,咱们才能对症下药。

热点数据放Redis,关键是怎么“放”

找出了热点,接下来就是怎么在Redis里安排它了,这里面的讲究可多了。

过期时间设置:别让它“长生不老”

给热点数据设置过期时间(TTL)是非常非常重要的一个好习惯,千万别觉得热点数据重要就设置成永不过期,这有很大的风险,万一将来业务变化,这个数据不再是热点了,或者数据本身出了错,永不过期就意味着它会一直占着内存,还可能把错误数据返回给用户。

那过期时间设多久合适呢?这没固定答案,得看业务场景。

- 对于实时性要求高的:比如秒杀库存,可能就设几分钟甚至更短,秒杀结束就失效。

- 对于相对稳定但访问频繁的:比如商品基本信息,可以设得长一点,比如1小时或几小时,同时配合后续要讲的“更新策略”来保证数据最终是对的。

- 核心思路是:在保证数据一致性可接受的前提下,尽量设置过期时间,这既是内存管理,也是一种容错机制。

数据结构的选型:用对的工具干对的活

Redis不是只有简单的key-value,它提供了丰富的数据结构,用对了能极大提升效率和节省空间。

- 原始数据:如果就是一个简单的用户信息(JSON字符串),那用普通的

string类型就行。 - 频繁更新的字段:如果热点数据里只有个别字段老变,比如商品的库存数、文章的点赞数,就别整个对象来回序列化覆盖了,直接用

hash(哈希)结构,只更新那个特定的field,效率高得多。 - 排行榜类热点:直接用

zset(有序集合),天生就是干这个的,取Top N效率极高。 - 防止重复请求:比如防止用户重复点赞,可以用

set(集合)来存用户ID。

选对数据结构,能让你的操作更快,更省内存。

应对极端热点:单个Key过热怎么办?

有时候会遇到一种更极端的情况,叫做“热点Key问题”,就是一个Key本身太热了,所有的请求都奔着它去,导致这个Key所在的那台Redis服务器单点压力巨大,网卡都可能被打满,比如顶流明星发布一条新微博,这条微博的评论数统计Key就会成为超级热点。

对于这种情况,就得用点“特殊手段”了:

- 本地缓存+随机过期时间:这是非常有效的一招,在应用服务器本地(比如JVM里),用Guava Cache或Caffeine等本地缓存库,也存一份热点数据,这样大部分请求根本不用走到Redis,直接在本地就返回了。关键点:给本地缓存设置一个不太长的、并且带点随机性的过期时间(比如基础5秒,加上一个0-2秒的随机值),避免所有服务器上的缓存同时失效,导致请求瞬间全部压到Redis上(缓存雪崩)。

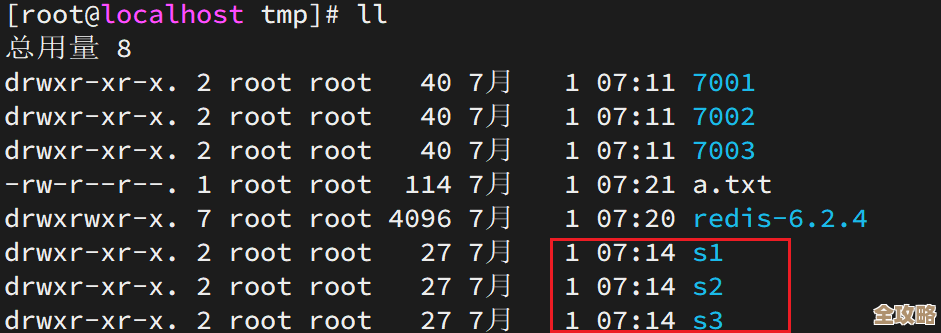

- 备份Key:把一个热点Key,在程序里拆成多个Key,比如原本叫

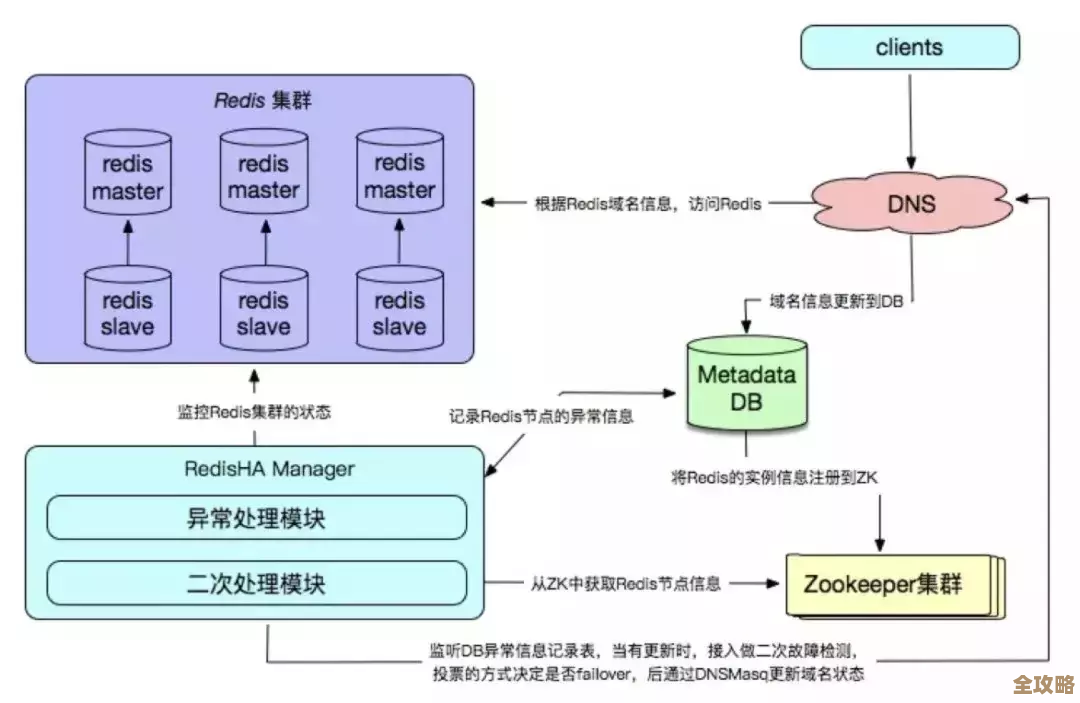

hotkey:123,现在在程序里随机存成hotkey:123_1、hotkey:123_2...hotkey:123_n,分散到Redis的不同slot上(如果用的是集群模式),读取的时候也随机选一个来读,这个方法能分散压力,但会增加代码的复杂性。 - 使用Redis集群模式:这算是基础设施层面的保障,通过集群将数据分片,即使有热点Key,只要这个Key没大到把一个分片的网络带宽或CPU打满,整个集群就还能扛得住,但这要求热点Key不能太多太集中。

保证数据别出错:缓存和数据库的一致性

热点数据更新的时候,还得考虑怎么让它和数据库里的真实数据保持一致,常见的思路有几种:

- 先更新数据库,再删除缓存:这是推荐的做法,为啥是删除缓存而不是更新缓存?因为删除更简单、更安全,如果先删缓存再更新数据库,在并发高的时候容易把旧数据再塞回缓存,而先更新数据库再删缓存,即使删缓存失败了,顶多就是下次读的时候延迟一点读到新数据(缓存穿透后从DB加载),但不会出现长期存的都是脏数据,可以给缓存删除加上重试机制,比如通过消息队列,提高成功率。

- 给热点数据设置较短的过期时间:这算是一个兜底方案,即使更新失败,数据很快也会过期,下次读取时从数据库加载新的,实现了“最终一致”。

总结一下

处理Redis热点数据,不是一个单点动作,而是一个小系统工程。核心思路识别热点 -> 合理设置(过期时间、数据结构)-> 防范单点过热 -> 保障数据一致。

最实在的建议就是:一定要结合你自己的业务来,没有放之四海而皆准的万能参数,多测试、多监控,根据实际情况调整你的策略,通过监控Redis的内存使用、Key数量、命中率、慢查询等指标,你就能知道当前的设置是否合理,是否需要优化。

本文由凤伟才于2026-01-19发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://waw.haoid.cn/wenda/83683.html