K8s用着挺累的,是不是该找个更简单点的替代方案了?

- 问答

- 2026-01-19 06:28:41

- 2

(一位资深开发者在技术社区发帖)

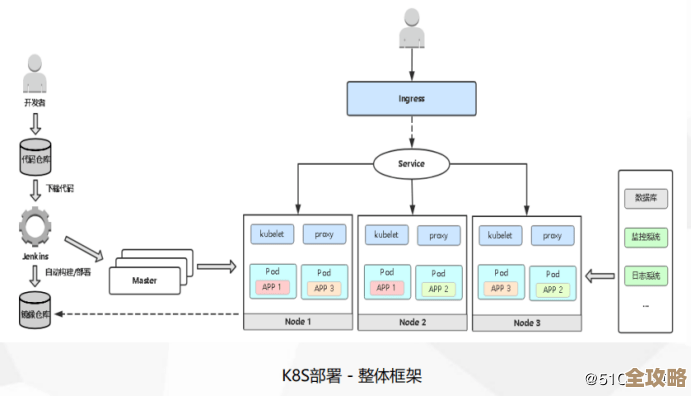

“最近半年团队把部分服务迁到了Kubernetes上,本来想着能自动扩缩容、简化部署,结果每天光维护集群就耗掉大量精力,YAML配置越写越复杂,节点故障排查像侦探破案,CI/CD流水线动不动因为资源问题卡壳,我在想:中小团队真的需要这么重的方案吗?是不是该换个更轻量的替代品了?”

这种困惑在技术圈并不罕见,Kubernetes(常简称为K8s)作为容器编排的事实标准,确实能解决大规模应用的部署难题,但它的复杂性也让许多团队陷入“杀鸡用牛刀”的尴尬,要判断是否应该转向更简单的方案,不妨先看看那些选择“逃离K8s”的团队经历了什么。

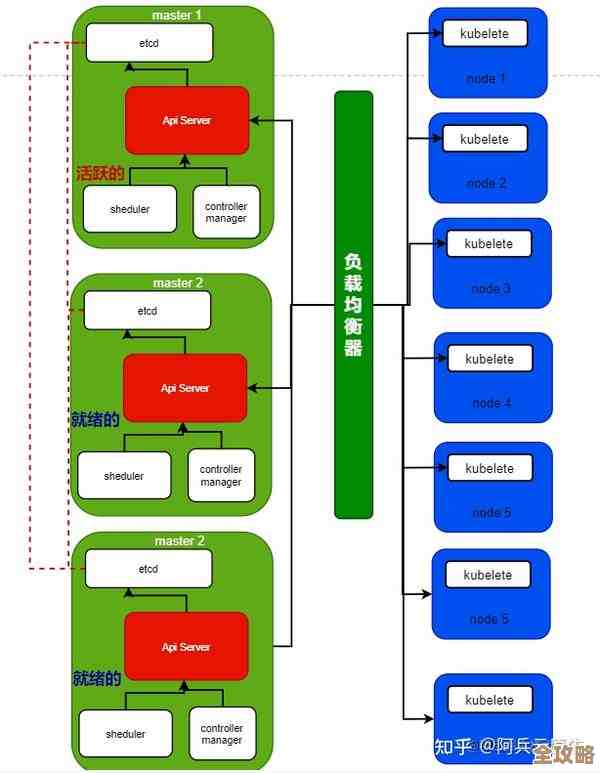

当简洁性被吞噬:K8s的隐性成本

云原生专家Kelsey Hightower曾直言:“Kubernetes是一个平台,用来构建平台的平台。”(引自2017年O'Reilly会议演讲)这句话恰恰揭示了问题本质——K8s本身并非开箱即用的解决方案,而是需要大量定制开发的底层框架,对于只需要部署十几个微服务的团队而言,光是维护Ingress控制器、监控栈、安全策略就需要投入专职运维人员,有团队自嘲说:“我们花了三个月搭建K8s,结果发现只是在重复云厂商已经提供的管理服务。”

更现实的问题是排查故障的链式反应,当某个Pod频繁重启时,工程师可能需要依次检查容器日志、节点资源、网络策略、存储卷状态,甚至内核参数,相比之下,传统虚拟机部署虽然“笨重”,但问题边界更清晰,日本某电商团队在技术博客中分享,从K8s回迁到AWS ECS后,平均故障解决时间从4小时缩短到30分钟,因为“调试逻辑从分布式追踪简成了查看单个服务日志”。

轻量级替代方案的崛起

正是看到这些痛点,近年来涌现出许多“去K8s化”方案,HashiCorp Nomad强调“简单至上”,用一份配置文件同时支持容器、虚拟机、二进制应用部署;AWS Fargate则直接让服务器隐形,开发者只需关注容器镜像本身;甚至Docker Compose也在升级后能支撑中小规模生产环境。

这些方案共同特点是“减负”,比如Nomad的配置文件通常只有K8s YAML的三分之一长度,且无需理解Pod、Deployment等抽象概念,德国自动化公司Robocorp的案例显示,他们将K8s集群替换为Nomad后,资源利用率从25%提升到60%,因为“不用再为系统组件的资源预留发愁”。

决策关键:你的团队到底需要什么?

选择技术栈本质上是权衡的艺术,如果业务符合以下特征,K8s可能仍是合理选择:

- 服务数量超过50个,且需要分钟级弹性扩缩

- 混合云部署需求强烈,需要跨机房调度

- 团队有专职SRE且具备K8s认证资质

但如果现状更接近这些场景,则值得考虑简化方案:

- 团队规模小于20人,开发人员兼运维工作

- 业务波动平稳,夜间资源闲置率超过40%

- 核心诉求只是快速迭代而非尖端编排功能

回归初心:技术为业务服务

美国在线教育平台Udemy曾公开分享过一段经历:他们为某个新业务搭建了完善的K8s平台,后来发现该业务日均访问量仅千人级别,维护成本远超收益,技术负责人反思:“我们被‘云原生’的光环迷惑,忘了先问‘为什么要用这个技术’。”(据TechCrunch 2022年报道)

包括Basecamp、37signals在内的知名公司至今仍采用单体架构+基础部署的方式支撑百万用户,它们的工程师文化强调“用最简单方案解决90%问题”,这种思路在过度工程化盛行的今天显得尤为珍贵——当我们纠结于Helm Chart版本兼容性时,或许该停下来想想:用户真的在乎你的应用是否跑在Service Mesh上吗?

K8s无疑是强大的工具,但就像电锯之于木匠:砍树效率惊人,雕刻小物件却可能伤手,如果团队已经感受到维护负担超过收益,不妨大胆评估替代方案,技术决策没有绝对正确,只有是否匹配当下阶段,毕竟,最好的架构不是最复杂的那个,而是让团队能专注创新而非运维的那个。

本文由酒紫萱于2026-01-19发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://waw.haoid.cn/wenda/83505.html