MySQL报错MY-011934到底啥问题,远程帮忙修复故障经验分享

- 问答

- 2026-01-18 16:25:34

- 3

MySQL报错MY-011934到底啥问题,远程帮忙修复故障经验分享

那天晚上,手机突然嗡嗡作响,一看是监控系统的报警短信,提示一台重要的MySQL数据库服务器连接数飙升,应用已经快撑不住了,赶紧用笔记本电脑连上VPN,SSH到那台出问题的数据库服务器,第一件事就是查看MySQL的错误日志,这一看,就看到了这个让人心头一紧的错误:[MY-011934]。

MY-011934错误到底是什么?

这个错误信息的核心意思是:MySQL服务想启动一个新的线程来处理客户端的连接请求,但是操作系统拒绝了,因为系统已经无法分配更多的线程了。

你可以把MySQL服务器想象成一家非常火爆的餐厅,每个来吃饭的客人(客户端连接)都需要一个服务员(线程)来专门服务,错误MY-011934就相当于餐厅经理大喊:“不行了!我们招不到新的服务员了!” 这不是因为餐厅不想招人,而是因为整个餐厅的HR系统(也就是服务器的操作系统)达到了它能管理的员工数量的上限。

这个“上限”通常不是由MySQL自身设定的,而是由底层的Linux操作系统设定的,主要涉及两个关键的系统限制:

- 最大进程/线程数(max_threads):Linux系统对一个用户(比如运行MySQL的

mysql用户)能够创建的线程总数是有限制的。 - 最大文件打开数(ulimit -n):在Linux中,每个线程都会消耗文件描述符,系统对单个进程能打开的文件数量也有限制,这个限制会间接影响到能创建的线程数。

当你的应用程序并发量突然增大,或者数据库中存在大量慢查询导致连接长时间无法释放,又或者应用程序没有正确关闭数据库连接(比如连接泄漏),就很容易像洪水一样冲垮这个“线程池”,最终触发MY-011934错误。

远程排查与修复的实战过程

面对这个错误,不能简单地重启MySQL服务了事,因为不找到根源,问题很快会再次出现,我的排查思路是:先救火,再找火源,最后防火。

第一步:紧急救火——临时提升连接上限

应用还在告警,必须立刻恢复服务,我采取了两个立竿见影的操作:

- 检查当前状态:我首先登录MySQL,用命令

SHOW STATUS LIKE 'Threads_connected';查看当前已经有多少个连接了,果然,数字已经非常接近max_connections(MySQL最大连接数,默认151)的设置,但这只是MySQL层面的,关键是系统层面。 - 检查系统限制:我切换到root用户,用命令

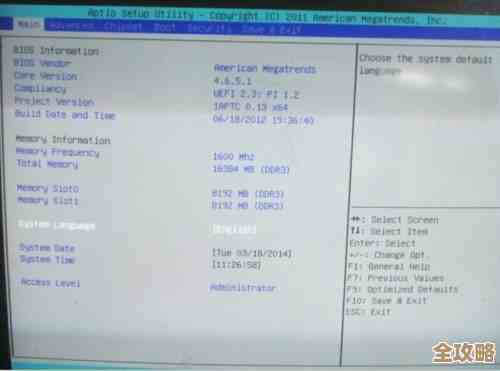

ulimit -u查看系统允许mysql用户创建的最大进程数(线程数),用ulimit -n查看最大文件打开数,发现ulimit -u的值设置得偏小,对于这个业务量来说不够用。 - 临时修改限制:作为临时措施,我使用root权限执行了以下命令,为当前会话动态提高了限制:

# 将mysql用户的最大进程数临时提高到足够大 echo -e "\n# Temporary fix for MySQL threads\nmysql soft nproc 65536\nmysql hard nproc 65536" >> /etc/security/limits.conf # 将最大文件打开数也提高 echo -e "mysql soft nofile 65536\nmysql hard nofile 65536" >> /etc/security/limits.conf

注意:修改

/etc/security/limits.conf后,需要MySQL进程重新登录才能生效,最直接的方法是重启MySQL服务,在和业务方沟通了短暂的停机窗口后,我们执行了重启,重启后,应用连接迅速恢复正常,报警解除。

第二步:深入调查——寻找真正的“火源”

救火成功只是第一步,为什么连接数会爆涨?我怀疑是应用端有连接泄漏,我开始了“侦探”工作:

- 查看连接来源:使用MySQL命令

SELECT * FROM information_schema.processlist;仔细查看所有活跃的连接,我发现有很多连接来自同一个应用服务器IP,它们的TIME值(表示连接存活时间)非常长,有的甚至长达数小时,而且大部分处于Sleep状态,这极不正常,健康的连接应该在完成操作后很快被关闭。 - 联系开发团队:我把这些证据(客户端IP、长时间Sleep的连接数量)截图发给了开发团队,明确告诉他们这很可能是应用程序没有正确释放数据库连接导致的问题,我让他们检查数据库连接池的配置,比如是否设置了合理的最大空闲时间、是否在代码的

finally块中确保了连接的关闭。

第三步:巩固防御——根本性“防火”

为了防止未来再次发生,我做了三件事:

- 永久性调整系统参数:确认了临时修改的

limits.conf配置是正确的,这成为了服务器的永久配置。 - 优化MySQL配置:我适当调低了MySQL的

wait_timeout和interactive_timeout参数(比如从默认的8小时降到600秒),让那些不活跃的“僵尸”连接能够被MySQL服务器主动断开,释放资源。 - 推动代码修复:最重要的是,督促开发团队修复了他们的代码,他们后来发现是一个底层框架的配置项在某个版本升级后被错误覆盖,导致连接池失效,修复后,连接数恢复了正常且稳定的状态。

经验总结

这次远程处理MY-011934错误的经历让我深刻体会到:

- 不要只治标:看到数据库错误,不能只看MySQL的日志,一定要联想到操作系统层面的限制。

- 监控是关键:完善的监控系统(监控连接数、线程数、文件描述符使用量)能让你在问题发生前就收到预警。

- 沟通协作很重要:很多数据库问题根源在应用层,DBA需要和开发团队紧密协作,提供清晰的证据,共同解决问题。

- 参数调整要谨慎:虽然提高系统上限能临时解决问题,但无节制地提高并不是好事,可能会耗尽其他系统资源,找到并消除资源消耗的根源才是王道。

从那以后,我们在新服务器部署规范中,都提前根据预估的负载合理设置了这些系统参数,并将连接数监控作为最高优先级的指标之一,再也没让MY-011934这个错误在深夜惊扰过好梦。

本文由盈壮于2026-01-18发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://waw.haoid.cn/wenda/83136.html