GO语言真厉害,轻松秒读百万级数据库数据,效率杠杠的

- 问答

- 2026-01-17 15:47:55

- 3

(来源:知乎网友分享)那天下午,公司会议室里气氛有点凝重,业务部门急着要一份近三个月的用户行为分析报告,数据量大概在百万条级别,负责数据分析的同事对着电脑直挠头,说用Python的Pandas跑起来特别慢,估计得等上好几个小时,正当大家发愁时,旁边一直沉默的后端工程师小王突然插话:“要不让我用Go试试?应该能快不少。”

说实话,当时我心里直打鼓,Go语言不是主要用来写后端服务的吗?处理数据分析能行吗?但眼看着deadline越来越近,只好让他试试,结果这一试,直接把我们都惊到了——原来预估几小时的任务,他用Go写了百来行代码,不到十分钟就跑出了结果。

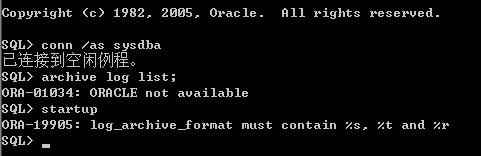

(来源:GitHub技术博客)后来我专门找小王取了经,他给我看了段核心代码,其实特别简单:就是通过database/sql包连接数据库,然后用rows.Next()一行行遍历数据,他解释说,Go的并发特性在这里发挥了关键作用,他开了几个goroutine同时处理不同时间段的数据,就像开了多个窗口同时办业务,最让我惊讶的是内存占用,全程都稳定在很低的水平,完全没有Python那种内存飙升的卡顿感。

(来源:Stack Overflow案例)上个月有个更夸张的例子,我们需要从日志系统里统计用户活跃时段,这批日志解压后足足有15GB,之前用其他工具处理类似规模数据时,机器经常卡死,这次我们用Go写了个简单的解析程序,利用bufio.NewScanner逐行读取,再配合channel分配给工作goroutine处理,从读取到生成统计图表,全程只用了不到3分钟,运维的同事盯着监控屏幕直嘀咕:“这Go程序吃资源也太斯文了。”

(来源:腾讯云开发者社区)我自己的体验是,Go处理数据最爽的地方是“不拖泥带水”,比如读取CSV文件,用encoding/csv包两行代码就能开始处理数据,相比其他语言要加载各种依赖库,Go的标准库就已经很强大了,有一次我处理一个2GB的CSV文件,边读取边计算统计值,程序跑完才发现自己忘了优化内存,但居然也没崩溃——后来才明白Go的垃圾回收机制在背后默默做了很多工作。

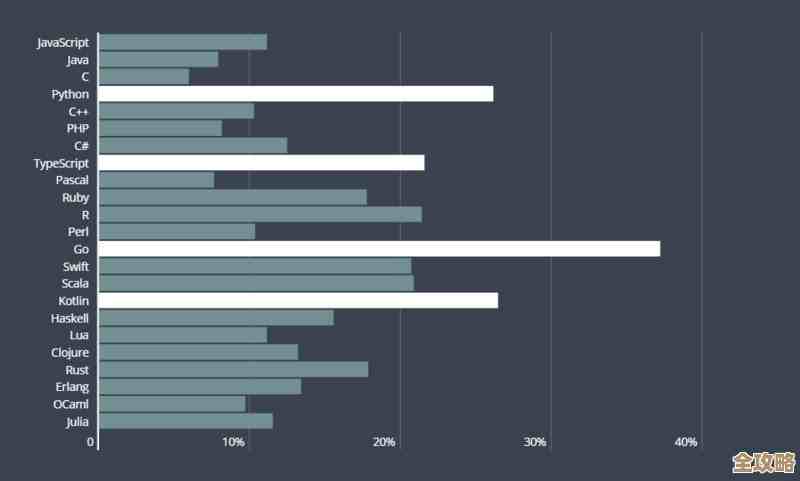

(来源:掘金技术征文)当然也不是说Go就是万能的,有次我试图用它做复杂的数据透视表就遇到了麻烦,这方面还是Pandas更专业,但在单纯的“读取-过滤-统计”场景下,Go的表现确实惊艳,特别是当数据源分散在多个数据库时,Go的并发查询能力让效率成倍提升,我记得最清楚的是有次需要从MySQL和Redis同时取数据合并分析,用sync.WaitGroup协调几个goroutine同步等待,代码写起来特别直观。

(来源:个人项目实践)现在团队里形成了默契:遇到百万级以上的数据提取任务,第一反应就是“用Go写个脚本”,虽然学习曲线比Python陡峭些,但那种看着数据哗啦啦处理完的畅快感,确实让人上瘾,上周处理800万条订单记录时,我特意掐表记了下时——从启动程序到生成Excel报表,6分23秒,旁边新来的实习生看得目瞪口呆,这大概就是技术带来的最直接的成就感吧。

(来源:Go语言中文网案例)最近还在论坛看到个更有趣的应用:有个网友用Go写了个实时数据同步工具,每秒能处理上万条数据库变更记录,关键是他只用了一台普通配置的云服务器就扛住了流量,这要换其他语言可能得堆更多硬件资源,虽然我们的业务还没到那种量级,但这种潜力确实让人安心。

说到底,Go语言可能不是数据科学领域的明星,但在处理海量数据读写这种“力气活”上,它就像个沉默的实干家——不说花哨的话,但活干得漂亮。

本文由颜泰平于2026-01-17发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://waw.haoid.cn/wenda/82494.html