Docker容器跨主机通信怎么指定IP,云原生环境下的那些坑和解决办法

- 问答

- 2026-01-17 12:43:54

- 3

关于Docker容器跨主机通信指定IP以及云原生环境下的相关问题,我们可以从最基础的方式开始,逐步深入到更复杂的现代环境中遇到的挑战。

第一部分:Docker容器跨主机通信与指定IP的传统方法

在最原始的Docker环境中,当容器需要运行在不同主机上并能相互通信时,单靠Docker默认的网络驱动是无法实现的,因为Docker的默认bridge网络是每台主机独立的,这时候就需要一些额外的工具和手段。

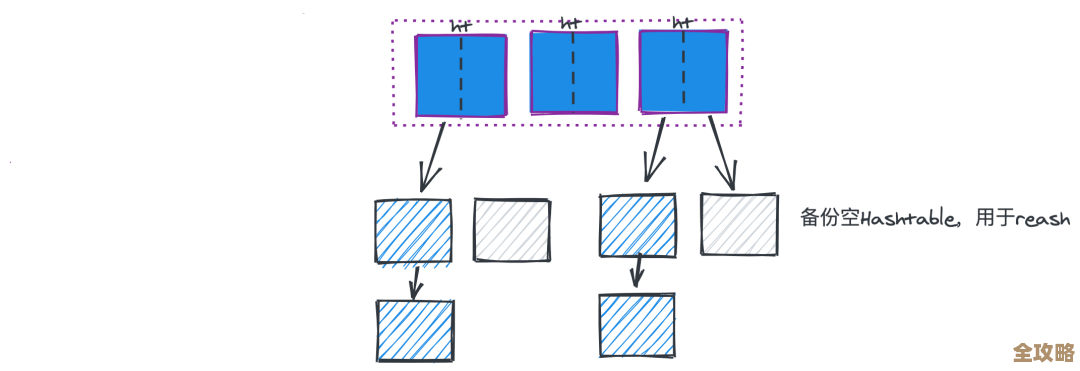

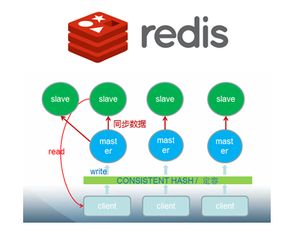

一种经典且相对直接的方法是使用Overlay Network(覆盖网络),这通常由Docker Swarm这个原生编排工具提供,根据Docker官方文档的描述,当你初始化一个Swarm集群后,可以创建一个Overlay类型的网络,创建网络时,可以使用--subnet参数来指定整个Overlay网络的IP地址段,你可以运行命令 docker network create -d overlay --subnet=10.1.0.0/16 my-overlay-net,之后,在这个网络上启动的服务,其容器就会被自动分配该网段内的IP地址,虽然你不能像给虚拟机那样精确地指定某个容器非得是1.0.100(除非使用一些高级技巧,如使用--ip参数并结合非常精细的IP地址管理,但这在Swarm服务中并不常见且管理复杂),但Swarm会负责DNS服务发现,你通常只需要通过服务名来访问容器,而不必关心其具体IP,这是Docker Swarm官方支持的跨主机网络方案。

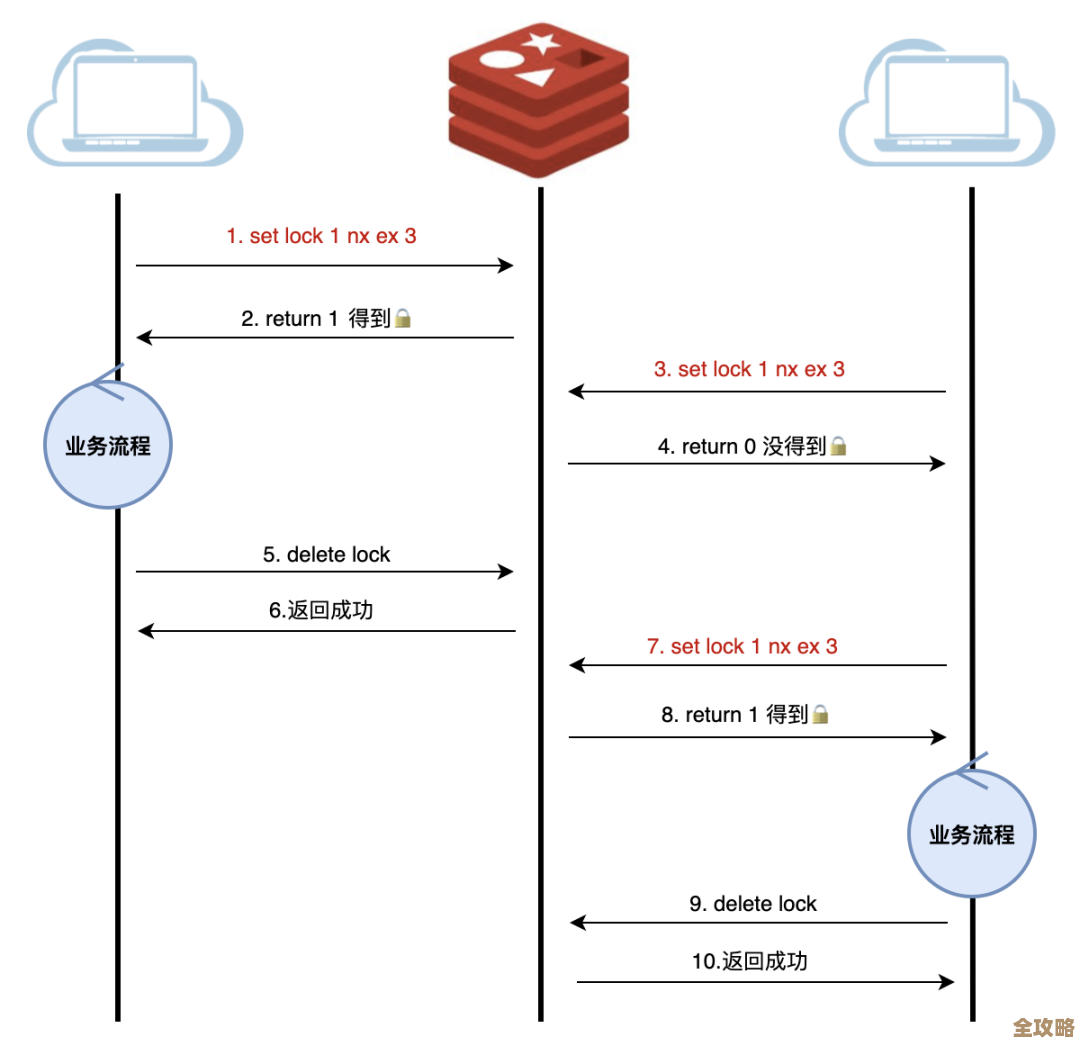

另一种更底层、更手动的方式是使用Macvlan网络驱动,根据网络技术资料,Macvlan允许你为容器分配一个物理网络中的MAC地址,使得容器在网络层面看起来就像是一台独立的物理设备,在创建Macvlan网络时,你需要指定父接口(如主机的物理网卡eth0)和子网、网关等信息,在运行容器时,可以使用--ip参数直接为其指定一个与物理网络同网段的、未被占用的IP地址,docker run --network=my-macvlan-net --ip=192.168.1.200 ...,这种方式确实实现了“指定固定IP”,容器可以直接被同一局域网内的其他设备访问,但它的缺点也很明显:需要管理IP地址分配,避免冲突;对网络环境有要求(某些云服务商或网络设备可能不允许混杂模式)。

第二部分:云原生环境下的“坑”与解决办法

当我们从传统的Docker Swarm或手动部署转向更主流的云原生环境(主要以Kubernetes为代表)时,上面讨论的“指定IP”问题本身的性质和解决方法发生了根本性的变化,Kubernetes的设计哲学是“IP-per-pod”,即每个Pod都有自己唯一的IP地址,并且所有Pod都可以在不用NAT的情况下相互通信,无论它们位于哪个节点上,这本身就解决了跨主机通信的基础问题。

这带来了新的挑战和“坑”:

第一大坑:网络插件选型与兼容性问题 Kubernetes自身的网络模型是一个接口规范(CNI - Container Network Interface),具体实现由第三方网络插件完成,如Calico、Flannel、Weave Net等,根据CNI项目文档和各大云厂商的实践,不同插件的实现原理和功能特性差异巨大。

- 坑点:你选择的网络插件决定了网络的性能、安全策略能力、是否支持网络策略(Network Policies)等,如果选型不当,可能会遇到网络性能瓶颈、无法实现精细的微服务访问控制、或者与底层云平台(如AWS, GCP, Azure)的VPC网络兼容性问题,导致网络不通或异常复杂。

- 解决办法:在搭建K8s集群前,必须根据自身需求(是否需要网络策略、对性能的敏感度、是否混合云等)谨慎选择CNI插件,Calico以强大的网络策略和性能著称;Flannel配置简单但对策略支持弱;云厂商通常有自己推荐的、与VPC深度集成的插件,充分测试是关键。

第二大坑:Service Mesh的复杂性 在微服务架构中,为了获得流量管理、可观测性、安全等功能,通常会引入Service Mesh(服务网格),如Istio或Linkerd,根据Istio官方文档,它会自动向Pod中注入一个Sidecar代理(如Envoy)。

- 坑点:这个Sidecar接管了Pod的所有进出流量,这可能会导致一些意想不到的问题:原来简单的网络连通性测试可能失效,因为流量路径变复杂了;调试困难,当出现网络问题时,需要排查是应用本身的问题、K8s网络问题还是Service Mesh配置问题;Mesh自身的资源消耗和延迟增加也是一个需要考虑的因素。

- 解决办法:深入理解Service Mesh的工作原理,利用其提供的强大工具,如Istio的Kiali可视化界面,来观察流量走向,建立清晰的调试流程:先绕过Mesh测试应用基础连通性,再逐步启用Mesh功能进行验证,合理配置Mesh,避免不必要的功能带来的开销。

第三大坑:安全策略配置繁琐易错 Kubernetes原生的Network Policies和Calico等插件提供的增强型网络策略,是实现微服务间零信任安全的核心。

- 坑点:网络策略的配置是基于标签选择器的,规则一旦复杂起来,非常容易写错,一个微小的配置失误就可能导致关键服务无法访问,形成“网络中断”的故障,而且策略是“默认拒绝”还是“默认允许”需要明确设定,理解错误会留下安全漏洞或阻断正常流量。

- 解决办法:采用“最小权限原则”,从默认拒绝所有流量开始,逐步添加允许策略,使用策略可视化工具(如Calico的Enterprise版功能或开源工具)来验证策略是否按预期生效,将网络策略像应用代码一样进行版本控制和自动化测试。

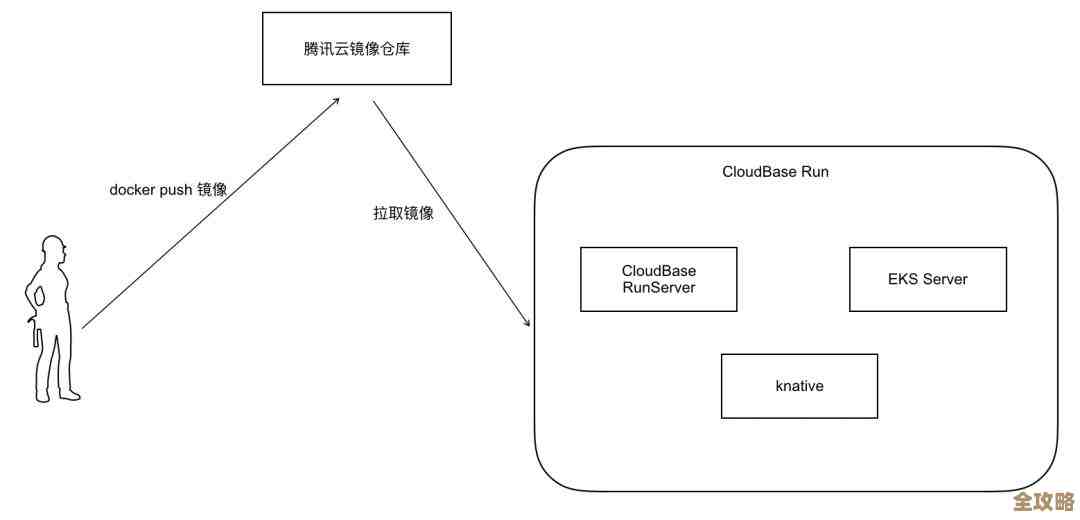

第四大坑:云厂商网络限制与成本 在公有云上运行K8s集群,其底层网络受限于云厂商的VPC设计。

- 坑点:某些云厂商的VPC存在路由表条目数量限制,当集群规模很大时可能触限;跨可用区的网络流量可能产生费用和延迟;负载均衡器(LoadBalancer)服务类型可能会创建昂贵的云负载均衡器实例。

- 解决办法:提前了解并测试云厂商的网络配额和限制,必要时申请提额,优化集群和节点规模,或选择支持更大路由表的CNI插件,对于内部服务,优先使用ClusterIP而非LoadBalancer,必要时采用Ingress控制器来收敛入口流量以节约成本。

在云原生环境下,“指定容器IP”已不再是核心问题,挑战转向了如何管理一个动态、复杂、多租户的扁平网络层,并处理好由此带来的可观测性、安全性和与底层基础设施的集成问题,解决这些“坑”的关键在于理解整个网络栈的组成(从CNI到Service Mesh),并善用相应的管理和调试工具。

本文由太叔访天于2026-01-17发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://waw.haoid.cn/wenda/82414.html