关于Bigkey问题,咱们其实可以这样去想和试着解决的那些方法探索

- 问答

- 2026-01-17 14:13:24

- 4

那咱们该怎么想、怎么试着解决呢?别急着找高大上的技术方案,先从最朴素的思路开始。

第一,先得知道“杂物间”里到底有什么——识别Bigkey。

你都不能确定哪个key是“大块头”,后续所有工作都是白搭,这里可以参考《Redis开发与运维》这本书里提到的一些方法,最直接的就是用Redis自带的命令,redis-cli --bigkeys 这个命令,它能帮你扫描整个数据库,找出哪种数据类型的key最大、最多,这就好比给房间来个快速巡查,看看是衣服堆成了山,还是旧书报塞满了箱。

但这个方法有个缺点,它是个“快照”,不实时,而且可能会对线上服务有一点点影响,更精细一点的做法是,从源头上看,你的应用程序在写入Redis的时候,是不是可以加个监控?在代码里,当某个String类型的value长度超过10KB,或者List/Hash/Set/ZSet的元素数量超过5000个时(这个阈值你自己定),就记录个日志或者发个告警,这就好比你在往杂物间放东西时,自己心里有个数:“哎呀,这箱东西再放进去,那个角落就快满了。” 这样就能在问题发生前预警。

第二,想想“这些东西是不是非得塞在一起?”——从设计上避免Bigkey。

很多时候,Bigkey的产生是因为图省事,要把一个用户的所有信息存成一个大的Hash键,用户每更新一次资料,这个巨大的Hash就要整个序列化、反序列化一次,网络传输压力也大,这就像你把春夏秋冬所有衣服都塞进一个巨型衣柜,想找件T恤得翻半天。

那能不能分开放呢?这就是“分而治之”的思想,参考一下Redis之父Salvatore Sanfilippo(antirez)在博客中表达过的观点,他更推荐使用多个key来管理数据,而不是一个巨大的key,把那个大Hash拆开,用 user:123:base_info, user:123:address, user:123:preferences 等多个小key来存储,这样操作起来更灵活,对Redis的压力也小得多,虽然一次获取所有信息可能需要多次请求(可以用pipeline优化),但相比Bigkey带来的风险,这点代价通常是值得的。

再比如,一个存储用户好友ID列表的大Set key,如果好友数上万,也很危险,能不能按好友名字的首字母或者ID的哈希值分到多个Set里呢?这样每个Set的大小就可控了。

第三,如果Bigkey已经存在了,像个“历史包袱”甩不掉,怎么办?——安全地拆解与清理。

直接DEL一个巨大的key是极度危险的,因为Redis是单线程的,删除一个几百MB的key会阻塞其他命令很久,可能导致服务雪崩,这就像你想一口气把杂物间清空,结果把所有东西都堆在门口,直接把路堵死了,家里其他人啥也干不了。

那得讲究策略,对于大Hash、大List、大Set这类有结构的key,不能直接删,要“蚂蚁搬家”。

- 对于大List: 可以不用

DEL,而用LTRIM命令。LTRIM key start stop可以只保留列表指定范围内的元素,你可以写个小脚本,每次用LTRIM命令一点点地“修剪”掉列表头部的元素,比如每次删100个,间隔一段时间再删下一次,直到整个列表被修剪完,这样就把一个大的阻塞操作,变成了多个小的、可控的非阻塞或微阻塞操作。 - 对于大Hash: 可以用

HSCAN命令加HDEL命令。HSCAN可以增量式地遍历Hash的所有字段,不会阻塞,你遍历出一批字段(比如100个),然后用HDEL删除这一批,休息一下再继续,同样是化整为零的思路。 - 对于大Set/Sorted Set: 思路类似,使用

SSCAN/ZSCAN配合SREM/ZREM进行分批删除。

这个方法在京东云开发者社区等技术分享平台被多次强调,是处理已存在Bigkey的标准“安全操作”。

第四,除了拆和删,还有没有别的思路?——换个地方放。

有些数据它天生就是大的,比如一篇很长的文章内容、一张图片的Base64编码,你把它存在Redis里,无论怎么分片,对单个实例来说它都是个Bigkey,这时候就得想想,Redis是不是它最好的归宿?

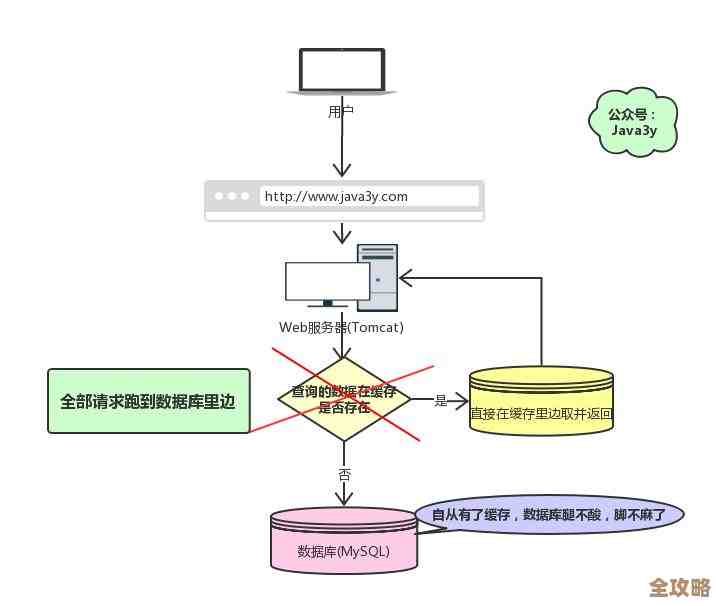

Redis的优势是快,适合存频繁访问的热点小数据,对于这种大的、可能访问没那么频繁的数据,是不是可以考虑存到别的地方?比如对象存储(OSS/S3),或者数据库里,然后在Redis里只存一个指向这些数据的地址或ID,这就好比杂物间里只放最常用、应季的东西,而那些一年才用一次的滑雪板、圣诞树,就放到地下室或者租个储物柜去,虽然取用的时候多了一步,但保证了日常空间的整洁和高效。

总结一下

看待Bigkey问题,咱们的心态应该是:

- 预防优于治疗: 在设计和编码阶段就建立规范,避免创建Bigkey。

- 监控不能少: 要有手段能及时发现Bigkey,无论是通过工具扫描还是代码埋点。

- 处理要温柔: 对于已有的Bigkey,切忌暴力删除,要用增量、分批的“软”操作。

- 工具要用对: 清楚每个数据类型的SCAN和TRIM类命令,它们是拆解Bigkey的手术刀。

- 格局要打开: 认清Redis的定位,不是所有数据都非得塞进Redis,用合适的存储做合适的事。

这么一想,Bigkey虽然麻烦,但也不是什么无法解决的妖魔鬼怪,关键是要有正确的思路和耐心的方法。

本文由钊智敏于2026-01-17发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://waw.haoid.cn/wenda/82453.html