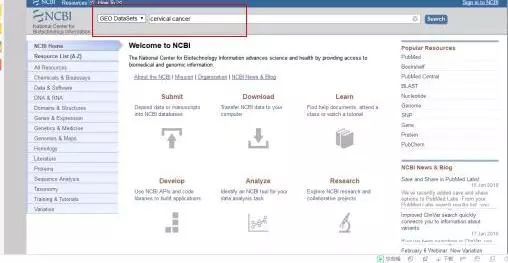

Geo数据库里那个Count数到底怎么影响后续数据分析结果的探讨

- 问答

- 2026-01-11 22:19:19

- 3

Geo数据库中的Count数,就是在高通量测序实验中,比对到某个基因或转录本上的序列片段的数量,它不是一个简单的计数,而是后续几乎所有分析的基石,这个数字的准确性和可靠性,直接决定了我们基于它得出的结论是接近真相还是可能被误导。

最直接的影响体现在基因表达量的比较上,我们做转录组分析,核心目的往往是找出不同样本(比如疾病组 vs 健康组)之间哪些基因的表达有显著差异,差异分析软件(如DESeq2, edgeR)的运作,从根本上依赖于每个基因的Count数,如果某个基因的Count数因为技术误差而普遍偏低,那么即使这个基因在生物学上确实有表达变化,软件也可能因为数据信噪比太低而无法检测到这种差异,造成假阴性结果,反过来,如果某些Count数因为实验过程中的污染或扩增偏差被人为抬高,就可能导致我们错误地认为一个本来没什么变化的基因是“显著上调”的,造成假阳性,这就好比用一把刻度不准的尺子去测量身高,无论你怎么比较两组人的数据,得出的结论都可能是不靠谱的。

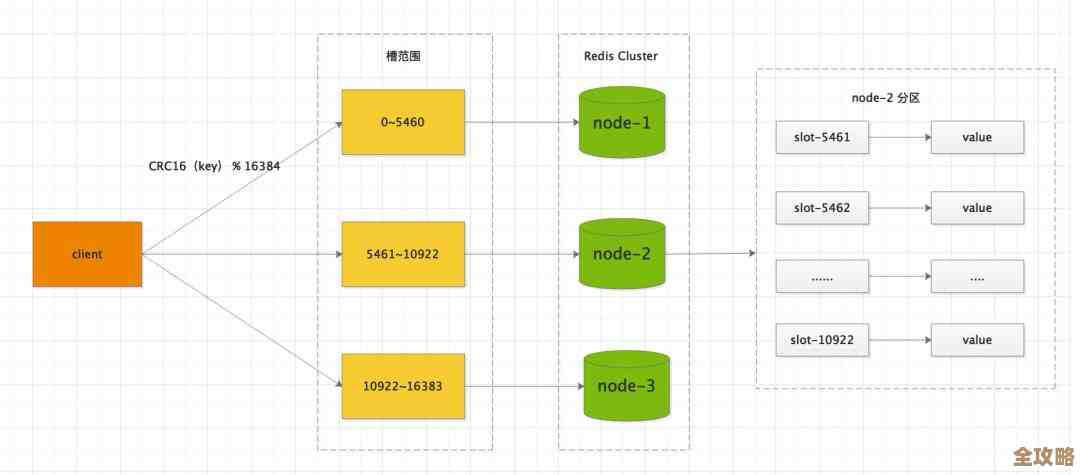

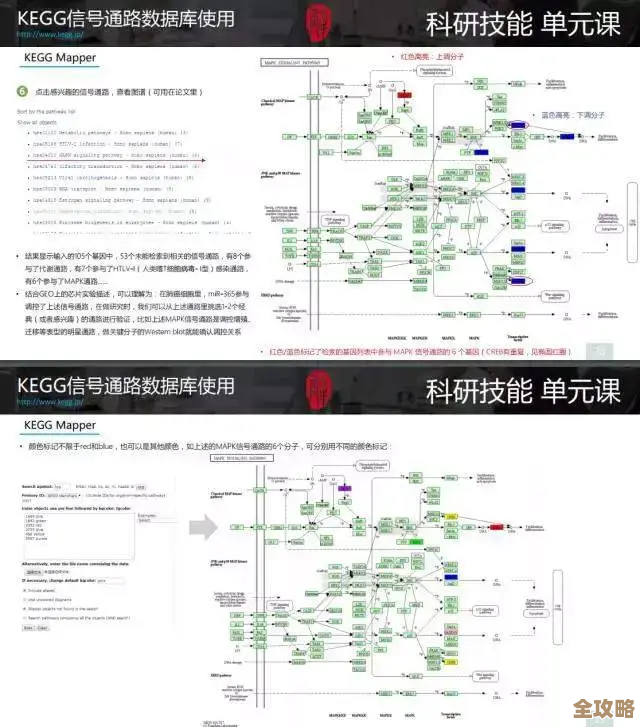

Count数的深度(即所有基因的Count数总和,常称为测序深度)对整个数据集的解释有着全局性影响,测序深度就像相机的像素,深度不够,很多低表达的基因就无法被“捕捉”到,它们的Count数会是零或接近零,这会导致我们在进行功能富集分析时出现偏差,假如我们关注一个重要的信号通路,但这个通路中的关键调控基因恰好是低表达的,由于测序深度不足,这些基因没有被检测到,那么整个通路在富集分析中就可能显示为“不显著”,从而让我们错过重要的生物学发现,在实验设计阶段,根据研究目标选择合适的测序深度至关重要。

Count数的分布特征直接影响数据标准化的方法选择,不同样本的测序深度天生就有差异,直接比较原始Count数就像比较一个读了10000本书的人和一个读了5000本书的人谁读的书多,而不考虑他们总的阅读时间,我们必须对Count数进行标准化,以消除技术偏差,使得样本间具有可比性,主流的标准化方法(如DESeq2的median-of-ratios方法,或edgeR的TMM方法)其核心思想都是寻找一个“标尺”,假设大部分基因的表达是不变的,然后根据这个标尺来调整每个样本的Count数,如果数据质量很差,比如有大量外源污染或者RNA降解严重,那么这种“大部分基因表达不变”的假设就会被打破,导致标准化失效,进而影响后续的所有比较分析。

Count数的质量还关系到更高级的分析的稳健性,当我们想寻找样本间的共表达基因模块(WGCNA分析)时,如果Count数据中噪音很大,那些由生物学真实信号驱动的共表达关系就很容易被随机噪声淹没,导致无法识别出有意义的模块,又比如,在单细胞RNA测序数据分析中,Count数的稀疏性(即大量基因的计数为零)是一个巨大挑战,如何准确估算和填补这些“丢失”的数据,直接影响到细胞分群的准确性和对细胞异质性的理解。

是什么影响了Count数的质量呢?来源文章提到了几个关键环节,从实验端看,RNA样本的质量是根本,如果RNA本身已经发生降解,那么最终测序得到的Count数分布就会失真,高表达基因的比例会异常增高,而低表达和长转录本基因的Count数会减少,建库过程也是如此,不同的建库试剂盒和操作流程可能会引入不同程度的扩增偏好性,使得某些序列被过度代表(Count数虚高),而另一些则被低估,在生物信息学分析端,原始测序数据的质控、去 adapter、以及最关键的重比对(Alignment)步骤,都会直接影响最终生成的Count数的准确性,一个不准确的参考基因组或者有缺陷的比对参数,会导致大量序列比对错误或失败,从而产生错误的Count数。

Geo数据库中的Count数绝非一个简单的数字表格,它是连接原始实验数据和生物学解释的生命线,它的质量贯穿于从实验设计、湿实验操作到生物信息学处理的整个流程,任何环节的疏忽都可能在Count数上留下印记,并像多米诺骨牌一样,影响后续的差异分析、功能分析乃至所有高级建模的结论,负责任的数据分析者在拿到一个GEO数据集时,第一步绝不是急于运行差异分析脚本,而是应该仔细审视Count数据的质量,包括检查测序深度分布、样本间相关性、以及是否存在明显的离群样本等,只有确保了基石稳固,我们在此基础上建造的生物学大厦才能经得起推敲,忽略对Count数本身质量的评估,盲目进行下游分析,很可能是在用精确的统计方法去分析一堆充满噪音的数据,最终得出似是而非的结论。

本文由盈壮于2026-01-11发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://waw.haoid.cn/wenda/78944.html