淘宝数据库现在到底怎么样了,问题多不多,有啥办法能应付得过来

- 问答

- 2026-01-12 03:37:17

- 3

关于淘宝数据库现在到底怎么样了,问题多不多,以及他们有啥办法应付得过来这个问题,我们可以从一些公开的报道和行业分析中窥见一二,需要明确的是,淘宝的数据库系统不是一个单一的、巨大的“数据库”,而是一个极其复杂和庞大的分布式系统集群,由成千上万台服务器和无数个数据库实例组成,谈论它的“问题”,不能像看待一个小型网站数据库那样简单。

淘宝数据库的现状:基本稳定,但挑战无时无刻不在。

根据阿里巴巴集团多年来在技术大会(如阿里云栖大会)上分享的信息来看,经过超过十年的技术演进,淘宝的数据库系统已经达到了一个非常高的稳定性和可用性水平,阿里巴巴集团副总裁、阿里云智能数据库事业部负责人李飞飞在近年的演讲中多次提到,阿里巴巴的核心系统已经全面上云,并且经历了多次“双十一”全球最大规模流量洪峰的考验,这意味着,在日常情况下,淘宝数据库的“问题”对于普通用户来说几乎是感知不到的,你我能顺利地下单、付款、查看物流,本身就说明了其底层系统的稳定性。

“问题不多”不等于“没有问题”,这个“问题”更多是工程师团队需要面对的、系统层面的挑战,这些挑战是常态化的、巨大的:

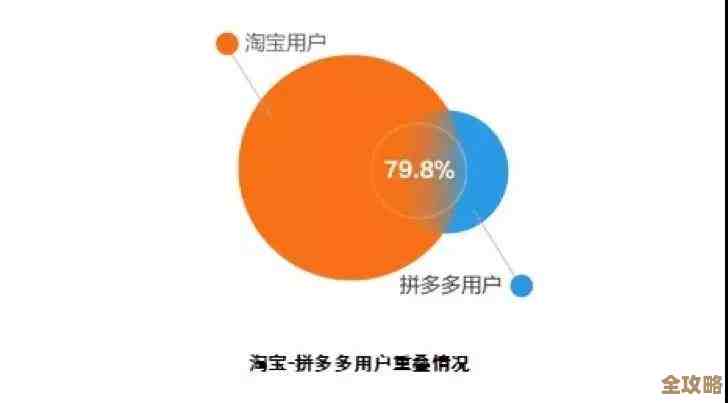

- 数据量惊人: 淘宝有数亿活跃用户,数百万商家,数十亿的商品SKU,每天产生的数据量是海量的,包括用户行为日志、交易数据、聊天记录等,如何存储、管理、快速查询这些数据,是首要挑战,这就像管理一个每天都在以惊人速度膨胀的超大型图书馆,不仅要能存下书,还要能在几秒钟内从亿万本书中找到用户想要的那一本。

- 高并发访问: 尤其是在“双十一”零点这样的时刻,每秒的订单创建峰值能达到数十万笔甚至更高,这种瞬间的、海量的读写请求,对任何数据库都是极限压力测试,任何一个环节出现瓶颈,都可能导致页面卡顿、无法支付等问题。

- 业务复杂性: 淘宝不是一个简单的商品列表页,它包含搜索、推荐、购物车、订单、积分、优惠券、直播、秒杀等无数复杂的业务场景,每种业务对数据库的要求都不一样,有的要求强一致性(如扣减库存),有的要求高性能读取(如商品展示),这给数据库的设计和运维带来了极高的复杂度。

淘宝到底有啥办法来应付这些挑战呢?

办法不是单一的,而是一整套经过千锤百炼的技术和方法论体系,根据阿里巴巴官方技术博客和云栖大会的分享,核心办法可以概括为以下几点:

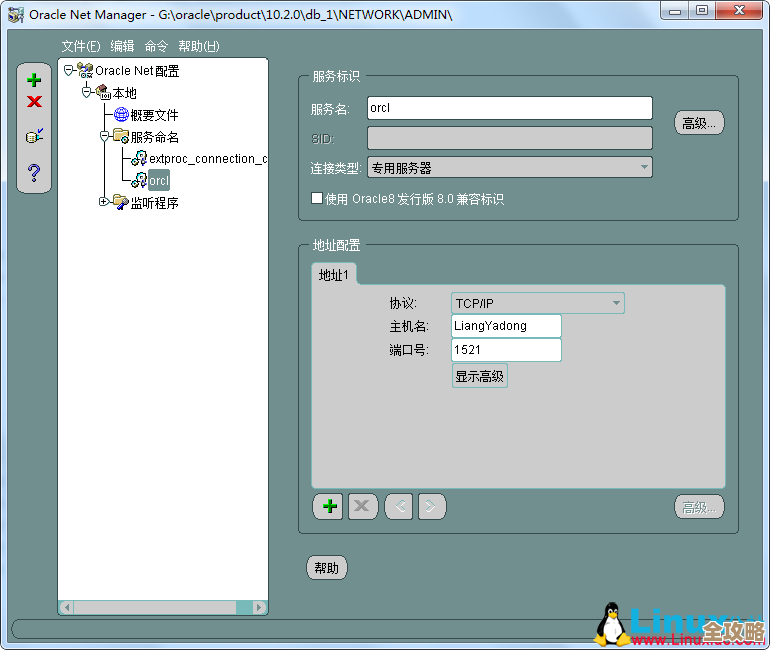

- “去IOE”和分布式架构: 这是最根本的一步,早在十年前左右,阿里巴巴就开始用廉价的PC服务器和开源软件,替代昂贵的IBM小型机、Oracle数据库和EMC存储设备,他们自研了OceanBase数据库和大量中间件,将庞大的数据库拆分成无数个小数据库(分库分表),分散到不同的服务器上,这样,压力被分散了,不会因为一台机器宕机就导致全站崩溃,实现了可扩展性和高可用性,这就像把一个大仓库变成了由无数个标准化小集装箱组成的智能物流网络,哪个箱子坏了,立刻换个新的,不影响整体运营。

- 读写分离和缓存技术: 这是应对高并发读写的利器,大部分用户的浏览、搜索请求都是“读”操作,淘宝会将这些请求引导到专门的“只读”数据库副本上,减轻核心交易数据库的压力,大量使用缓存(如自研的Tair),将最热门的数据(如爆款商品信息)放在速度极快的内存中,用户请求时直接从内存读取,避免了每次都要去查询慢速的硬盘数据库,这就像在超市收银台旁边开设一个快速通道,只卖最畅销的几种商品,大大缓解了主收银台的压力。

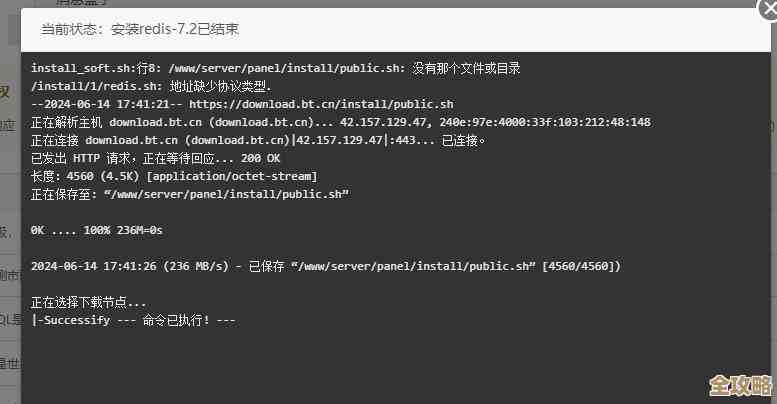

- 弹性扩容和云计算: 现在淘宝的整个系统都构建在阿里云上,在“双十一”等大促来临前,他们可以像拧开水龙头一样,动态地增加计算和存储资源(服务器实例),高峰期过后再释放掉,这种按需使用的弹性能力,让他们无需常年维持一个最高配的硬件规模,又能平稳度过流量高峰。

- 全链路压测和智能化运维: 这是保证系统稳定的“实战演练”,每年“双十一”前,阿里技术团队都会在真实的线上环境进行一次全链路压力测试,用模拟的真实流量去冲击整个系统,提前发现瓶颈和隐患,他们还大量应用人工智能和机器学习技术进行智能监控、故障预测和自愈,很多问题在影响到用户之前就已经被系统自动发现并处理掉了。

淘宝数据库目前处于一个“动态平衡”的状态,对于用户而言,它非常稳定可靠;但对于背后的技术团队而言,他们每天都在与海量数据、极高并发和业务复杂性进行着“搏斗”,他们能应付过来的关键,不在于某个神秘的黑科技,而在于一整套成熟的、经过实战检验的分布式架构理念、自研核心技术以及高效的运维体系,这些经验,如今也通过阿里云服务的形式,输出给了其他面临类似挑战的企业。

参考资料主要基于阿里巴巴集团在历年云栖大会上的技术分享、阿里巴巴官方技术博客“阿里技术”发布的文章、以及像InfoQ这样的技术社区对阿里技术专家的访谈内容。

本文由称怜于2026-01-12发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://waw.haoid.cn/wenda/79080.html