定时去数据库里查数据,想办法让检索更自动点,不用老盯着看

- 问答

- 2026-01-07 03:06:58

- 11

这个想法其实很普遍,就是不想像个保安一样,时时刻刻盯着数据库的大门,看看有没有什么新情况发生,你想的是,能不能设置一个“自动化哨兵”,让它按时按点去数据库里转一圈,发现有价值的“情报”就立刻给你发个信号,而你就可以安心去做其他更重要的事情了,这种从“人盯着数据”到“数据来找人”的转变,核心就在于如何巧妙地设置这个“自动化哨兵”。

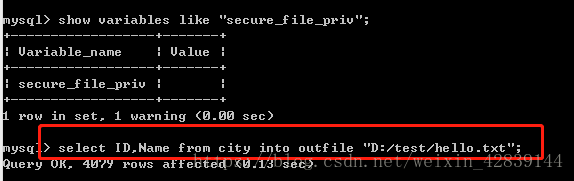

最直接了当的办法,就是写一个脚本,这个脚本就像你写给计算机的一张详细的寻宝指南,指南上写着:第一,每隔多少分钟(比如30分钟),或者每天固定几点钟(比如上午10点),你就去连接一下数据库这个“宝库”,第二,连接上去之后,执行我写好的这条SQL“咒语”,查找所有状态为‘异常’的订单”或者“统计过去一小时内新注册的用户数量”,第三,看看“咒语”念完之后,数据库返回的结果,如果结果不是空的,意味着找到了我们关心的数据,那就立刻行动起来,比如发一封邮件到我的邮箱,或者发一条消息到我们的工作聊天群里,如果结果是空的,那就当什么都没发生,安静地等待下一次检查时间的到来。

这种脚本可以用很多种语言来写,比如Python、Java、Go等等,选择哪种语言往往看你个人或者团队最熟悉什么,比如用Python的话,有几个库用起来非常顺手,你可以用schedule库来安排任务,让它每隔一段时间运行一次你的检查函数,在你的检查函数里,你用pymysql或者sqlalchemy这样的库连接上数据库,执行查询,根据查询结果,再用smtplib库来发邮件,或者用requests库调用公司内部的消息机器人接口发通知,这样一来,一个简单的自动化检查流程就搭起来了,你只需要把这个脚本放在一台一直开着的电脑或者服务器上运行起来,它就能成为你忠实的“哨兵”了。

光是有个会定时跑的脚本,有时候还不够“智能”,你可能关心的是某个数据是不是超过了设定的红线,假设你监控的是服务器的CPU使用率,你肯定不希望脚本每隔五分钟就告诉你一次“CPU使用率是85%”,如果这个高状态持续了半天,你的邮箱可能就被塞满了,这就是所谓的“报警风暴”,它会让重要的报警淹没在重复的噪音里,反而让你容易忽视,更聪明一点的“哨兵”需要具备“状态记忆”的能力,它可以记录下上一次检查的结果是什么,如果上次检查是正常的,这次检查发现异常了,那它立刻发出一个“告警”通知,告诉你“情况不好了!”,如果下次检查,异常依然存在,它可以选择不重复发送同样的告警,而是记录在日志里,或者发送一条程度更轻的“持续异常”提醒,直到某次检查发现异常恢复了,它再发送一条“恢复正常”的通知,这样,你收到的信息就非常有价值了:什么时候开始出问题,什么时候问题解决了,中间的过程你很清净。

除了自己写脚本,市面上也有很多现成的工具可以帮助你实现这个目标,甚至功能更强大,比如一些开源的监控系统,像Prometheus配上Grafana,或者Zabbix,这些工具本身就是为了监控而生的,它们可以非常方便地配置去定期抓取各种数据,包括数据库里的数据,你可以在Grafana这样的可视化界面上,很轻松地画出一条线,设定一个阈值,当这条线超过90%的时候,就触发报警”,报警的方式也多种多样,邮件、短信、钉钉、微信、Slack等等,几乎涵盖了所有常见的通知渠道,这些工具帮你解决了定时调度、数据存储、报警去重、历史记录查询等一大堆麻烦事,让你可以更专注于定义“到底什么样的数据是需要我关心的”。

有时候“定时去查”可能还不是最及时的,如果数据的变化非常关键,需要秒级甚至毫秒级的响应,定时检查”总归有一个时间间隔的延迟,对于这种场景,更好的办法是让数据库在数据发生变化时“主动通知”你的程序,这就像是数据库里面安装了一个门铃,有人进门(数据变更)它就“叮咚”响一声,像PostgreSQL数据库就提供了“发布-订阅”的功能,你可以监听某个数据表的插入或更新操作,一旦有变化,数据库会主动推送一个消息出来,你的程序只需要等着接收这个消息就好了,这种方式实现了真正的实时性,不过它对数据库本身有要求,并且实现的复杂度会比定时查询要高一些。

无论采用哪种方法,让检索自动化之后,你都不能完全当“甩手掌柜”,你需要定期检查一下你的“哨兵”是否还在正常工作,它设置的检查规则是否还符合现在的业务需求,一开始你觉得订单金额超过10000元算大额订单需要报警,但业务发展后,可能10000元已经很普遍了,报警规则就需要调整到50000元,确保报警信息清晰明了也很重要,报警消息里不能光说“出错了”,而应该说清楚“什么时候,哪个系统,哪条数据,出了什么错,可能的原因是什么”,这样你一眼就能看明白问题所在,快速做出反应。

把定时查数据库这件事自动化,是一个投入不大但收益非常高的改进,它把你从重复、低效的“盯屏”劳动中解放出来,让你能更专注于数据背后的业务分析和问题解决,核心思路就是利用脚本或现有工具,赋予它们定时触发、条件判断和通知提醒的能力,让数据在需要你介入的时候,主动来“敲门”。 综合了常见的自动化运维思路及数据库监控实践,具体技术实现可参考Python schedule库官方文档、Grafana官方文档、PostgreSQL LISTEN/NOTIFY文档等资料。)

本文由歧云亭于2026-01-07发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://waw.haoid.cn/wenda/75952.html