Redis集群数据不同步到底是咋回事,排查原因和解决思路分享

- 问答

- 2026-01-06 14:31:25

- 22

前几天看到一位运维工程师在论坛上分享了他的深夜故障处理经历,核心问题就是Redis集群出现了数据不同步,导致线上应用读到了旧数据,引发了业务问题,这其实是一个在分布式系统中比较经典且棘手的问题,下面我就根据社区里常见的讨论和官方文档的一些要点,来聊聊这到底是怎么回事,以及该怎么应对。

数据不同步到底是咋回事?

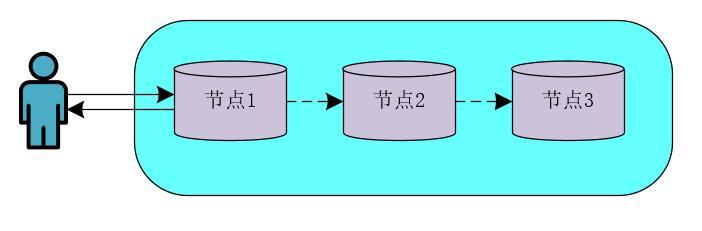

你以为是同一个集群,数据应该在任何一台机器上都一样,但实际上,某台机器上的数据“落后”了,或者干脆就是错的,当客户端请求被分配到这台“落后”的机器上时,自然就读不到最新的数据,这就像是一个团队里,有人拿到了最新版的工作文档,而有人还在用上周的旧版本,协作起来肯定要出乱子。

为什么会发生不同步?(排查原因)

原因有很多,我们可以从简单到复杂、从外部到内部来捋一捋。

-

网络问题(最常见的原因之一)

- 节点间网络中断: Redis集群节点之间需要持续通信来同步数据,如果两个节点之间的网络出现闪断、延迟过高或者完全不通,主节点(Master)的新数据就无法及时发送给从节点(Slave),根据Redis官方文档的说明,节点间通过心跳包维护联系,如果超过一定时间(可配置)没有收到从节点的消息,主节点会认为它“失联”了。

- 网络分区(脑裂): 这是更严重的网络问题,集群被分割成两个或多个无法通信的小团体,这时可能会产生两个“自以为”是主节点的实例,分别接收写请求,导致数据严重分歧,等网络恢复后,就会面临数据冲突和丢失的麻烦。

-

从节点自身问题

- 同步延迟(Replication Lag): 这是“正常”范围内的不同步,当主节点写入压力非常大时,从节点可能来不及完全应用主节点发送过来的数据变更命令,导致数据暂时落后,这种延迟通常是秒级的,但如果主从节点性能差异大,或者从节点负载过高,延迟可能会变得非常严重,你可以通过

redis-cli命令(INFO replication查看slave_repl_offset和master_repl_offset的差值)来监控这个延迟。 - 从节点持久化阻塞: 从节点在加载RDB快照(全量同步时)或重写AOF日志时,可能会因为磁盘I/O性能瓶颈而长时间阻塞,无法处理主节点传来的新数据,从而加剧同步延迟。

- 从节点进程繁忙: 如果从节点除了同步数据外,还承担了大量的读请求(在读写分离架构中常见),或者正在执行

keys *这样的慢查询,其CPU资源会被占用,没有足够的能力去消化同步流,导致数据落后。

- 同步延迟(Replication Lag): 这是“正常”范围内的不同步,当主节点写入压力非常大时,从节点可能来不及完全应用主节点发送过来的数据变更命令,导致数据暂时落后,这种延迟通常是秒级的,但如果主从节点性能差异大,或者从节点负载过高,延迟可能会变得非常严重,你可以通过

-

主节点问题

- 复制积压缓冲区(Replication Backlog)不足: Redis主节点会维护一个固定大小的缓冲区,用来存放最近发出的写命令,当从节点短暂断开重连后,会尝试从这个缓冲区里获取断开期间丢失的数据,但如果断开时间太长,或者主节点写入量巨大,导致缓冲区里的旧数据被新数据覆盖了,从节点就无法进行部分重同步(Partial Resync),只能触发一次耗时的全量同步(Full Resync),在此期间,从节点数据是空的,直到全量数据同步完成,全量同步会对网络和磁盘I/O造成很大压力。

-

配置问题

min-slaves-to-write和min-slaves-max-lag配置不当: 这两个配置项的意思是,只有当至少有N个从节点的延迟时间都小于M秒时,主节点才接受写请求,如果配置不合理(比如要求过于严格),当出现正常的同步延迟时,主节点可能会拒绝写入,从应用角度看也像是数据不一致(无法写入新数据)。

怎么解决和避免?(解决思路)

排查和解决要遵循先外后内、先观察后操作的原则。

-

监控与告警(治未病)

- 监控同步延迟: 这是最重要的指标,建立监控系统,持续跟踪每个主从对的

master_repl_offset差值,一旦延迟超过设定的阈值(比如10秒),立即告警。 - 监控集群节点状态: 监控每个节点的

INFO replication输出,确保主从关系是正常的(role:master/slave),connected_slaves数量正确。

- 监控同步延迟: 这是最重要的指标,建立监控系统,持续跟踪每个主从对的

-

排查与诊断(治已病)

- 第一步:检查网络。 使用

ping、traceroute等工具检查节点间的网络连通性和延迟,这是基础,必须先排除。 - 第二步:查看Redis日志。 仔细查看主从节点的Redis日志,里面通常会记录同步相关的信息,比如从节点连接断开、全量同步开始、同步错误等,这是最直接的线索。

- 第三步:使用Redis命令分析。 连接到出问题的从节点,执行

INFO replication命令,重点关注:master_link_status:是否为up。slave_repl_offset和主节点的master_repl_offset的差距。- 是否有

master_sync_in_progress:1的标识,这表示正在进行全量同步。

- 第四步:分析系统资源。 检查从节点的CPU使用率、磁盘I/O(特别是await和%util指标)和网络带宽,看是否存在瓶颈。

- 第一步:检查网络。 使用

-

解决与优化(对症下药)

- 针对网络问题: 联系网络运维团队解决基础设施问题,对于云环境,检查安全组或网络ACL规则是否阻止了集群节点间的通信端口(通常是6379和16379)。

- 针对同步延迟:

- 优化从节点性能: 确保从节点有足够强的CPU和性能更好的SSD硬盘,避免因自身性能拖后腿。

- 减轻从节点压力: 如果从节点承担了太多读请求,可以考虑增加更多从节点来做负载分担。

- 调整复制积压缓冲区: 适当调大主节点的

repl-backlog-size配置(默认1MB),给从节点更长的“追赶”时间窗口,避免频繁的全量同步。 - 限制主节点写入速度: 如果业务允许,对写入流量进行削峰填谷,避免瞬间高峰压垮同步机制。

- 针对配置问题: 根据业务对数据一致性的要求,审慎调整

min-slaves-to-write等配置,如果业务可以接受短时间的数据不一致(最终一致性),可以放宽或禁用此配置,优先保证可用性。 - 终极手段:手动同步。 如果数据不同步问题无法快速解决,或者从节点数据已经混乱,最彻底的方法就是停止该从节点,清空其数据目录,然后重新启动让它从主节点执行一次全量同步,但这会带来一段时间内的服务能力下降。

Redis集群数据不同步不是一个单一的问题,而是一个症状,解决它需要像侦探一样,从监控指标和日志中寻找线索,系统地排查网络、资源、配置等各个环节,建立完善的监控告警体系,防患于未然,远比事后救火要重要得多。

本文由水靖荷于2026-01-06发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://waw.haoid.cn/wenda/75620.html