用Redis本地缓存配合限流,搞定访问速度慢的问题,效率蹭蹭往上涨

- 问答

- 2026-01-04 00:23:39

- 22

用Redis本地缓存配合限流,搞定访问速度慢的问题,效率蹭蹭往上涨

你有没有遇到过这种情况?自己做的网站或者应用,平时用着好好的,一旦用户多了,或者搞个什么活动,页面就卡得不行,加载个数据转圈圈转半天,用户抱怨连连,自己看着也干着急,这背后最常见的原因,就是数据库压力太大了,每次用户点一下,都要去数据库里查一遍,人一多,数据库就忙不过来,响应自然就慢了。

那怎么办呢?一个非常有效的方法就是引入缓存,而Redis正是干这个的能手,今天我们就来聊聊,怎么用Redis,再配合上本地缓存和一些限流的小技巧,让你的应用速度“蹭蹭”往上涨。

第一招:请个超级外援——Redis

你可以把Redis理解成一个放在内存里的、速度超级快的“临时仓库”,它的读写速度极快,比去硬盘上的数据库查东西要快几十上百倍,我们解决速度问题的第一步,就是尽量减少直接去麻烦数据库的次数。

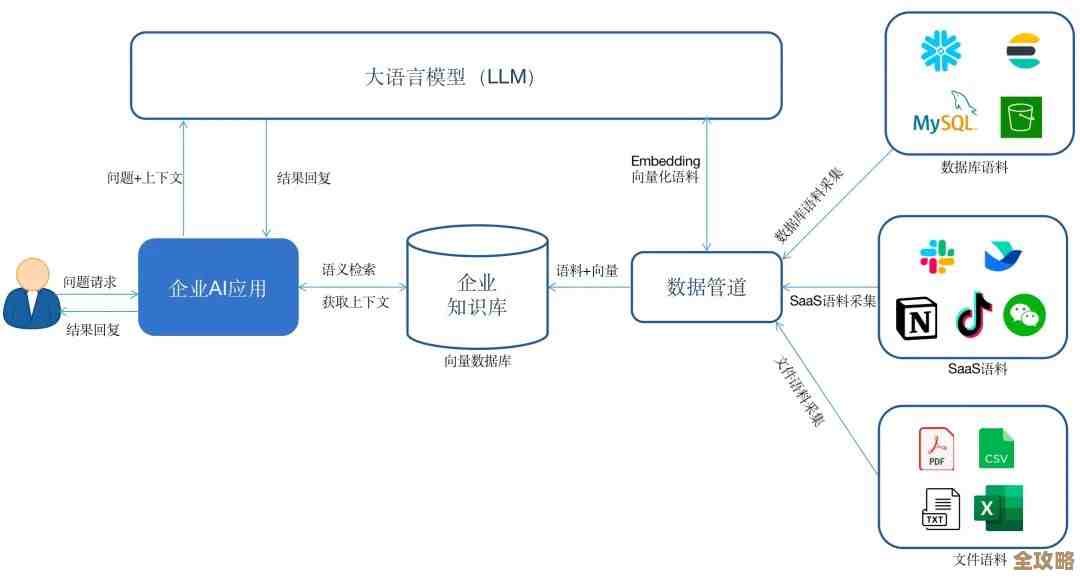

具体怎么做呢?很简单,就是在应用和数据库之间,加一层Redis。

- 缓存热点数据:网站首页的商品列表、热门文章、用户经常访问的配置信息等,这些数据的特点是访问频率非常高,但又不是随时在变。

- 流程变了:现在用户来请求数据,我们不再是二话不说就直接去查数据库,而是先派个人去Redis这个“临时仓库”里看看,有没有我们想要的数据。

- 如果Redis里有(这叫缓存命中):太好了!直接把这个数据返回给用户,因为Redis速度极快,用户几乎感觉不到延迟。

- 如果Redis里没有(这叫缓存未命中):那没办法,还是得去数据库查,查回来之后,我们不能忘了本分,要顺手在Redis里也存一份(设置一个合理的过期时间,比如5分钟),这样下一个用户再来要同样的数据,就可以直接从Redis里拿了。

就这么一个小小的改变,效果是立竿见影的,绝大部分请求都被Redis这个“快速通道”给消化掉了,数据库的压力瞬间就降下来了,整体的响应速度自然就快了。

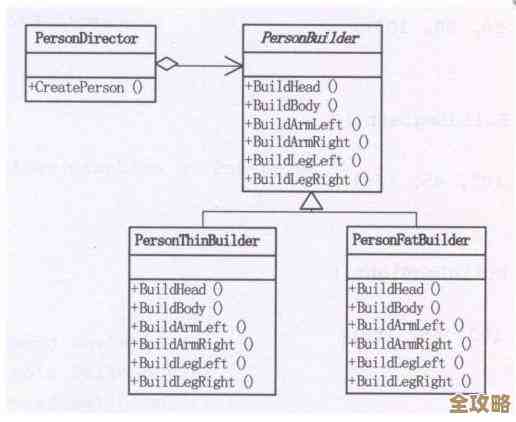

第二招:双剑合璧——Redis + 本地缓存

用了Redis,速度已经快了很多,但还有没有提升空间呢?有!因为应用服务器和Redis之间毕竟还是有网络开销的,虽然这个开销很小,但在极端追求性能的场景下,我们还是想把它优化掉。

这时候,就可以请出“本地缓存”了,本地缓存,顾名思义,就是把数据直接缓存在应用服务所在的服务器的内存里,它的速度比访问Redis还要快,因为连网络请求都省了。

常见的本地缓存实现有Guava Cache、Caffeine等,我们可以这样设计一个两级缓存策略:

- 先查本地:用户请求来了,首先在应用服务器的本地缓存里找数据。

- 本地没有再查Redis:如果本地缓存没有,再去查Redis。

- Redis没有才查数据库:如果Redis也没有,最后才去查数据库,并把数据依次写回到Redis和本地缓存中。

这个策略就像是两道防线:本地缓存是第一道,速度最快;Redis是第二道,容量更大,能共享给所有应用服务器;数据库是最后的大本营。

用本地缓存要注意一个问题:数据一致性,因为数据现在被缓存在好多台应用服务器的本地内存里了,如果后台管理员修改了某个商品的价格,你怎么保证所有服务器上的本地缓存都能及时更新呢?解决办法通常有两种:一是给本地缓存设置一个很短的过期时间(比如几十秒),让它快速失效;二是通过发布订阅的消息机制,当数据变更时,通知所有服务器清空对应的本地缓存,这就需要根据业务对实时性的要求来权衡了。

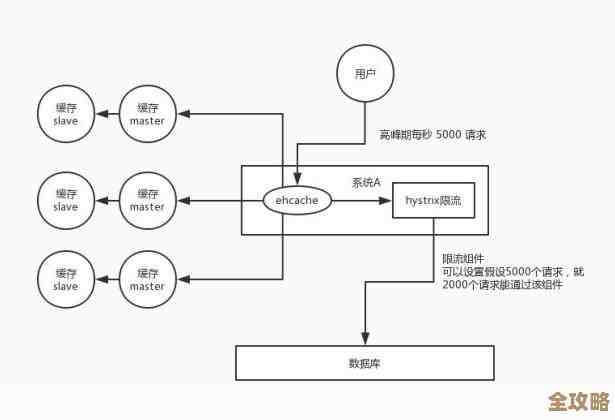

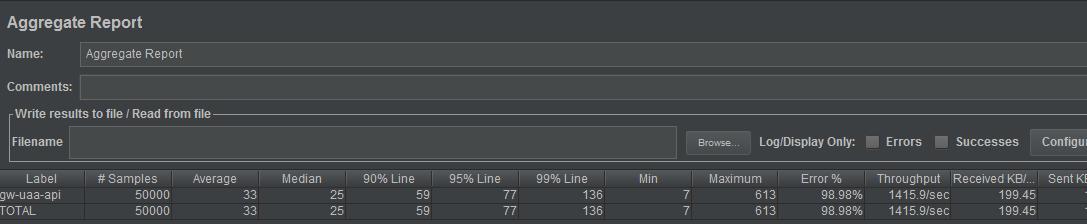

第三招:设个门槛——限流

用了缓存,系统抗压能力已经很强了,但俗话说,防患于未然,万一遇到恶意刷接口,或者突然涌进来远超我们系统处理能力的流量(比如明星绯闻、秒杀活动刚开始那一刻),就算有缓存,服务器也可能因为处理不过来的请求而崩溃。

这时候,就需要“限流”来保护我们的系统了,限流就是给系统的入口设个门槛,规定在一段时间内,只允许一定数量的请求通过,超出的请求就直接拒绝掉,返回一个“系统繁忙”之类的提示,这样做虽然牺牲了一部分用户的体验,但保证了系统不会彻底崩溃,大部分用户还能正常使用。

Redis同样可以很好地实现限流,这里说两种简单常用的方法:

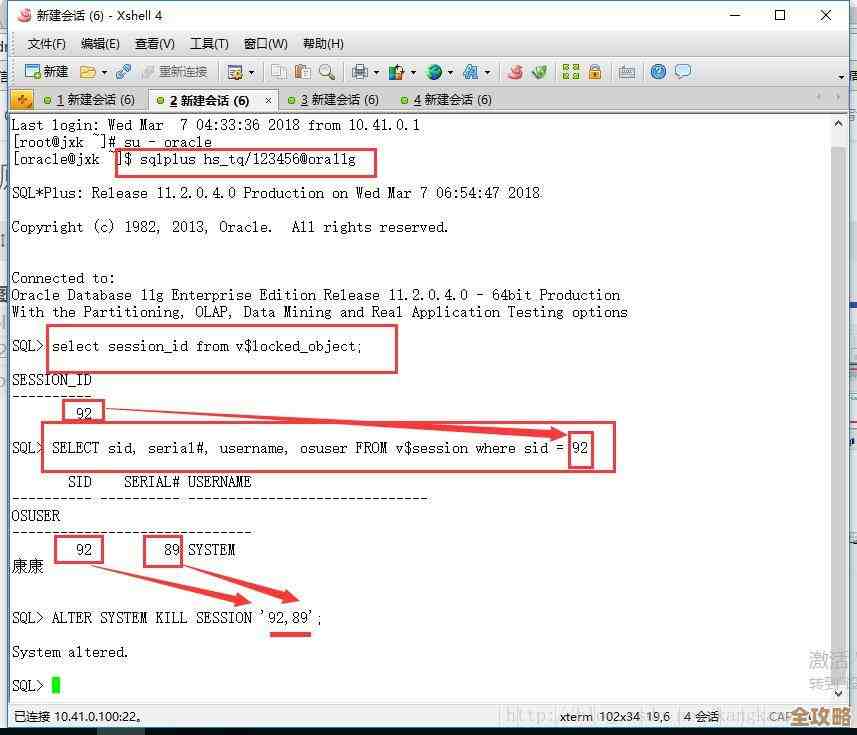

- 计数器法:我们想限制某个接口1分钟内只能被同一个IP访问60次,我们可以在Redis里给这个IP设一个键,每次请求来了就把这个键的值加1,并设置过期时间为1分钟,如果在一分钟内,这个值超过了60,后面的请求就直接拒绝。

- 滑动窗口法:计数器法有个缺点,比如在59秒的时候突然来了60个请求,然后下一秒又来了60个请求,其实相当于2秒内来了120个请求,可能还是会对系统造成冲击,滑动窗口会更精确一些,它记录的是当前时间点往前推一段时间内的请求数,比如记录过去1分钟内每个请求的时间点,然后统计数量,这样就更平滑和准确。

通过限流,我们给系统穿上了一件“防弹衣”,在面对突发流量时能够稳如泰山。

总结一下

搞定访问速度慢的问题,不是一个单一的手段,而是一个组合拳:

- 用Redis做集中式缓存:把最常用的数据从数据库“搬”到内存里,解决大部分读请求的压力。

- 用本地缓存做进一步加速:对于极热的数据,放在应用本地,实现近乎极限的访问速度,但要注意数据一致性问题。

- 用Redis配合实现限流:给系统设置一个安全阀,防止突发流量把系统冲垮。

这三板斧下去,层层递进,既能主动提升性能,又能被动防御风险,你的应用想不“快”起来都难,具体实施的时候,还需要根据自己业务的实际情况,比如数据量、访问模式、对一致性的要求等,来选择合适的缓存策略和限流参数,但大方向就是这么个方向,希望能给你带来启发。

本文由盘雅霜于2026-01-04发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://waw.haoid.cn/wenda/74005.html