秒杀场景用Redis延迟队列,怎么快速搞定那点儿延迟问题呢?

- 问答

- 2025-12-30 16:31:25

- 2

你问的是秒杀场景里用Redis做延迟队列,怎么把那个延迟时间缩得更短,这事儿说白了,就是想尽办法让消息一到点就立刻被消费者拿走处理,别在队列里磨蹭,直接上干货,咱们聊聊几个实在的招儿。

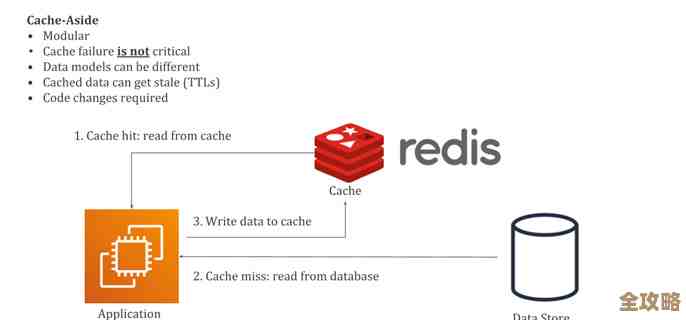

第一招:别用轮询,用“订阅”

最原始的办法是消费者不停地去问Redis:“到点了吗?到点了吗?”(这就是轮询),这肯定快不了,而且浪费资源,第一个要干掉的就是它,改用Redis的发布订阅(Pub/Sub)机制或者更现代的Stream数据结构。

比如用Redis Stream,消费者可以阻塞式地等待新消息,具体操作是(来源:Redis官方文档关于Stream的说明):生产者把消息塞进Stream,并设置一个延迟时间,比如5秒后生效,消费者不是傻等着,而是执行一个阻塞读取命令,比如XREAD BLOCK 0 STREAMS mystream $,这个命令的意思是:“我就趴在这死等了,有新的、到时间的消息你立刻叫我。”这样一来,消息一旦可被消费,Redis服务器会主动通知在等待的消费者,这个响应速度是毫秒级的,比轮询快太多了,这就好比你不是隔几秒就看一眼邮箱,而是设置了新邮件提醒,邮件一来手机就响,效率自然高。

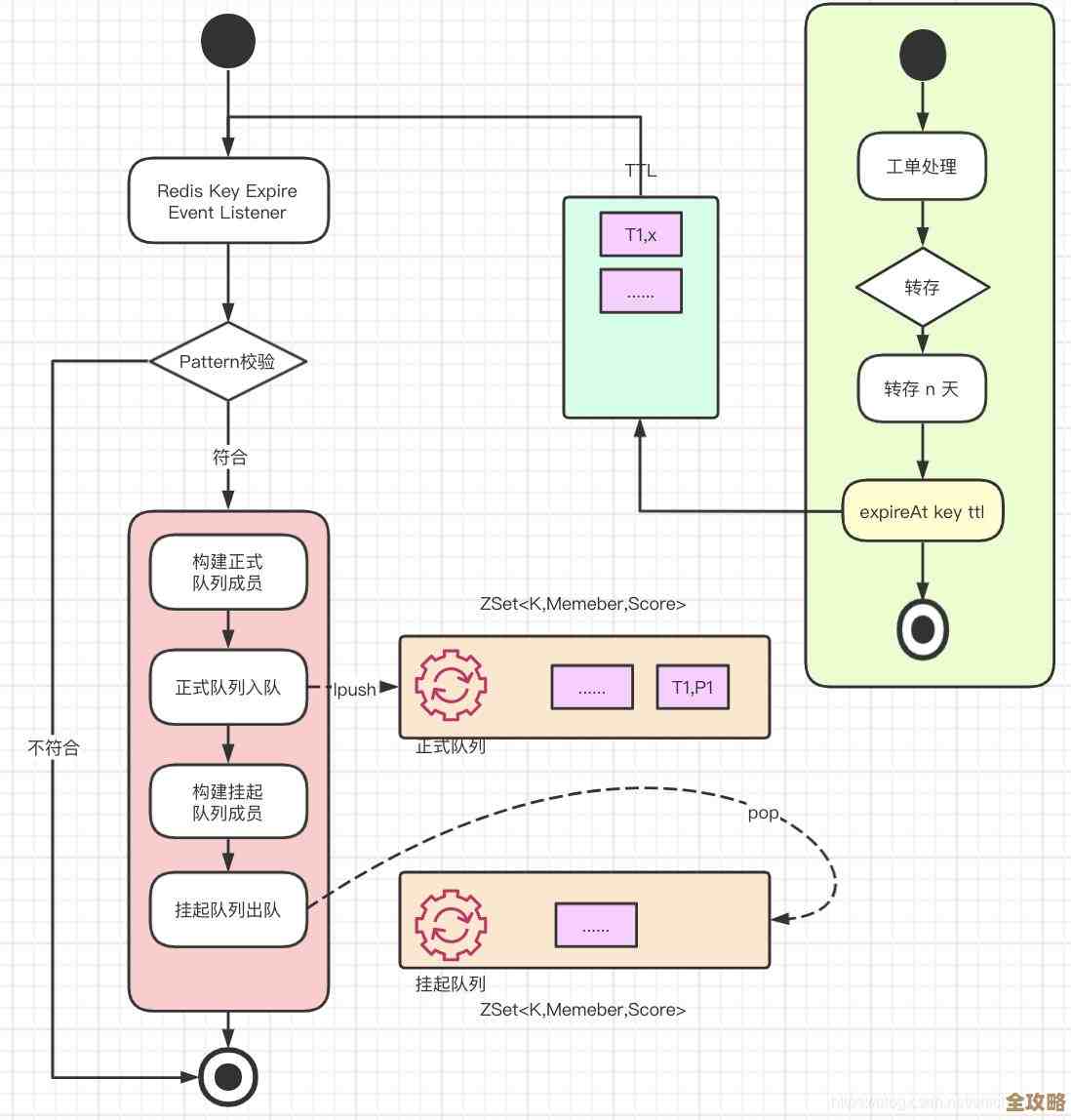

第二招:把“延迟”和“执行”拆开,用个中间人

单纯用Stream,如果延迟时间设得比较长,比如半小时,让一个连接阻塞半小时也不现实,这时候可以用一个经典组合拳(来源:许多技术社区如Stack Overflow上关于延迟任务的经典讨论):有序集合(ZSet) + 列表(List)。

具体这么玩:

- 生产者把任务和一个到期时间戳(比如当前时间+5秒)塞进一个ZSet里,这个分数(score)就是时间戳。

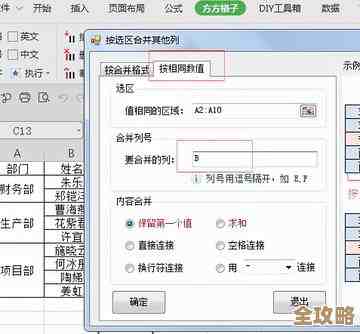

- 我们单独起一个后台进程或线程,就叫它“搬运工”吧,这个“搬运工”的任务非常简单,就是一刻不停地扫描这个ZSet,用

ZRANGEBYSCORE命令找出所有分数(到期时间)小于等于当前时间戳的任务,这些任务就是到点的。 - “搬运工”把这些到点的任务从ZSet里捞出来,然后立刻塞进一个普通的FIFO(先进先出)的List队列里。

- 真正的消费者们呢,它们不用关心延迟,就老老实实地从这个List队列里用

BLPOP命令阻塞地取消息处理。

这样做的好处是,分工明确。“搬运工”只负责精准地检查时间和搬运,它的逻辑简单,速度可以很快,消费者只负责高效地处理业务,它看到的永远都是已经“熟透了”、立刻要执行的任务,没有延迟,把判断时间的压力从消费者身上剥离了,消费者就能全力去秒杀,这个“搬运工”因为逻辑简单,甚至可以多开几个实例提高搬运速度,确保延迟任务一到期就被瞬间挪到待执行队列。

第三招:硬件和网络是基础,别在这儿掉链子

上面说的都是软件层面的优化,但如果你的Redis服务器本身响应慢,或者消费者和Redis服务器之间的网络延迟高,那前面做的优化全白搭,这就好比你是世界冠军,但让你在泥地里跑,也快不起来。

(来源:普遍的服务器运维常识)要想极致降低延迟,必须保证:

- Redis服务器本身要快:最好把Redis部署在内存大、CPU好的机器上。一定要把数据持久化方式配置好,如果为了数据安全开了AOF持久化,尽量使用每秒同步一次的策略(

appendfsync everysec),避免使用总是同步(appendfsync always),因为后者虽然最安全,但每次写操作都刷盘,会严重影响性能,在秒杀这种瞬时高并发的场景,可以权衡一下数据丢失的风险和性能要求。 - 网络要通畅:确保消费者应用和Redis服务器在同一个机房的内网中,避免跨网络节点访问,物理距离越近,网络延迟越低,如果条件允许,使用更高速的网络设备,那几毫秒的网络延迟就是瓶颈。

第四招:避免单个队列成“堵点”,试试分片

如果秒杀的量特别大,每秒产生几十万甚至上百万的延迟任务(比如下单后未付款的订单),那么单个ZSet或单个List可能会成为瓶颈,这时候可以考虑分片(Sharding)的思路。

来源:分布式系统常见的分片策略),你可以根据秒杀商品的ID或者用户ID的哈希值,将延迟任务分散到多个不同的Redis Key上(delay_queue:1, delay_queue:2, ...),同样地,对应的待执行List队列也分成多个。“搬运工”和“消费者”也相应地启动多个实例,每个实例只处理特定分片上的数据。

这样做的好处是,将压力和流量分散了,从原来的一个队列、一组处理者,变成了多个队列、多组处理者并行工作,处理能力水平扩展,自然就能更快地消化掉延迟任务,减少积压。

总结一下

要想快速搞定Redis延迟队列的延迟问题,核心思想就几个:用通知机制代替轮询、通过架构设计分解责任、保障底层基础设施的顺畅、在巨量数据下敢于分而治之,从Redis的Pub/Sub或Stream,到ZSet+List的经典模式,再到网络和硬件的优化,以及最终的分片策略,都是一步步把可能产生延迟的环节给优化掉,在实际项目中,通常ZSet+List的组合已经能应对绝大多数场景,并且非常稳定可靠,你可以根据自己业务的并发量和延迟敏感度,选择合适的方案进行组合和调整。

本文由水靖荷于2025-12-30发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://waw.haoid.cn/wenda/71369.html