K8s Informer 里面到底怎么做到事件一个都不漏掉,背后机制是啥?

- 问答

- 2025-12-29 04:45:11

- 5

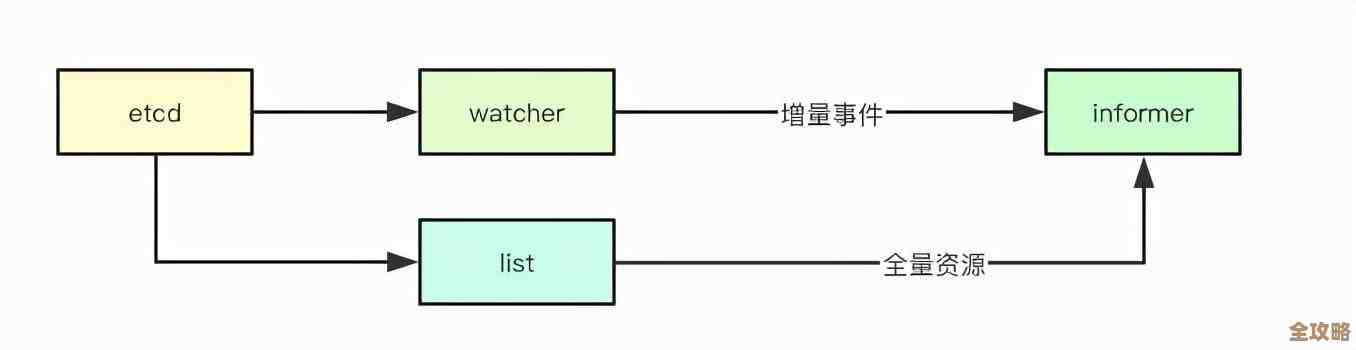

要理解K8s Informer为什么能几乎不漏掉任何事件,我们需要像侦探一样,一步步拆解它背后设计的精妙机制,它不是一个简单的定时轮询,而是一个结合了缓存、长连接、重试和增量队列的复杂系统,其核心思想是:先建立一个可靠的基础状态,然后像追更小说一样,一有更新就立刻通知你,并且万一网络断了,还能从断掉的地方接着看,而不是重头开始。

我们得知道Informer要和谁打交道,它的目标是Kubernetes的API Server,可以把它想象成一个权威的、记录了整个集群所有资源状态的数据库,Informer的目标就是在本地方便、高效地同步这个数据库的完整信息。

第一步:全量同步——打下坚实的基础 当Informer第一次启动时,它绝不会只监听最新事件,它会先向API Server发起一个List请求,就像说:“请把当前所有这种类型的资源(比如所有Pod)的完整列表都给我。” (来源:Kubernetes官方文档及Client-go源码中的ListWatch机制) 这个步骤至关重要,它确保了Informer的本地缓存从一个完整、准确的全量数据快照开始,这就好比你要追一部连载的小说,Informer不是从最新一章开始看,而是先把已经发布的全部章节都下载到本地,建立一个完整的书库,这样,你就有了一个坚实的“基线”,后续的所有更新都是在这个基线上进行的增量修改,如果一开始的基线就是错的,那后面再怎么更新也是白搭。

第二步:建立长连接监听——实时获取增量变化 拿到全量列表后,Informer不会傻傻地每隔几秒就去问API Server:“有变化吗?”(这种叫轮询,效率低且容易遗漏快速连续的变化),相反,它会建立一个HTTP长连接,也就是Watch请求。(来源:Kubernetes API概念文档中的Watch条目) 这个Watch请求可以理解为一个“事件流管道”,API Server会一直保持这个连接打开,只要被监听的资源有任何变化(比如Pod被创建、更新或删除),API Server就会立刻通过这个管道推送一个事件消息给Informer,这种方式是实时的、高效的,避免了轮询带来的延迟和资源浪费,这就像你订阅了小说的更新提醒,作者一发布新章节,你的手机就会立刻收到推送,而不需要你不停地去刷新页面。

网络是不稳定的! 这个长连接随时可能因为网络问题而中断,这正是Informer设计中最关键的部分——如何应对中断以确保不丢事件。

第三步:应对连接中断的利器:resourceVersion

Kubernetes的每个资源列表(包括最初的List结果和后续的Watch事件)都附带一个关键的元数据字段,叫做resourceVersion,这个字段是一个全局递增的序列号,代表了Kubernetes集群etcd存储的当前版本号。(来源:Kubernetes API约定文档中的元数据部分)

当Informer发起List请求时,返回的响应里就包含了一个resourceVersion(假设是1000),当它紧接着发起Watch请求时,会带上这个参数,意思是:“请告诉我从版本1000之后发生的所有事件。”

如果Watch连接不幸中断了,Informer不会惊慌,它会重新发起一个List请求(或者带resourceVersion的Watch请求),但这次会使用它最后一次成功收到的那个事件的resourceVersion,在断开前它收到的最后一个事件版本是1050,那么重连时它就会说:“请告诉我从1050之后发生的所有事件。”

API Server有能力精确地返回从指定版本开始的所有历史事件,这样,即使中间连接断开了1小时,重连后Informer也能把这段时间内错过的所有事件一个不差地“补课”回来,完美地避免了事件丢失。

第四步:本地缓存与事件去重

Informer在内部维护了一个本地内存缓存(称为Store),它会将List和Watch到的所有事件都应用到这个小副本上,使其与API Server的状态保持同步。(来源:Client-go源码中的Store和Controller组件)

这个缓存还有一个重要作用:去重,由于网络抖动,可能会发生一种情况,就是Informer可能会收到重复的事件(比如同一个版本号的事件收到了两次),本地缓存会根据资源的唯一标识(UID)和resourceVersion来判断,如果已经应用过这个版本的变化,就会忽略掉重复的事件,确保业务逻辑不会被重复触发。

第五步:稳健的事件处理:Delta FIFO队列与重试机制

Watch到的事件并不会直接扔给用户写的处理函数,Informer会先把这些事件放入一个名为DeltaFIFO的先进先出队列中。(来源:Client-go源码中的DeltaFIFO实现)

这个队列就像一个缓冲带,万一用户的事件处理函数处理得比较慢,或者暂时出错了,事件会在这个队列里排队等待,而不会阻塞Watch管道,更重要的是,如果事件处理失败了,Informer有一套重试机制,默认情况下,如果处理一个事件失败,它会被重新放回队列(除非达到最大重试次数),这样就有机会再次尝试处理,进一步增强了系统的鲁棒性,防止因临时异常导致的事件丢失。

总结一下: K8s Informer通过 “全量同步(List)建立基线 + 长连接监听(Watch)实时更新 + 基于resourceVersion的断线重连补课 + 本地缓存去重 + 队列重试” 这一套组合拳,确保了事件的高可靠、准实时传递,它不是依靠单一的神奇技术,而是通过多层机制环环相扣,共同构建了一个极其健壮的状态同步系统,从而实现了“事件一个都不漏掉”的目标。

本文由钊智敏于2025-12-29发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://waw.haoid.cn/wenda/70447.html