Redis读操作其实单线程,怎么做到吞吐量能爆表那种感觉

- 问答

- 2025-12-26 00:31:07

- 1

关于Redis读操作为单线程却能实现超高吞吐量的问题,这确实是一个初接触Redis时很多人都会有的疑惑,感觉上,单线程就像是一个超市只开了一个结账通道,顾客(请求)一多肯定排长队,速度怎么快得起来?但Redis这个“超市”的设计非常精妙,它通过一系列巧妙的办法,让这个单通道的效率高到惊人,从而避免了拥堵,这背后的原因可以从几个方面来理解,核心思想就是“扬长避短”,把单线程的优势发挥到极致,同时通过系统层面的优化来规避其潜在的劣势。

最根本的一点是,Redis的操作绝大多数都是在内存中完成的,内存的读写速度远远快于磁盘,这是最基础的物理优势,这就好比你要找一本书,如果书都放在你手边的书架上(内存),你瞬间就能拿到;如果书放在图书馆的地下仓库(磁盘),你光走过去就要花很长时间,Redis把所有数据都放在内存里,意味着数据的读取和写入几乎没有任何延迟,单线程处理一个请求的速度本身就非常非常快,当一个任务本身极其轻量、耗时极短时,单线程顺序处理,反而避免了多线程之间为了协调资源而产生的额外开销,比如锁竞争、上下文切换等,这种开销在多线程环境下是不可忽视的成本,有时甚至比任务本身还耗时,Redis的单线程模型恰恰是“快刀斩乱麻”,没有这些杂七杂八的干扰,CPU时间可以最大限度地用在真正的数据操作上。

Redis采用了非常高效的数据结构和算法,Redis提供的五种基本数据类型(字符串、列表、哈希、集合、有序集合)其底层实现都经过了极致优化,目的就是用最快的速度完成增删改查,哈希表是Redis大量使用的数据结构,它能够在大多数情况下以接近O(1)的时间复杂度找到目标数据,这意味着,无论你存储了几十个键值对还是几亿个,执行一次GET或SET命令,其内在的查找过程所花费的时间几乎是一样的,这种算法层面的高效,为单线程快速处理每个请求奠定了坚实的基础,如果底层算法效率低下,哪怕是用一百个线程来处理,整体吞吐量也上不去。

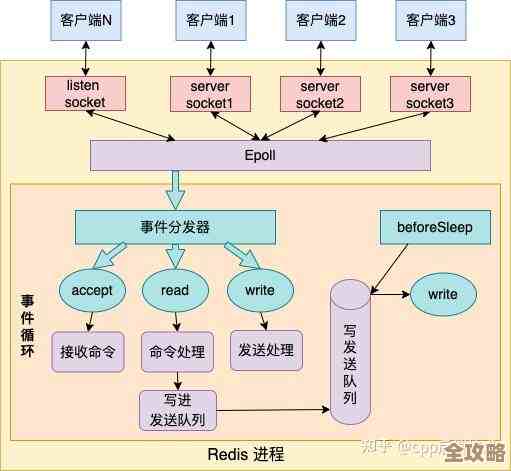

第三,也是非常重要的一点,Redis使用了I/O多路复用技术来处理网络连接,这是解决单线程模型下高并发问题的关键,虽然处理命令的工作是单线程的,但监听和接收客户端连接请求的任务,Redis交给了操作系统内核的一套机制(如Linux下的epoll),你可以把这个过程想象成有一个超级高效的“前台接待员”(I/O多路复用器),这个接待员可以同时照看成千上万个想要进入超市的顾客(网络连接),他不需要一个个地去问“你要做什么?”,而是静静地等着,当哪个顾客真的有购物需求(网络数据到达)时,这个接待员才会立刻通知超市里那个唯一的“收银员”(单线程):“喂,这位顾客准备好了,来处理一下。”收银员于是过来快速完成结账,然后立刻去处理下一个被通知的顾客,这样一来,收银员永远不会闲着等待某个慢吞吞的顾客,他的时间被完全利用了起来,一直在“爆表”地工作,这种机制使得Redis的单线程能够轻松应对数万甚至数十万的并发连接,而不会因为网络I/O的等待而阻塞。

第四,Redis在设计上追求简单和可预测性,单线程模型使得整个系统的行为非常确定,没有复杂的并发问题需要处理,这大大降低了系统的复杂度,提升了稳定性,开发者不需要担心因为多线程操作共享数据而引发的各种诡异的bug,这种简单性也使得Redis的代码非常精炼,易于维护和优化,从系统整体来看,这种简单性本身就是一种性能保障。

我们也要看到Redis单线程模型的适用场景,它的高性能是建立在几个前提下的:一是操作尽可能在内存中完成;二是每个操作本身要很快,不能有耗时的命令(比如执行一个复杂的Lua脚本或者一次性获取一个非常大的集合的所有成员);三是CPU通常不是瓶颈,网络带宽和内存大小更可能是限制因素,如果违反了这些前提,比如频繁进行持久化操作(虽然持久化是由子进程或子线程完成,不影响主线程,但会占用磁盘I/O和CPU资源),或者执行了慢查询,那么单线程就会成为瓶颈,因为它会被一个慢任务拖住,导致所有后续请求都被卡住。

Redis单线程却能实现超高吞吐量,并非因为它违反了计算机科学的基本原理,而是通过一系列精心的设计,将单线程的优势发挥到了极致:极致的内存速度 + 高效的数据结构 + 非阻塞的I/O多路复用 + 简洁可控的架构,它巧妙地避开了多线程的复杂性和开销,在一个看似简单的模型下,通过各个环节的紧密配合,最终爆发出令人惊叹的性能,这就像一位武林高手,不依靠繁复的招式,而是将一招一式练到登峰造极,同样能够克敌制胜。

(参考资料:Redis官方文档中关于持久化、复制、Eviction策略的说明;《Redis设计与实现》一书中对Redis数据结构和事件处理机制的详细解读;多位Redis核心开发者在技术演讲和博客中对其架构哲学的阐述。)

本文由芮以莲于2025-12-26发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://waw.haoid.cn/wenda/68472.html