分布式系统到底有什么特别的地方,设计时又得考虑哪些关键点呢?

- 问答

- 2025-12-25 13:13:00

- 2

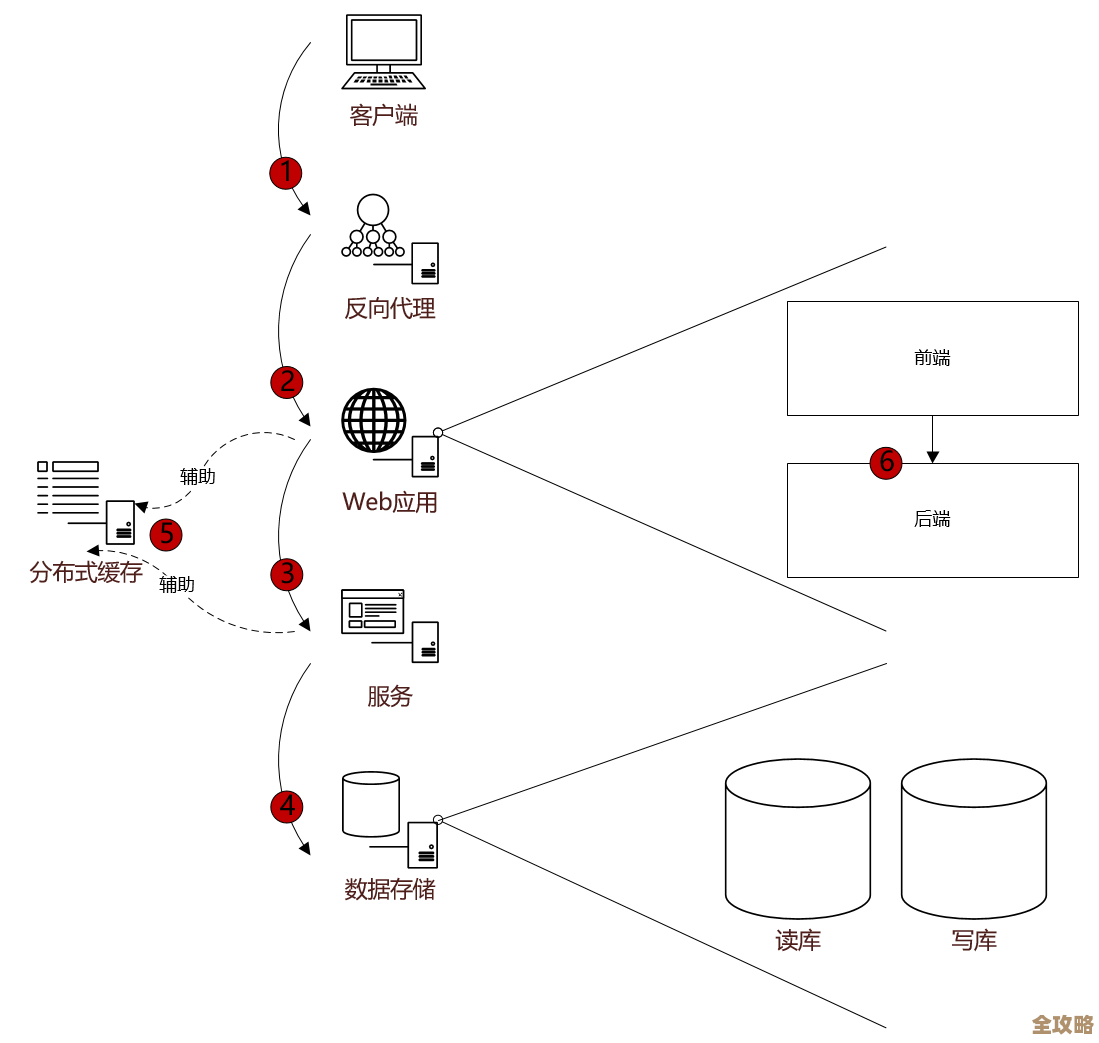

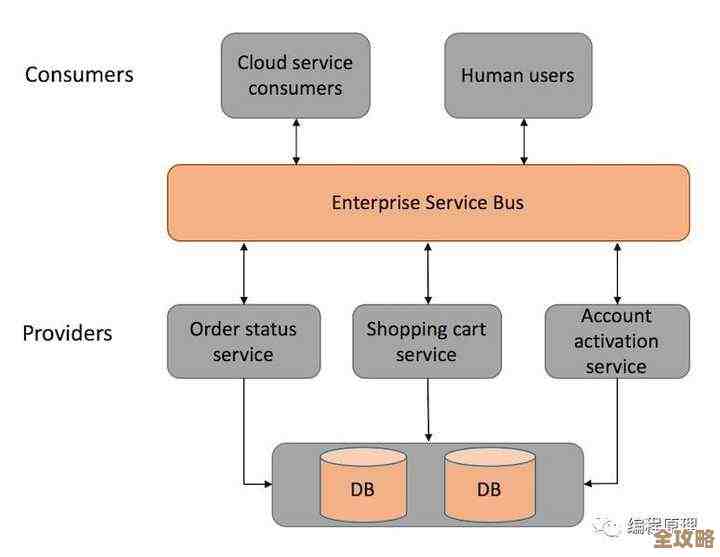

分布式系统之所以特别,首先在于它的基本构成,它不像我们放在桌面上的一台电脑,所有东西都在一个机箱里,分布式系统是由多台独立的计算机,通过网络连接起来,为了一个共同的目标而协同工作的集合,这些计算机可能就在同一个机房,也可能散布在全球各地,这种“分散”的本质,带来了一系列独特的优势和同样独特的挑战。

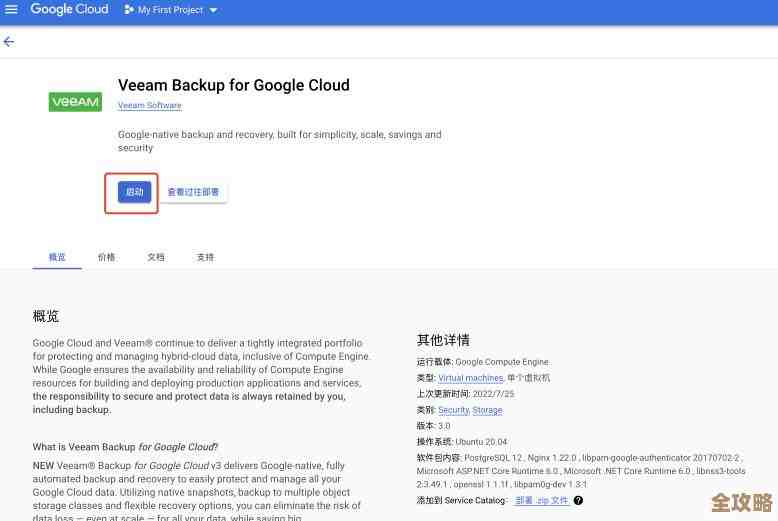

它最吸引人的地方,也就是它的核心优势,主要有三个,第一是强大的扩展性,当用户变多、数据量变大时,如果是一台普通电脑,只能更换更昂贵、更大型的服务器,这叫垂直扩展,有物理和成本的上限,但分布式系统可以通过简单地增加更多的普通计算机来分担压力,这叫水平扩展,理论上可以近乎无限地扩展,第二是高可靠性,单台机器难免会出故障,但如果系统由成百上千台机器组成,即使其中几台甚至几十台坏掉了,整个系统依然可以通过其他正常的机器继续提供服务,不会彻底瘫痪,第三是性能优势,可以将计算任务分散到不同的节点上并行处理,或者将数据分布到离用户更近的地方,从而减少延迟,提高响应速度。

正是这些优势的背后,也隐藏着设计的核心难点,设计分布式系统时,工程师们必须时刻绷紧神经,考虑以下几个关键点,这些也是它特别“磨人”的地方。

首要的关键点是容错与高可用,既然系统由那么多部件组成,故障就从一个“会不会发生”的低概率事件,变成了一个“何时发生”的常态事件,设计时必须假设任何部分都可能随时失效:硬盘会坏、网络会断、服务器会宕机,系统需要有自动检测故障、隔离故障、并从故障中恢复的能力,重要的数据不能只存在一台机器上,必须有多个副本;当一台处理任务的机器宕机时,要有其他机器能立刻接管它的工作,目标是尽可能保证服务不间断,也就是实现高可用。

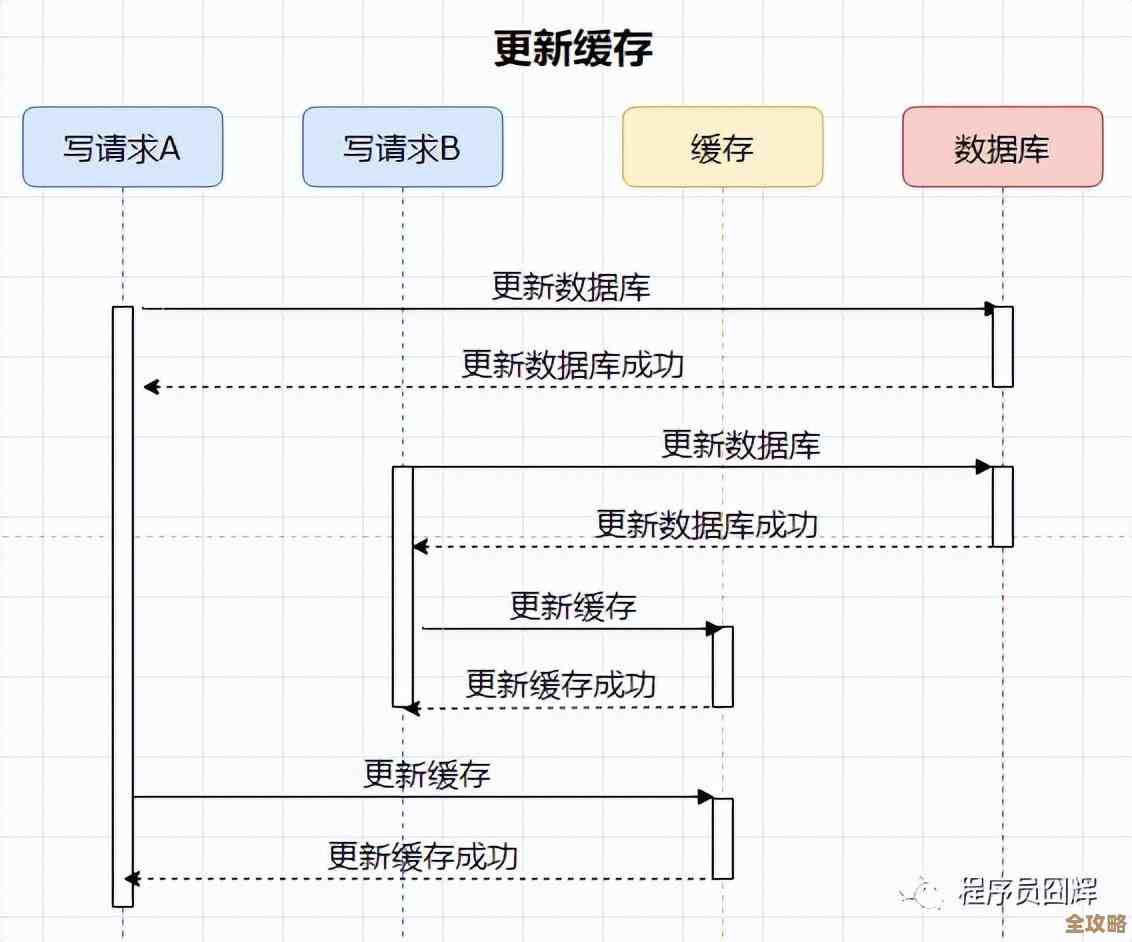

第二个关键点是数据的一致性,这是分布式系统领域最经典、最棘手的问题之一,当一份数据在多个节点上都有副本时,如何保证所有副本都是相同的?如果允许用户向任何一个副本写入数据,那么如何让其他副本同步这个更新?在网络延迟甚至中断的情况下,是优先保证所有副本数据绝对一致(强一致性),但可能会牺牲一些可用性;还是优先保证服务永远可写可读(高可用),但允许短暂的数据不一致(最终一致性)?这就是著名的CAP理论所讨论的权衡,是设计者必须根据业务场景做出的核心决策,银行转账必须强一致性,而社交媒体点赞数可以接受最终一致性。

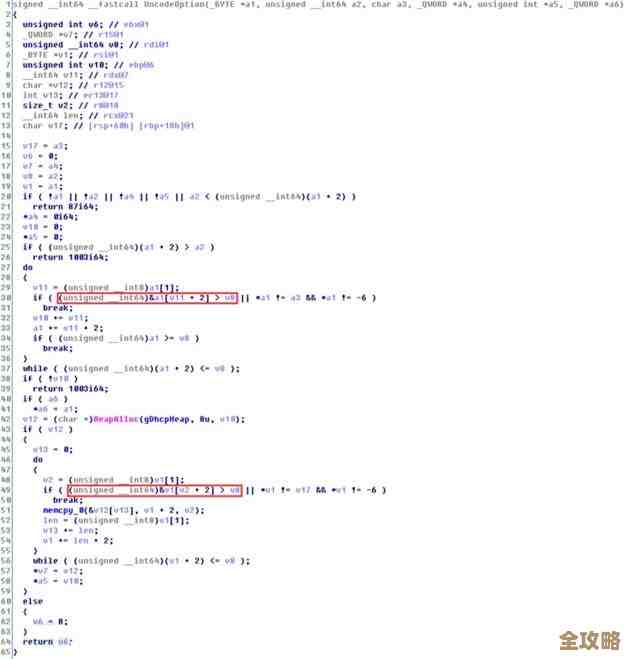

第三个关键点是网络通信的不可靠性,在单机系统里,一个程序调用另一个程序,通信是瞬间且可靠的,但在分布式系统中,所有交互都通过网络,而网络是“不靠谱”的:消息可能会延迟、可能会丢失、也可能会重复,设计时必须考虑这些情况,一个请求发出后没有收到回复,可能是处理慢了(需要等待),也可能是对方彻底宕机了(需要重试或切换节点),如何处理超时、如何设计重试机制、如何避免重复操作,都是至关重要的。

第四个关键点是可扩展性,虽然扩展性是目标,但如何优雅地扩展也是一个设计难点,系统架构必须支持方便地增加或减少机器,而不会导致服务中断或数据混乱,这涉及到如何分布数据(分片策略)、如何分配计算任务(负载均衡)、以及当规模扩大后,如何管理这些成千上万的节点(服务发现与集群管理),一个糟糕的设计可能在规模小时运行良好,一旦扩大就会变得难以维护且性能低下。

第五个关键点是复杂度管理,分布式系统的行为比单机系统复杂得多,难以理解和调试,一个问题出现时,其根源可能涉及网络、存储、计算等多个环节,分布在不同的机器上,强大的监控、日志追踪和诊断工具变得不可或缺,设计时需要为系统的可观测性打下基础,让运维人员能够清晰地知道系统内部正在发生什么。

分布式系统的特别之处在于它用“数量”换取了“能力”,但同时也引入了巨大的复杂性,设计它的过程,本质上就是一个不断在一致性、可用性、容错性、扩展性等多个目标之间进行权衡和取舍的艺术,它要求设计者放弃单机思维,时刻以“万物皆可失效”和“网络不可信”为前提进行思考,通过精心的架构和算法,将一群不可靠的个体,组合成一个相对可靠且强大的整体。 综合了计算机科学中关于分布式系统的普遍原则和理论,如CAP定理、容错理论等,这些是分布式计算领域的基石知识,常见于如《分布式系统概念与设计》、Andrew S. Tanenbaum等人的经典教材以及谷歌、亚马逊等公司分享的工程实践文章中。)

本文由瞿欣合于2025-12-25发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://waw.haoid.cn/wenda/68181.html