内存读取天梯图详解:从底层原理到高效数据获取的关键指引

- 问答

- 2025-09-26 11:00:24

- 3

从底层原理到高效数据获取的关键指引

为什么内存读取速度如此重要?

你有没有遇到过这种情况——程序跑得慢,CPU占用不高,但就是卡?大概率是内存访问拖了后腿。

现代计算机的瓶颈早已不是CPU的计算能力,而是数据搬运的速度,CPU的运算速度比内存快几个数量级,如果内存读取跟不上,CPU就会像个饿肚子的工人,干等数据送过来。

举个例子,我在优化一个图像处理算法时,发现单纯优化计算逻辑只能提升5%的性能,但调整内存访问模式后,速度直接翻倍,这让我意识到,内存读取效率才是真正的隐形杀手。

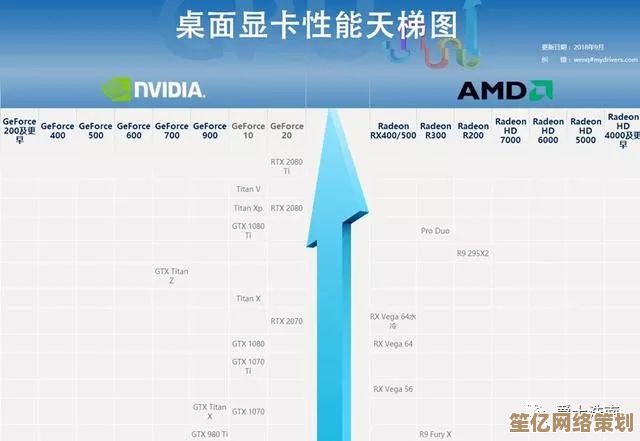

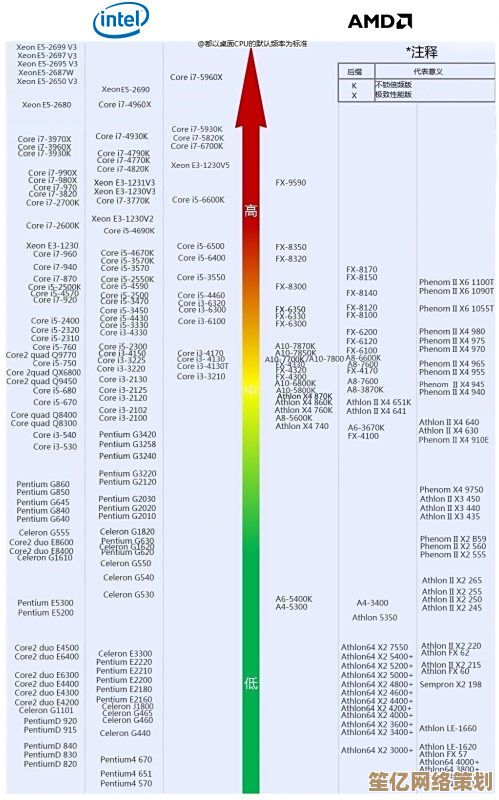

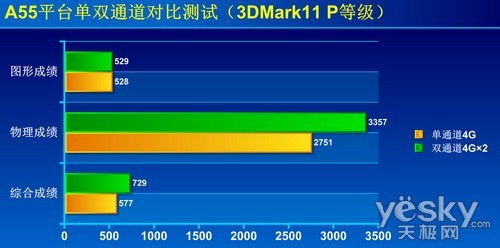

内存读取的“天梯图”:从慢到快

内存访问速度不是均等的,而是一个阶梯式结构,越靠近CPU越快,但容量越小,我们可以用一张“天梯图”来直观理解:

-

硬盘/SSD(最慢,但容量最大)

- 机械硬盘:毫秒级延迟(≈10ms)

- SSD:微秒级(≈100μs)

- 案例:数据库查询如果频繁读硬盘,性能直接崩盘,所以MySQL这类系统会拼命缓存数据到内存。

-

主内存(RAM,比硬盘快1000倍)

- 纳秒级延迟(≈100ns)

- 但和CPU相比,还是太慢了!

-

CPU缓存(L3/L2/L1,速度飙升)

- L3缓存:≈30ns

- L2缓存:≈10ns

- L1缓存:≈1ns

- 关键点:缓存命中率决定性能,如果数据在L1,CPU几乎不用等;如果得去主存拿,那就惨了。

-

寄存器(最快,但数量极少)

- 皮秒级(≈1ps)

- 编译器会尽量把热点变量塞进寄存器,但程序员能直接控制的机会不多。

如何优化内存读取?实战经验

(1)局部性原理:让数据靠近CPU

- 时间局部性:最近访问的数据很可能再次被访问(比如循环变量)。

- 空间局部性:访问某个地址时,附近的数据也可能被用到(比如数组遍历)。

反面案例:

我曾经写过一个遍历二维数组的代码,按列访问(arr[j][i])而不是按行(arr[i][j]),结果性能差了5倍!原因?缓存行(Cache Line)失效。

(2)预取(Prefetching):让CPU提前拿数据

现代CPU会预测你的访问模式,提前加载数据到缓存,但如果你的代码跳来跳去(比如链表遍历),预取就会失效。

优化技巧:

- 尽量用连续内存结构(数组 > 链表)。

- 手动预取(

__builtin_prefetchin GCC)。

(3)避免False Sharing(伪共享)

多线程环境下,如果两个核心频繁修改同一缓存行的不同变量,会导致缓存反复失效。

我的踩坑经历:

有一次写多线程统计,每个线程更新自己的计数器,结果性能还不如单线程!后来发现计数器数组没对齐,导致不同线程的变量挤在同一个缓存行里,互相拖累。

高效内存读取的核心思路

- 减少跳跃访问(让数据尽量连续)。

- 提高缓存命中率(利用局部性)。

- 避免多线程竞争缓存行(对齐、填充)。

内存优化是个细活,但收益巨大。少读一次内存,比优化十行算法代码更管用。

本文由革姣丽于2025-09-26发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://waw.haoid.cn/wenda/10550.html