云计划野良强度2025迭代揭秘:跨平台协作与动态平衡体系

- 游戏攻略

- 2025-09-19 04:52:33

- 26

云计划野良强度2025迭代揭秘:跨平台协作与动态平衡体系的野路子观察

技术迭代像坐过山车,我们都被甩在半山腰

最近被阿里云PolarDB PostgreSQL版的更新日志整懵了——2025年9月刚支持向量索引和NL2SQL,6月就玩起分布式HINT和向量化引擎,3月直接整出时空数据库Ganos 7.4,这更新频率,比我追番换老婆还勤快😅。

记得去年帮某游戏公司调Redis集群,发现"get"操作平均耗时12ms,正常应该2ms以内,当时拿着prometheus监控数据,对着iostat和netstat输出抓耳挠腮,最后发现是TCP窗口大小没调优,现在看2025年白皮书,人家直接用eBPF+BCC工具抓包分析,诊断阶段就给你把瓶颈定位得明明白白。

跨平台协作?我们曾是"鸡同鸭讲"重灾区

去年接手某2025工程项目,团队跨三个时区,用企业微信+Slack+Jira三开,结果:

- 开发说"需求文档在Confluence"

- 产品指着自己的本地Excel说"这里改了需求"

- 测试举着手机喊"你们更新包没传到测试环境"

后来学精了,直接照搬伙伴云提到的某高速公路项目案例——BIM建模提前发现设计冲突,物联网设备24小时监控施工进度,在线协作平台强制所有文档走云端,最后提前两个月交工,成本省了10%,这波操作让我想起某次紧急项目,我们直接在腾讯文档里开实时会议,边改代码边同步注释,比传统代码审查快三倍。

动态平衡体系:像炒菜放盐,得慢慢调

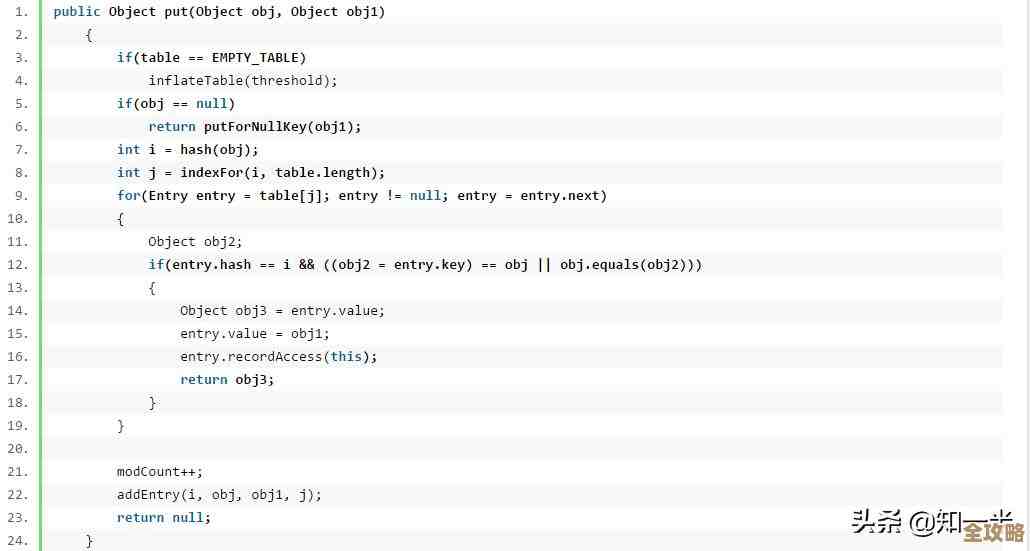

最近帮某社交APP做性能优化,CPU利用率卡在28%不上不下,P99延迟850ms,按照阿里云DIV3调优法:

- 诊断阶段:用OpenTelemetry抓包,发现60%耗时卡在"订单校验"模块

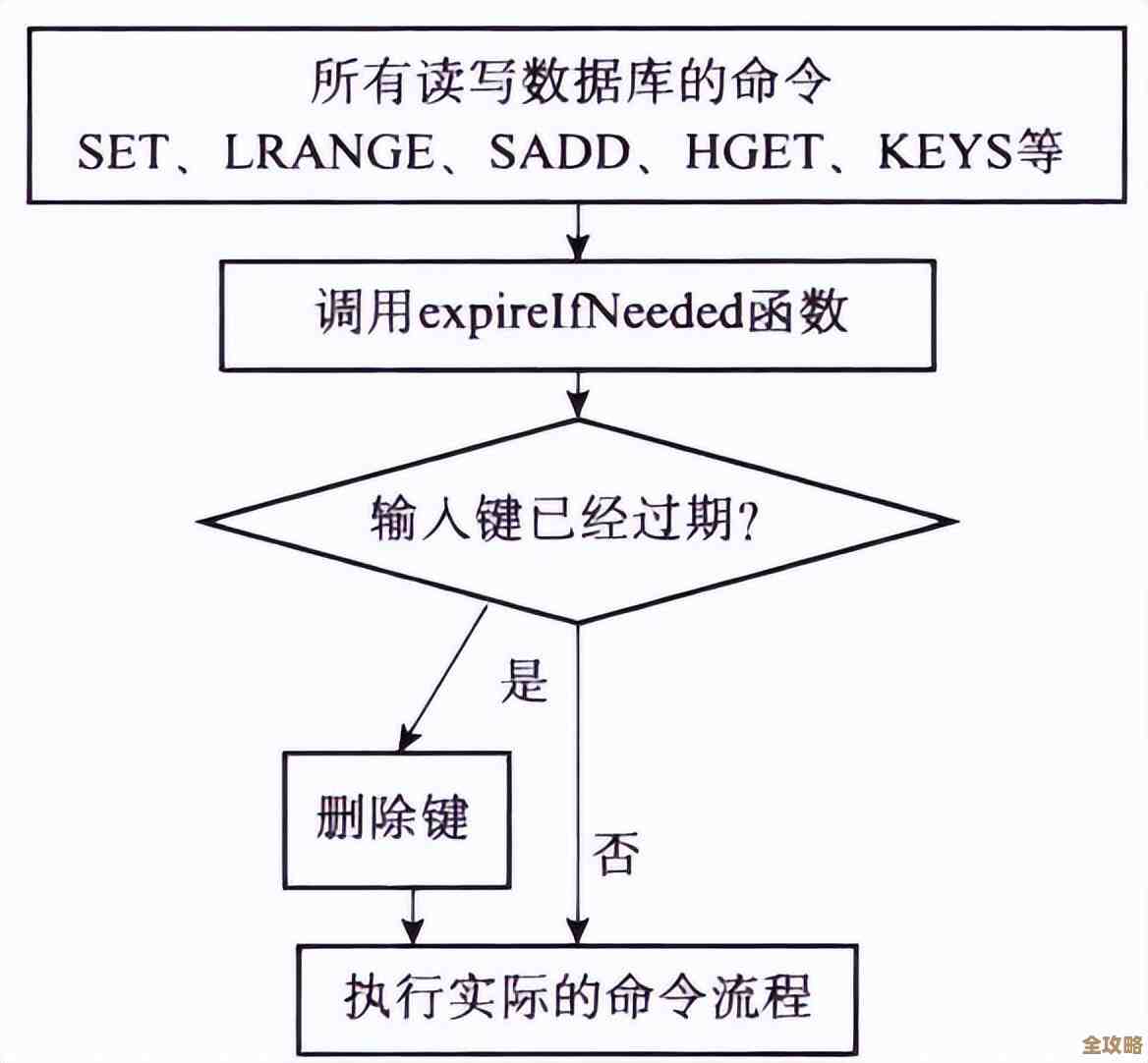

- 迭代阶段:给数据库加覆盖索引,SQL耗时从500ms砍到80ms;Redis缓存失效时间改三级TTL,避免雪崩

- 验证阶段:用Locust压测到200%负载,发现拐点在150%负载时CPU飙到75%

最后CPU利用率提到65%,延迟砍到420ms,单位算力成本降22%,这过程像极了打游戏调画质——先开全低效跑帧数,再逐步开特效找平衡点。

量子计算?我们现在只敢在测试环境玩

看到2025年白皮书提到量子计算优化物流路径,某快递公司用退火算法把全国干线调度时间从6小时砍到20分钟,我们团队也试过用Qiskit跑组合优化,结果:

- 本地模拟器跑100节点问题要3小时

- 实际量子计算机跑同样问题要5分钟(但排队等了2天)

现在学聪明了,只在夜间用云服务商的QaaS平台跑离线任务,这感觉就像小时候偷用老爸的显卡玩游戏——知道它能跑,但不敢真当主力用。

写在最后:我们都在摸着石头过河

最近帮某制造业客户做数字化转型,发现个有趣现象:

- 本地部署派坚持"数据不出机房",结果被合规审计搞得焦头烂额

- 云端协作派嚷嚷"上云即合规",结果被GDPR罚款罚到哭

最后学某跨国企业,用边缘计算+核心云混合架构——常用文档缓存到边缘节点,敏感数据锁在本地存储,这操作让我想起某次紧急排障,我们同时开着云服务器控制台和本地SSH终端,两边数据来回倒腾,活像左右手互搏。

说到底,2025年的云计划野良强度迭代,就像给老房子装智能家电——你得先补好电路(基础设施),再换智能开关(跨平台协作),最后装个能自动调温的AI中枢(动态平衡),过程肯定磕磕绊绊,但回头看,每一步都踩在时代的节点上。

本文由兆如曼于2025-09-19发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://waw.haoid.cn/glgl/2933.html