Tesla GPU天梯图:深度解析各型号性能,精准选购理想显卡

- 游戏动态

- 2025-11-02 20:24:21

- 2

根据超能网和极客湾等科技媒体的评测数据,这里有一份关于Tesla显卡的性能天梯和解析。

Tesla显卡不是给普通玩家打游戏用的,它是专门为数据中心、科研计算和人工智能训练设计的专业卡,看它的性能不能只看图形处理能力,更要看它的计算能力、显存大小和功耗。

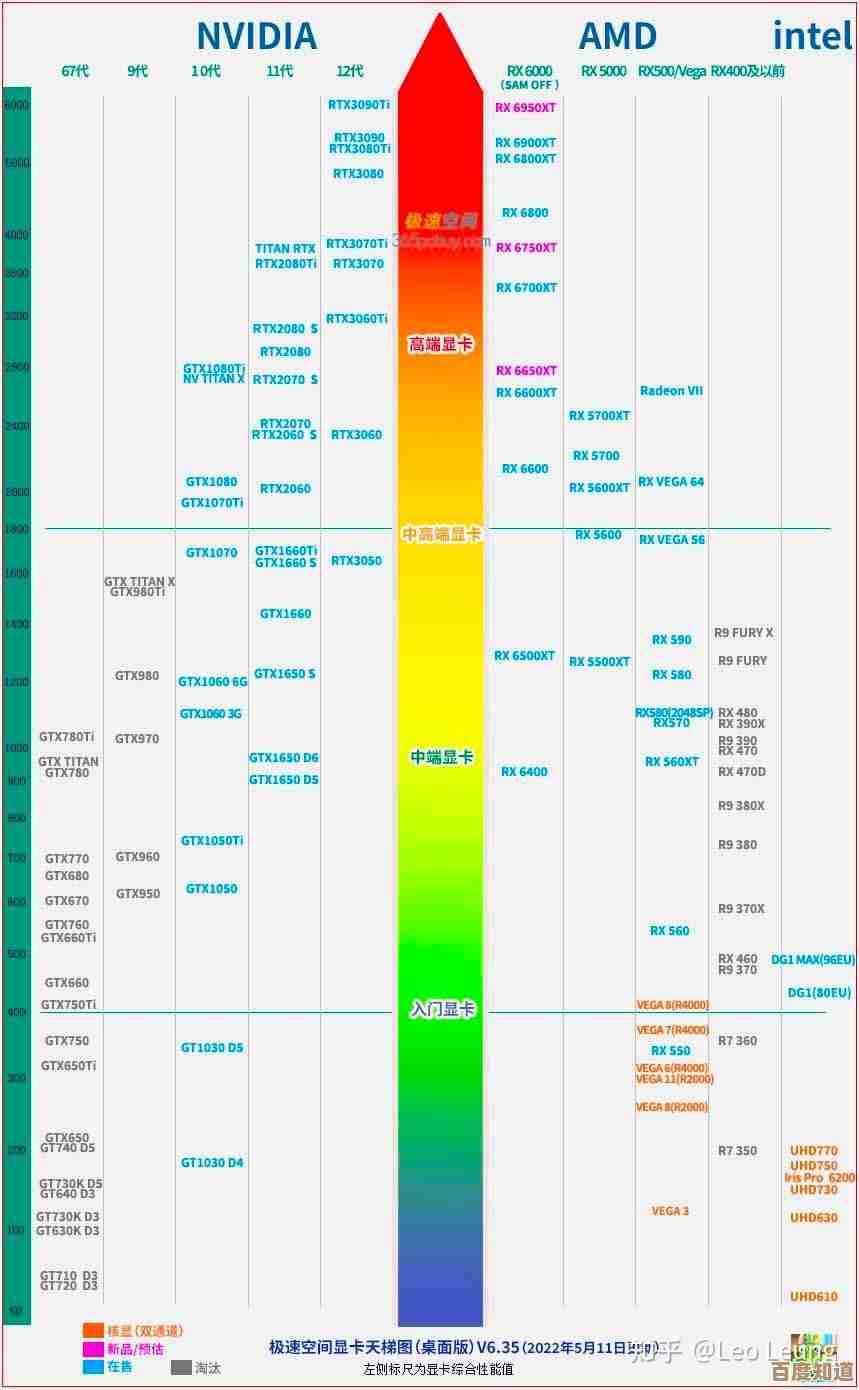

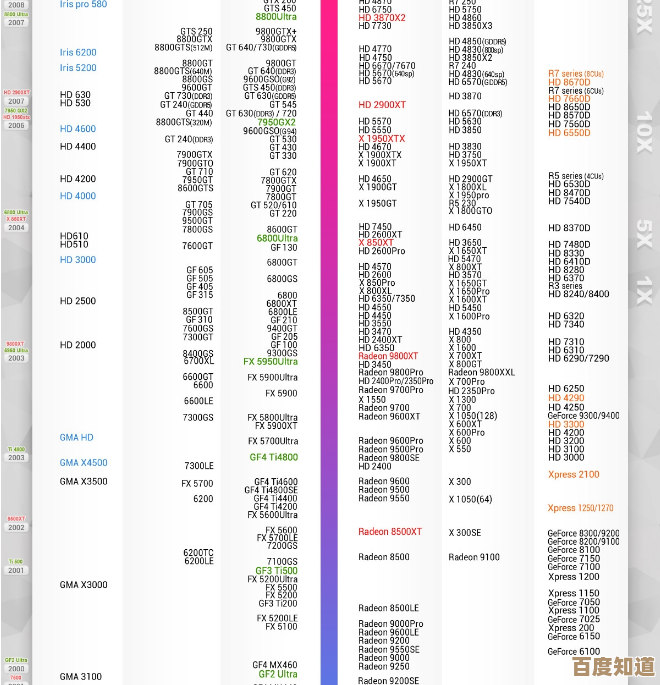

Tesla显卡性能天梯(大致排名,从旧到新,同代按性能排序)

-

入门/早期计算卡:

- Tesla K10:很老的卡了,由两颗GPU组成,主要针对高吞吐量计算,但单精度性能一般。

- Tesla M40:在深度学习刚开始流行时很常用,24GB大显存是它的优势,但架构比较旧。

-

Pascal架构时代(2016年左右):

- Tesla P4:低功耗的小卡,性能一般,但适合边缘推理这种对功耗要求高的场景。

- Tesla P40:可以看作是M40的升级版,同样有24GB大显存,单精度性能有提升,一度是性价比之选。

- Tesla P100:这是当时的旗舰,首次用了HBM2显存,带宽巨大,无论是科学计算还是AI训练都比前代强很多。

-

Volta架构时代(2017年左右):

- Tesla V100:这是一代神卡,它最大的特点是首次加入了“张量核心”,专门用来加速AI计算,在它的时代,几乎所有顶尖的AI模型都是在V100上训练的,即使现在,很多实验室和公司仍然有大量V100在服役,根据超能网的测试,其AI训练性能相比P100有数倍提升。

-

Ampere架构时代(2020年左右):

- Tesla A100:V100的正统接班人,张量核心升级到第三代,支持新的计算格式,显存容量和带宽也大幅提升,是当前数据中心的主流选择。

- Tesla A10:可以看作是A100的“青春版”,面向虚拟化桌面和轻度AI推理。

-

Hopper架构时代(2022年发布):

- Tesla H100:目前的性能王者,专为大规模AI模型训练和高性能计算设计,性能相比A100又有巨大飞跃,根据NVIDIA官方数据和行业评测,它在训练超大规模模型时的效率远超前辈。

如何精准选购理想显卡?

看这个天梯图,你不能只看谁排名高就买谁,得看你的具体需求和预算。

-

你的主要任务是什么?

- AI模型训练:这是最吃性能的,预算充足直接上H100,如果追求性价比,A100是成熟稳定的选择,如果预算非常有限,二手的V100甚至P100也能用来学习和跑一些小模型。

- AI模型推理(部署):对算力要求没训练那么高,但可能要求低延迟、高吞吐。A10、T4(文中未提及但很常用,低功耗推理卡)是不错的选择,甚至一些高端游戏卡也能胜任。

- 科学计算(如流体力学、天气预报):需要高双精度浮点性能。A100和H100在这方面是强项,老一点的P100和V100也还不错。

- 虚拟化/云桌面:主要看图形能力,A10是为此优化的。

-

显存有多大?

- 你训练的模型越大,数据量越多,需要的显存就越大,如果模型太大显存放不下,根本没法跑。V100/A100/H100通常有16GB/40GB/80GB等大显存版本,而P40的24GB显存对于某些需要大显存的非AI任务可能仍有价值。

-

功耗和散热怎么办?

Tesla卡功耗很高,比如A100是300W到400W,H100更是达到700W,你需要确保你的电源带得动,并且机箱散热能跟上,像P4、T4这种功耗低于75W的卡,可以直接插在普通服务器里,不需要额外供电。

-

预算有多少?

- H100:非常昂贵,通常是大型企业和研究机构购买。

- A100:价格依然很高,是主流数据中心的选择。

- V100:二手市场有一定存量,价格相对A100便宜不少,是个人和小团队入门高端AI训练的常见选择。

- P100/P40:非常便宜,但架构老旧,功耗效率低,只适合预算极其有限且对性能要求不高的学习场景。

- 不差钱,追求极致性能:选H100。

- 主流AI训练和计算,平衡性能与成本:选A100。

- 性价比高的AI入门和学习:可以考虑二手V100。

- 主要做AI推理或虚拟化:看看A10或T4。

- 预算非常有限,只是跑跑小实验:老旧的P100或P40也许能凑合,但要做好功耗高、速度慢的心理准备。

最后提醒,购买专业卡还要考虑软件生态和驱动支持,NVIDIA的CUDA平台是目前最主流的,根据IT之家等媒体的报道,选购时也要注意区分是全新卡还是二手翻新卡,以及是否有官方保修。

本文由务依丝于2025-11-02发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://waw.haoid.cn/yxdt/54581.html