云端服务器系统:实现安全可靠的大规模数据管理与存储服务

- 游戏动态

- 2025-10-17 09:58:42

- 4

哎 说到云端服务器系统 这玩意儿现在真是无处不在啊 但真要聊透它 尤其是安全可靠这块 感觉脑子里想法有点乱 得慢慢捋一捋

记得最早接触云存储 还是用某个网盘存照片 那时候哪想过什么安全 就觉得方便 手机一拍自动上传 后来才意识到 照片啊 文件啊 这些数据一旦扔到“云”里 就好像把家当塞进一个看不见的仓库 你完全不知道仓库门锁结不结实 管理员可不可靠 这种不确定性 其实挺让人焦虑的

所以现在搞大规模数据管理 安全肯定是第一位 但安全这个词儿 听起来就挺抽象的 具体到系统层面 我觉得首先得是“防得住” 比如那种加密技术 不是说简单把数据打个包就完事了 得是那种…从你数据离开自己设备那一刻起 就已经是密文了 在传输过程中 还有像SSL/TLS这种协议罩着 像穿了个防弹衣 到了云端存储起来 最好也是零知识加密 连服务商自己都看不到你的原始内容 钥匙永远在你手里 这样万一他们那边出点啥纰漏 你的东西也不至于裸奔 对吧?🤔

不过光防着外面也不行 内部也得稳 这就说到可靠性了 我总觉得 可靠这词儿 背后是一大堆特别枯燥但又至关重要的细节 比如数据冗余 简单说就是同一份数据 会在不同地方存好几个副本 可能东边存一份 西边也存一份 甚至跨不同机房 不同城市 这样哪怕一个地方地震了 洪水了 或者干脆断电了 你的数据还能从别的地方拉起来 这种设计 想想其实挺牛的 它承认了故障是必然发生的 而不是试图去创造一个永不犯错的神话系统

还有容灾备份机制 这玩意儿就像给数据买保险 定期给你做个快照 万一哪天哪个程序员手滑 误删了关键库(这种事儿新闻里可不少见)或者中了勒索病毒 还能回溯到某个健康的时间点 把损失降到最低 备份策略也挺有讲究的 是全量备份还是增量备份 频率多高 保留多久 这些细节堆起来 才构成了那种“可靠”的踏实感

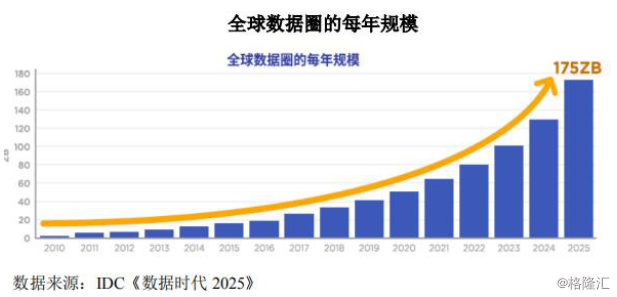

说到大规模 这个尺度感就很难把握了 不是几台几十台服务器 而是成千上万台机器协同工作 这里面最头疼的估计是负载均衡 得有个聪明的调度系统 像交通指挥中心一样 把海量的数据访问请求合理地分流到不同的服务器上 避免有的机器忙死 有的闲得冒泡 不然用户体验可就太糟糕了 卡顿、延迟 分分钟让人想摔鼠标 这个平衡术 背后是实时的监控和复杂的算法

哦对了 还有一致性难题 当你的数据遍布全球多个节点 如何保证用户在北京修改了文件 下一秒在纽约打开看到的就是最新版本 而不是旧缓存 这需要像Paxos或者Raft这类共识算法来协调 听着就挺烧脑的 但做不到这点 所谓的大规模服务就是个笑话

成本也是个现实问题 数据量一大 存储和带宽的费用就蹭蹭往上涨 服务商肯定得想办法优化 比如用更高效的压缩算法 或者搞冷热数据分层 经常访问的热数据放在高性能但贵的SSD上 那些几年不动一次的陈年老数据 就扔到磁带库或者更便宜的冷存储里 节省成本 但这种切换要平滑 不能用户想访问个旧档案 还得等半天才能“解冻”出来

安全方面 除了技术 人的因素也太关键了 再坚固的堡垒也可能从内部被攻破 所以严格的权限管理 最小权限原则(只给每个账号刚刚够用的权限)多因素认证 还有对运维人员操作的审计日志 这些都必不可少 有时候想想 维护这么一个系统 真得像守护一个超级精密的生态系统 时刻警惕着

最后扯点虚的 我觉得吧 追求绝对的安全可靠可能是个伪命题 就像没有绝对安全的城市 关键是建立一套快速响应和恢复的机制 出了事能第一时间发现 定位 然后像细胞自愈一样赶紧修复 把影响控制在最小范围 同时保持透明 及时告知用户发生了什么 正在怎么处理 这种坦诚 或许比任何技术指标都更能建立信任

不知不觉扯了这么多 其实都是些零碎的想法 云端服务器系统这个领域 技术迭代太快了 今天觉得牢不可破的方案 明天可能就有新的挑战 但正是这种不断解决问题、打补丁、升级的过程 让这件事充满了…嗯…一种笨拙又执着的魅力?😂 反正 能让用户几乎无感地、安心地把数据托付过来 就是最大的成功了 虽然这条路 永远没有终点

本文由韦斌于2025-10-17发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://waw.haoid.cn/yxdt/29545.html