远程主机关闭连接的故障诊断与解决方案

- 问答

- 2025-09-25 11:03:29

- 1

当远程主机突然"翻脸":一场关于断连的暴躁诊断实录

😤 你有没有经历过这种抓狂时刻?——正SSH连服务器敲代码敲得飞起,突然蹦出个"Connection closed by remote host"(远程主机关闭连接),屏幕一黑,仿佛整个世界都在嘲笑你,更气人的是,这破问题还™️毫无规律!今天我就来聊聊这个让人血压飙升的故障,顺便分享几个我踩坑踩出来的野路子解法。

先别砸键盘,看看日志!

(虽然我知道你现在很想砸)

远程主机不会无缘无故踢人,/var/log/auth.log(Linux)或/var/log/secure(CentOS)通常是第一个该查的地方,有一次我疯狂被踢,翻日志才发现是sshd_config里MaxSessions设得太低,系统以为我在搞爆破,直接把我ban了……

sudo tail -f /var/log/auth.log | grep sshd

(如果看到"Disconnected: Too many open sessions"之类的,恭喜,找到罪魁祸首了🎉)

防火墙?不,是"防我墙"!

某些云厂商(比如某里云、某讯云)的默认安全组规则简直反人类😅,有一次我死活连不上自己的ECS,折腾半天才发现是安全组里SSH默认只放行了22端口,但我的sshd改成了2222……

解决方案:

- 检查云控制台的安全组规则

- 本地用

telnet IP 端口测试连通性(连不上?那就是防火墙/安全组的锅)

玄学重灾区:SSH超时配置

有些管理员喜欢在/etc/ssh/sshd_config里加这种阴间配置:

ClientAliveInterval 30 ClientAliveCountMax 3

意思是"30秒没动静就发个心跳包,连续3次没回应就断你连接",如果你网络稍微抖一下……啪,没了!

暴躁解法:

- 本地SSH配置加个

ServerAliveInterval 60,主动喂心跳包保活 - 或者直接

ssh -o ServerAliveInterval=60 user@host(临时救急)

内存炸了?OOM Killer来补刀

有一次我连服务器跑大数据任务,突然被踢,查/var/log/syslog发现一行惊悚记录:

"Out of memory: Kill process 1234 (sshd) score 123"

好家伙,内存爆了,系统优先把SSH进程杀了💀……

应对方案:

free -h看看内存余量- 用

tmux或screen托管会话(就算被踢也能重新attach回来)

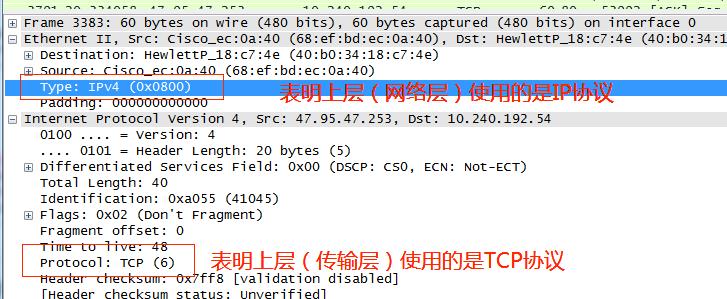

终极玄学:TCP Keepalive的阴谋

某些网络设备(比如NAT路由器)会偷偷掐掉"不活跃"的TCP连接,你以为SSH还活着,其实中间早就被运营商/防火墙截胡了🤡。

解决方案(简单粗暴版):

ssh -o TCPKeepAlive=yes -o ServerAliveInterval=30 user@host

或者直接改本地~/.ssh/config,给所有连接加保活参数:

Host * TCPKeepAlive yes ServerAliveInterval 30

与断连共存的哲学

说实话,远程连接这玩意儿就像异地恋💔——你永远不知道对方什么时候突然消失,但至少,我们可以多留几个后路:tmux保会话、autossh自动重连、写个监控脚本邮件报警……

(对了,如果你发现断连时伴随着"Broken pipe"错误,大概率是网络问题,这时候……除了骂运营商,还能干啥呢?🤷♂️)

附:我的个人暴论

云服务商总爱把简单问题复杂化,什么VPC、安全组、弹性网卡……搞一堆概念就为了让你多买点"高级网络服务"。😒 有时候问题根本不是技术问题,而是阅读理解题——得把他们文档里藏着的免责声明挖出来才能破案。

(完)

本文由畅苗于2025-09-25发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://waw.haoid.cn/wenda/9498.html