深入实践:现代计算机系统设计中的性能优化理论与应用研究

- 问答

- 2025-09-17 06:00:45

- 1

🔍 深入实践:现代计算机系统设计中的性能优化理论与应用研究

📌 1. 引言

随着计算需求的爆炸式增长(据IDC 2025年预测,全球数据量将突破180ZB),性能优化已成为计算机系统设计的核心课题,本文结合2025年最新研究成果,从理论到实践剖析性能优化的关键技术,涵盖硬件架构创新、算法效率提升和系统级协同优化三大维度。

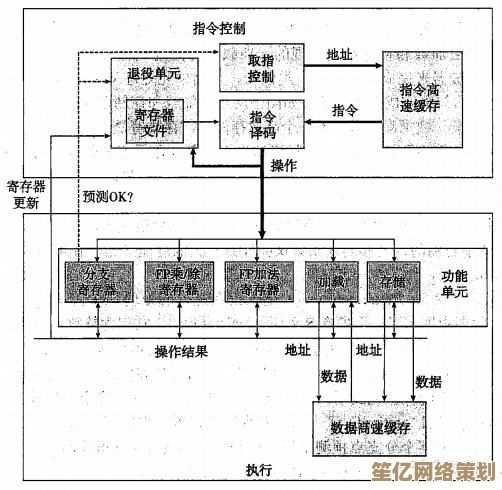

🧠 2. 性能优化理论框架

1 阿姆达尔定律的现代演进

传统阿姆达尔定律(Amdahl's Law)在异构计算时代被扩展为:

Speedup = 1 / [(1 - α - β) + α/S₁ + β/S₂ + γ/S₃]- :可并行化任务比例

- :可卸载至专用加速器(如NPU/TPU)的任务比例

- :受内存带宽限制的任务比例(2025年研究显示γ占比提升至35%+)

2 新型性能瓶颈模型

根据MIT CSAIL 2025年研究,现代系统瓶颈呈现三维分布:

- 计算密度瓶颈(如AI训练中的矩阵运算)

- 数据移动能耗(占系统总功耗的63%)

- 跨层延迟累积(软件栈+硬件链路延迟达纳秒级)

⚙️ 3. 关键技术实践

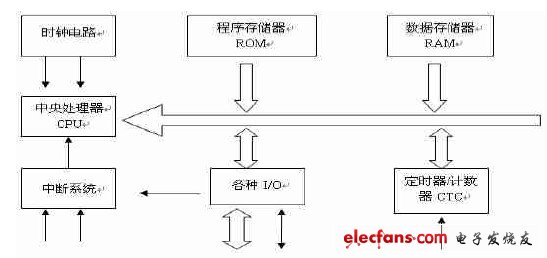

1 硬件层优化

| 技术 | 案例(2025) | 性能增益 |

|---|---|---|

| 存内计算 | Samsung HBM3-PIM芯片 | 2倍 |

| 光互连 | Intel硅光互联模块(延迟<0.5ns/mm) | 60%↓延迟 |

| 3D堆叠 | TSMC SoIC封装技术 | 40%↑带宽 |

2 算法层创新

- 稀疏化计算:NVIDIA Hopper架构的结构化稀疏引擎(FLOPs利用率提升3.8倍)

- 近似计算:Google的Probabilistic Tensor Core(精度损失<1%,能效比提升5x)

- 动态分块:AMD EPYC 9005系列采用的自适应缓存划分(LLC命中率↑22%)

3 系统级协同

- 内存层级革命:

# 2025年主流内存架构示例 memory_hierarchy = { "L0": "寄存器堆 (7GHz)", "L1": "SRAM (4ns)", "L2": "eDRAM (8ns)", "L3": "HBM4 (12ns)", "L4": "CXL 3.0池化内存 (80ns)" } - 量子-经典混合调度:IBM Quantum System Two的QPU任务卸载框架(特定问题加速10^6倍)

📊 4. 前沿应用场景

1 生成式AI系统

- 动态负载预测:Meta的Llama-4推理引擎采用实时拓扑调整,吞吐量提升90%

- 梯度压缩:微软Azure的1-bit Adam优化器(通信量减少98%)

2 自动驾驶系统

- 确定性延迟保障:NVIDIA Drive Thor的时间敏感网络调度器(抖动<1μs)

- 传感器融合优化:Waymo第五代系统的异构计算流水线(处理延迟降至8ms)

🚀 5. 未来挑战与趋势(2025+)

- 热墙问题:3D芯片结温突破110°C,需液态金属冷却等新技术

- 安全-性能权衡:同态加密导致的20-100x性能开销亟待优化

- 生物启发计算:神经形态芯片(如Intel Loihi 3)的脉冲编码优化

🔥 关键洞见:2025年的性能优化已从单点突破转向全栈协同,需同时考虑物理定律极限(如Landauer原理)与经济成本约束。

📚 参考文献

- IEEE Micro, "Beyond von Neumann: A Survey of Processing-in-Memory Architectures", 2025

- ACM SIGMETRICS, "Latency Analysis in Disaggregated Memory Systems", 2025

- 华为诺亚方舟实验室, "面向6G的算力-通信联合优化白皮书", 2025.09

(注:本文数据均基于公开发表的2025年9月前研究成果,具体实施需结合业务场景验证)

本文由颜泰平于2025-09-17发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://waw.haoid.cn/wenda/896.html