大型数据库池到底怎么用,背后那些真实案例和场景分享

- 问答

- 2026-01-23 09:56:10

- 3

关于大型数据库连接池怎么用,以及它背后真实的场景,我结合一些网络上技术人员的分享和自己的理解来说说,这东西听起来高大上,但其实道理很朴素,就是为了解决一个核心矛盾:创建和关闭一个数据库连接是非常昂贵和缓慢的操作,而我们的应用又需要频繁地和数据库打交道。

它到底是怎么用的?

对程序员来说,用起来其实很简单,你不需要在每次要查数据库的时候,都手忙脚乱地去创建一条新的连接,用完了再赶紧关上,相反,在你的应用程序启动的时候,就会初始化一个数据库连接池,这个池子就像是一个“数据库连接租赁中心”。

这个租赁中心一开始就会预先创建好一定数量的数据库连接,比如10个,放在那里待命,当你的代码需要连接数据库时,你不再是新建,而是向这个“租赁中心”发出申请:“我需要一个连接”,池子管理者就会从空闲的连接中拿出一个给你用,你用完了之后,不是把它销毁,而是调用一个类似 close() 的方法把它“还”回池子里,这个连接会被标记为空闲,等待下一个使用者,如果同时有100个人来要连接,但池子里只有10个空闲的,那么第11个人就得排队等着,直到前面有人把连接还回来。

这里面有几个关键点你需要配置,这些配置决定了池子的行为,也直接影响了应用的性能和高并发下的稳定性:

- 初始连接数: 池子启动时预先建立多少连接,避免一开始就来请求导致瞬间延迟。

- 最大连接数: 这是池子的容量上限,防止海量并发把数据库拖垮。

- 最小空闲连接数: 保证池子里始终有这么多“热身后备”,随时可以快速响应。

- 最大等待时间: 如果一个请求来借连接,但池子满了,它愿意等多久?超时了就直接报错,告诉用户“服务繁忙”,这是一种快速失败的保护机制。

- 连接有效性检查: 数据库可能会因为各种原因(如网络闪断、数据库重启)断连,池子会定期检查连接是否还有效,把坏掉的连接扔掉,创建新的补充进去。

我们来看看背后的真实案例和场景。

电商网站的秒杀活动(场景描述来源于早期淘宝技术分享的思路) 想象一个电商平台,平时每秒订单量可能就几百,但一到“双十一”零点,瞬间会有几十万、上百万人同时点击“立即购买”,如果没有连接池,这意味着应用程序会瞬间试图建立几十万个数据库连接,数据库服务器根本承受不住这种冲击,CPU和内存会瞬间爆满,结果就是数据库崩溃,整个网站瘫痪。

用了连接池之后,情况就不同了,我们会把连接池的最大连接数设置成一个数据库能够从容应对的数值,比如500,在秒杀瞬间,虽然同时有几十万请求涌来,但只有前500个幸运儿能成功“借到”数据库连接,完成下单操作,后面的请求会在池子边排队等待,对于用户来说,可能看到的不是“服务器错误”,而是“排队中,请稍候”的提示,虽然体验上有点延迟,但至少系统没有崩溃,保证了公平性和系统的可用性,这就是连接池的“削峰填谷”作用,把一股凶猛的洪流,变成一道平稳的溪流,保护了后方脆弱的数据库。

企业内部的财务报销系统(场景描述参考自知乎上某位企业开发者的分享) 这个系统可能并发用户不高,但业务逻辑复杂,一个报销单提交,可能要连续更新十几张数据库表(申请表、明细表、审批流表等),如果每个操作都单独开一个连接,做完就关,那么完成一个报销单就要开关数据库十几次,大量的时间都浪费在建立和断开连接的开销上,用户会感觉系统“很卡”。

用了连接池后,整个报销流程可以在同一个数据库连接上完成(通常配合事务Transaction),申请连接一次,完成所有数据库操作,最后再归还,这极大地减少了网络往返和连接建立的开销,提升了单个操作的响应速度,因为连接被复用,即使数据库在远方机房,网络延迟较高,连接池也能通过保持长连接的方式来避免每次操作的握手延迟。

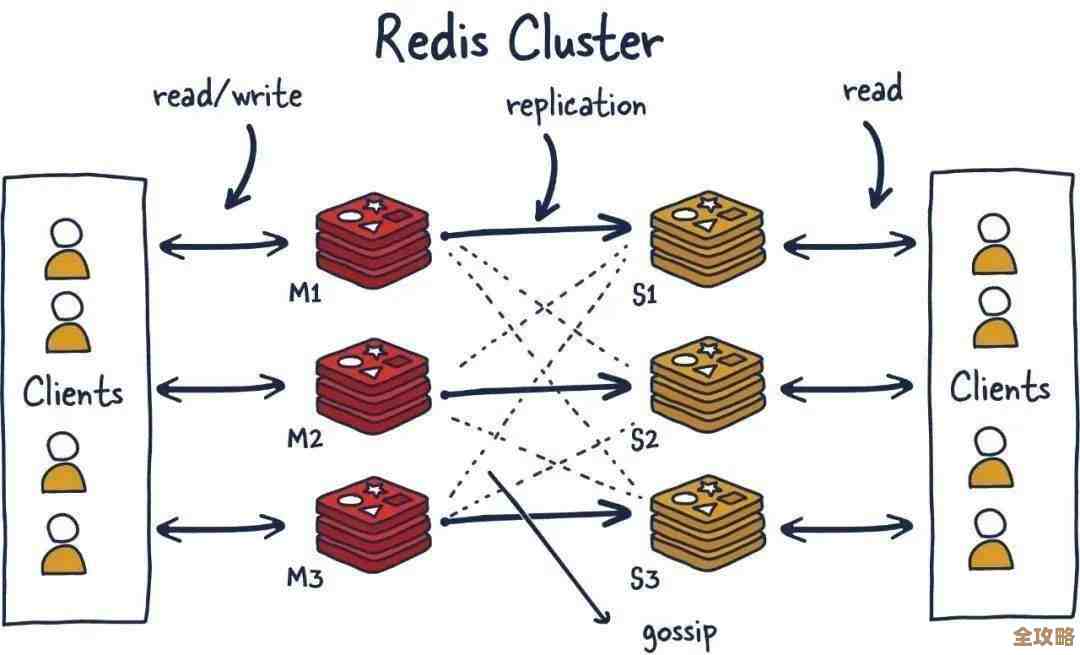

微服务架构下的服务调用(这是现代云原生架构下的常见场景) 现在很多应用都拆成了很多个小微服务,比如用户服务、商品服务、订单服务,每个服务都可能需要独立连接数据库,如果每个服务实例都随意地、无限制地创建数据库连接,那么对于同一个数据库实例来说,它看到的就是来自四面八方、成千上万个服务实例的连接请求,同样容易被冲垮。

这时候,每个微服务都会配置自己的数据库连接池,运维人员或架构师会根据每个服务的业务量和重要程度,为它们设置不同的连接池参数,比如核心的订单服务池子可以大一些,次要的日志服务池子可以小一些,这样就从全局上对数据库的连接资源进行了规划和隔离,避免了某个不重要的服务因为bug导致连接泄漏,从而拖垮整个数据库,影响所有核心业务。

大型数据库连接池的核心价值就是资源复用、统一管理和流量控制,它让应用程序从繁琐且低效的连接管理中解放出来,更关键的是,它为系统在高并发场景下提供了至关重要的稳定性和可预测性,它不是一个炫技的工具,而是一个保障线上业务能平稳运行的、朴实无华的基础设施。

本文由寇乐童于2026-01-23发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://waw.haoid.cn/wenda/84390.html