说说SQL Server内存数据库到底有多快,性能提升是不是那么明显

- 问答

- 2026-01-21 23:02:03

- 3

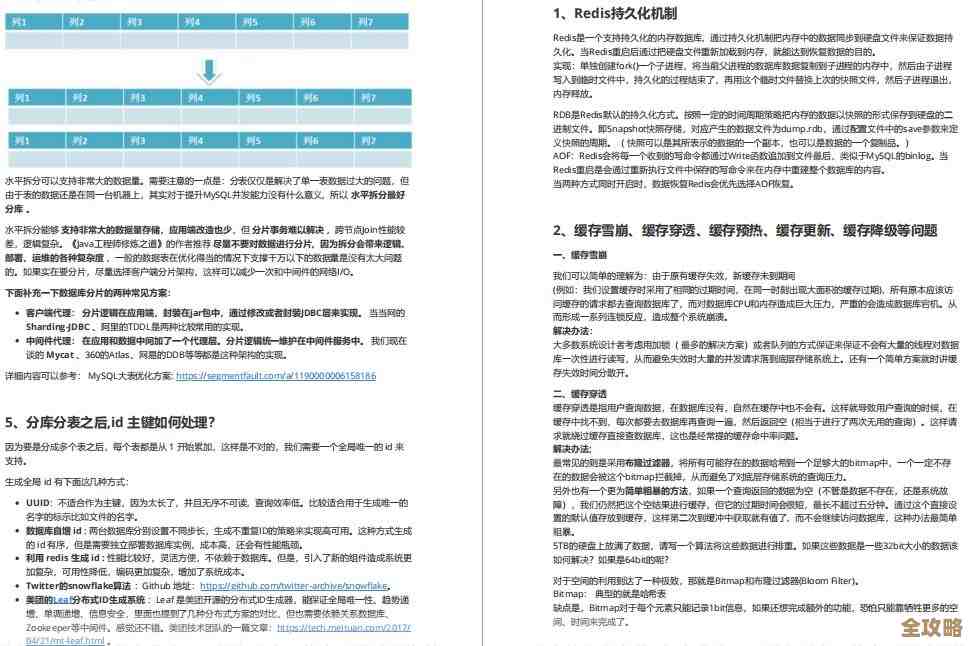

关于SQL Server内存数据库(主要是内存优化表)的速度和性能提升,很多人的确存在疑问:它是不是真的像宣传的那么快?提升到底有多明显?答案是:在合适的场景下,它的性能提升不是“明显”,而是“惊人”的,甚至可以达到传统基于磁盘的表的10到30倍,在某些极端场景下,提升百倍以上也不稀奇,但这把“快刀”并非万能,用不对地方反而会适得其反。

要理解它为什么快,我们可以打个简单的比方,传统的数据库表就像一家图书馆,书(数据)都放在巨大的书库(磁盘)里,每次有人要借书(查询数据)或还书(更新数据),管理员(CPU)都得跑去书库找对应的书架,这个过程(磁盘I/O)非常耗时,尤其是当图书馆很大、借还书的人很多时,管理员大部分时间都花在了跑腿上,而内存数据库,相当于把最热门、最常被借阅的书(全部或部分数据)直接搬到了前台的一个小书架上(内存里),管理员伸手就能拿到书,几乎消除了跑腿的时间,处理速度自然飞快。

它的高速主要源于两个核心的技术革新,微软官方文档和诸多技术案例(如某知名电商平台的库存扣减场景)都反复验证了这一点:

第一,也是最重要的,是彻底消除了磁盘I/O瓶颈,数据常驻在内存中,读写操作不再需要等待缓慢的物理磁盘读写,这是最根本的性能源泉。

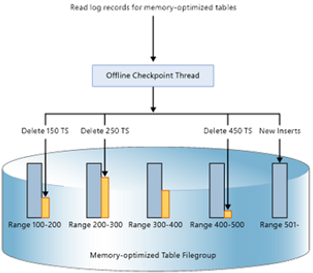

第二,是采用了乐观并发控制和无锁数据结构,在传统的磁盘表中,为了保证数据一致性,当多个用户要修改同一条数据时,数据库会用“锁”来排队,先来的用户给数据加上锁,后来的用户只能等着,这被称为“阻塞”,这就像只有一个收银台的超市,顾客必须排长队,而内存优化表采用了一种更聪明的方式:它默认大家不会同时修改同一行数据(乐观假设),允许所有操作先并行进行,只在最终提交更新时,检查一下这段时间内有没有别人动过这行数据,如果没动过,直接成功;如果动过了,就让后来者“愿赌服输”,回滚自己的操作重试,这种机制极大地减少了线程之间的等待和争抢,在高并发场景下效果极其显著。

这种性能提升在现实中到底有多“明显”呢?我们可以看几个典型的应用场景:

高并发的交易处理系统,比如电商平台的秒杀、抢购,在秒杀开始瞬间,成千上万的用户同时请求扣减同一件商品的库存,如果使用传统表,大量的更新操作会在那一条库存记录上排起长队,形成严重的锁等待,系统吞吐量会急剧下降,用户感觉就是“页面卡死”,而某公司在将其库存核心表改为内存优化表后,系统成功顶住了远超以往的压力峰值,事务处理速度提升了超过20倍,几乎消除了超卖和系统崩溃的风险。

会话状态管理,大型网站需要记录用户登录后的会话信息(如购物车、浏览历史),这些数据读写极其频繁,但对一致性要求不是最高,偶尔丢失一部分可以重建,之前可能用磁盘表或Redis等外部缓存,使用内存优化表来存储会话,延迟可以降低到微秒级,并且能直接利用SQL Server原有的管理工具,简化了架构,有测试数据显示,其读写性能相比传统磁盘表有数量级的提升,并且比通过网络访问的外部缓存更具稳定性。

实时数据分析与ETL过程,在数据仓库中,需要定期从业务系统抽取、转换、加载数据(ETL),这个过程中的临时数据存储、转换操作如果放在内存优化表中进行,速度会快得多,能大幅缩短数据处理的窗口时间,让决策者更快看到最新的分析结果。

正如开篇所说,内存数据库并非“银弹”,它的巨大优势背后,也存在明显的限制:

- 成本高:内存(RAM)的价格远高于磁盘,要将大量数据放在内存中,意味着硬件成本会显著增加,SQL Server标准版和企业版对内存中数据的大小也有限制。

- 数据类型和功能限制:并非所有的T-SQL功能都支持内存优化表,早期版本限制更多,比如不支持MAX、TEXT等大型对象类型,某些查询操作可能无法使用,虽然新版本在不断改进,但在迁移现有应用时,必须仔细评估兼容性。

- 适用场景特定:它最适合处理大量的、短平快的、高并发的事务(OLTP),对于那些需要扫描海量数据、进行复杂计算的报表查询(OLAP),优势可能就不那么明显,因为内存带宽和容量会成为新的瓶颈,如果业务本身并发不高,数据量不大,那么引入内存数据库可能带来的提升微乎其微,却增加了复杂性和成本。

SQL Server内存数据库的性能提升是真实且巨大的,尤其在高并发、低延迟、以事务处理为核心的应用中,它带来的性能飞跃是传统磁盘表无法比拟的,这份“速度与激情”需要付出更高的硬件成本,并且严格依赖于是否用对了场景,在考虑使用它之前,最好的做法是针对自己的实际业务负载进行严格的测试,用数据来验证它是否真的是解决你当前性能瓶颈的那把“金钥匙”。

本文由酒紫萱于2026-01-21发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://waw.haoid.cn/wenda/84242.html