Docker和k8s容器云建设里那些让人头疼的难点和坑你知道几个

- 问答

- 2026-01-19 22:13:49

- 3

根据社区实践和专家分享(如知乎专栏“容器时代的进阶之路”、InfoQ技术文章等),在建设Docker和Kubernetes容器云平台的过程中,会遇到很多让人头疼的难点和坑,这些麻烦事儿往往不是在简单的单机Docker测试时能遇到的,而是在追求规模化、生产级部署时才集中爆发。

第一,网络方案的选型和排障,简直是噩梦的开始。 Docker自带的网络功能很基础,一旦涉及到多主机通信、网络策略控制、与服务发现集成,就必须引入第三方网络插件,比如Calico、Flannel、Weave等,选哪个?每个方案的工作原理都不一样,有基于VxLAN的,有基于BGP路由协议的,这对运维团队的网络知识要求很高,最头疼的是出了问题怎么排查,当一个Pod无法访问另一个Pod,或者服务无法被外部访问时,你面临的排查链路非常长:需要检查Pod本身的状态、Service的Endpoints是否正确、Ingress控制器是否正常、CNI插件是否在节点上正确配置了路由规则、底层网络设备(如防火墙)是否有拦截,这其中的每一环都可能出问题,而且现象可能一模一样,定位起来非常耗时耗力,有团队分享过(如某电商公司的技术博客),他们在初期就曾因为一个微小的MTU(最大传输单元)不匹配问题,导致网络性能极不稳定,排查了整整一周。

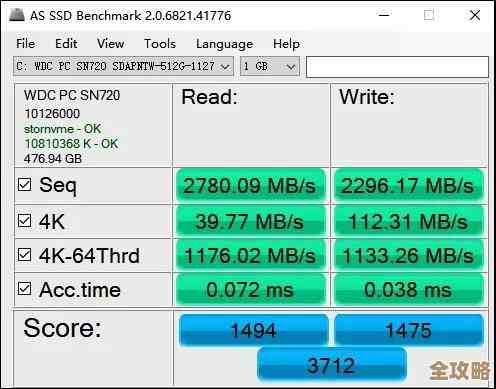

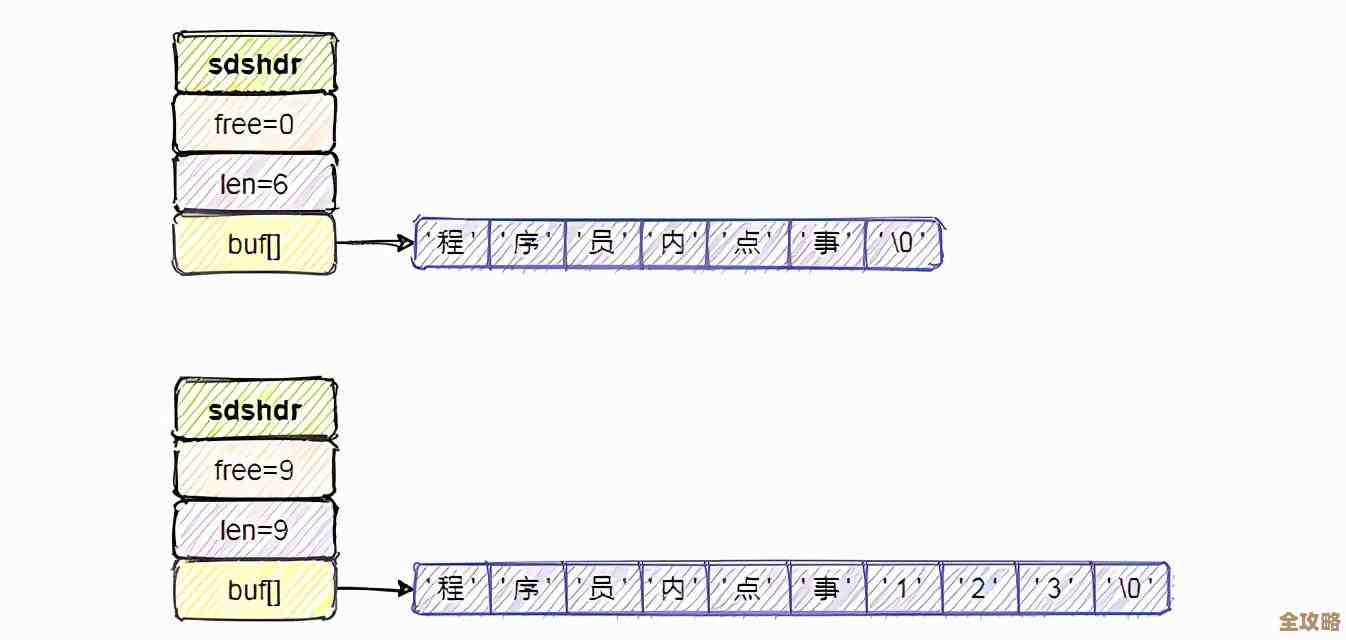

第二,存储管理的复杂性超乎想象。 “有状态应用”是容器化道路上的一块硬骨头,Docker的理念是“容器即牲口”,随时可以销毁重建,但数据库、中间件这类应用的数据是需要持久化的,K8s提供了Persistent Volume(PV)和Persistent Volume Claim(PVC)的概念来解耦存储需求和具体实现,但这又引入了新的复杂度,你需要决定使用哪种存储类型:是本地硬盘(性能好,但无法随Pod迁移)还是网络存储(如NFS、Ceph、云厂商的云盘)?网络存储的性能、可靠性和成本如何权衡?更麻烦的是“状态”不仅包括存储卷,还包括应用的拓扑状态和存储状态,一个ZooKeeper集群,每个节点都有唯一的ID,并且知道其他节点的信息,你直接粗暴地用Deployment部署多副本会出大问题,因为重建的Pod无法保留原来的集群身份,虽然后来K8s提供了StatefulSet来应对这类场景,但其配置和管理依然比无状态服务要复杂得多,对备份恢复的要求也更高。

第三,镜像仓库的安全和效率是生命线,但也容易成为瓶颈。 自己搭建私有镜像仓库(如Harbor)是必然选择,但这带来了运维负担,仓库的高可用怎么做?存储空间满了怎么办?镜像越来越多,如何做垃圾回收,安全地删除旧的、无用的镜像层而不影响正在使用的镜像?更大的挑战是安全扫描和权限控制,如何确保从基础镜像到业务镜像都没有已知的安全漏洞?这就需要集成镜像安全扫描工具,并设置流水线,阻止有高危漏洞的镜像被部署到生产环境,权限控制不当可能导致开发人员误操作覆盖了生产环境的镜像标签,或者未经授权就能拉取核心业务镜像,造成安全风险,这些琐碎但关键的工作,如果没有好的平台工具支持,会占用运维团队大量精力。

第四,日志和监控体系需要推倒重来。 在传统虚拟机时代,日志通常直接写在虚拟机的磁盘上,用传统的ELK(Elasticsearch, Logstash, Kibana)套件去收集,但在容器世界,容器的生命周期是短暂的,它挂了或者被调度走了,日志也就没了,所以必须采用“边车模式”或者DaemonSet方式,将每个容器的标准输出和文件日志实时收集到中心化的日志平台,这要求对应用的日志输出方式有新的规范(比如鼓励输出到stdout),并对日志采集agent的资源占用有精细的控制,否则可能反过来影响业务容器的性能,监控也是如此,传统的监控对象是物理机或虚拟机,现在监控的基本单元变成了Pod、Service、Node,需要一套新的监控指标体系(如cAdvisor、kube-state-metrics提供的指标)和告警规则,如何准确监控一个服务的真实可用性,而不仅仅是Pod是否在运行,是一个挑战。

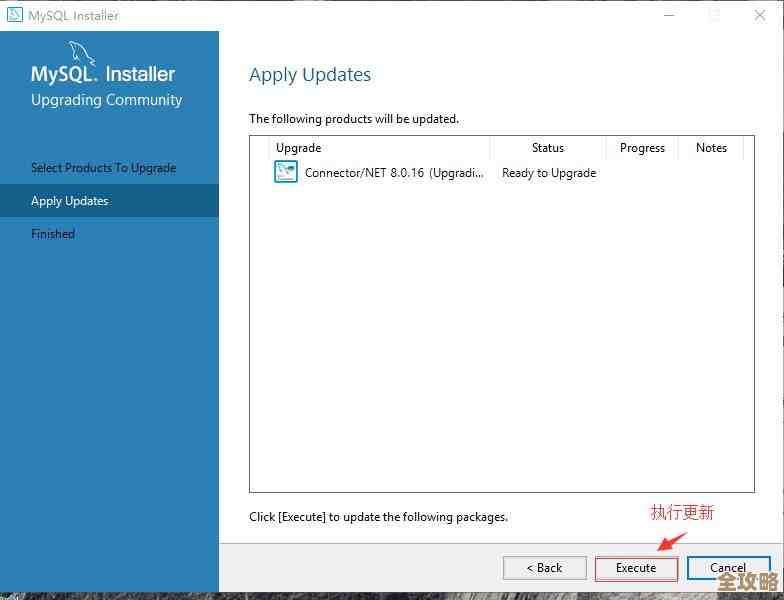

第五,配置管理的混乱让人措手不及。 应用配置(如数据库连接串、第三方API密钥)不能硬编码在镜像里,K8s提供了ConfigMap和Secret来管理,但当应用数量庞大、环境(开发、测试、生产)繁多时,如何优雅地管理这些配置对象就成了问题,是每个环境一套独立的ConfigMap/Secret?还是通过Helm Chart之类的工具用变量来差异化?如何确保敏感信息(Secret)的安全,即使加密存储在etcd中,其访问权限也需要严格控制,配置的变更如何安全地滚动更新到相关的Pod,而不引起服务中断?这些细节如果前期没规划好,后期就会导致配置散落各处,管理极其混乱。

第六,资源限制和调度优化是性能与成本的平衡木。 不给容器设置资源请求和限制,就等于在集群里埋下了“不定时炸弹”,一个“流氓”应用可能耗尽整个节点的内存或CPU,导致节点上的其他所有应用被“饿死”或驱逐,但设置资源限制本身也是个技术活:设得太宽松,会造成资源浪费,集群利用率低;设得太紧,又会导致应用频繁因为OOMKilled(内存不足被杀)或CPU节流而运行不稳定,K8s的调度器虽然智能,但默认策略可能不满足所有业务场景,如何将某些Pod强制打散到不同故障域(如不同机架)?如何让某些需要高性能通信的Pod尽可能调度到同一台机器?这就需要深入理解节点亲和性、Pod亲和性/反亲和性等调度策略,配置不当反而会引发调度失败或“拥挤”问题。

第七,最根本的难点可能在于人和文化。 技术上的坑总能有办法填平,但让开发团队改变原有的思维习惯却非常困难,从传统的“宠物”式运维(服务器需要精心呵护)转向“牲口”式运维(容器坏了就重启或重建),需要开发人员理解和接受故障是常态,并将应用设计成可恢复的,将CI/CD流水线与容器镜像构建、K8s部署无缝集成,也需要开发和运维团队的紧密协作,甚至需要组建专门的平台团队来维护这套复杂的基础设施,如果团队协作不畅,容器云平台很可能沦为另一个“运维黑盒子”,无法真正发挥其敏捷、弹性的价值。

搭建容器云平台远不是学会docker run和kubectl create几个命令那么简单,它涉及网络、存储、安全、可观测性、配置管理、资源调度等一系列复杂子系统的深度融合,以及对团队开发和运维文化的革新,每一个环节的疏忽,都可能在未来某个深夜变成一个个令人头疼的报警。

本文由凤伟才于2026-01-19发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://waw.haoid.cn/wenda/83914.html