Redis连接慢别急,这些方法帮你快起来,用户体验也跟着爽了

- 问答

- 2026-01-18 20:48:59

- 2

“Redis连接慢别急,这些方法帮你快起来,用户体验也跟着爽了”

你有没有遇到过这种情况?网站或App用着用着就卡住了,转圈圈转得人心烦,一查日志,发现是Redis连接出了问题,要么是连不上,要么是响应慢得像蜗牛,这可不是小事,用户可没那么多耐心,几秒钟的延迟就可能让他们关掉页面走人,别担心,Redis连接慢这个问题很常见,解决起来也有一系列“组合拳”,今天我们就来聊聊怎么把它搞定,让你的应用重新飞起来。

咱们得像个侦探一样,找出变慢的根本原因,盲目动手可能白费力气,根据一些常见的运维经验和网络文章分享(例如部分CSDN博客和技术社区讨论),问题通常出在以下几个地方:

网络问题:这是头号嫌疑犯。 Redis服务器和应用服务器是不是离得太远了?就像两个人隔着一个操场喊话,肯定没有面对面说话快,如果它们不在同一个机房,甚至不在同一个地区,网络延迟自然会高,你可以用简单的ping命令或者traceroute(在Linux/Mac上)或tracert(在Windows上)命令,看看从应用服务器到Redis服务器的网络延迟高不高,有没有丢包,云服务商的内部网络也可能出现波动。

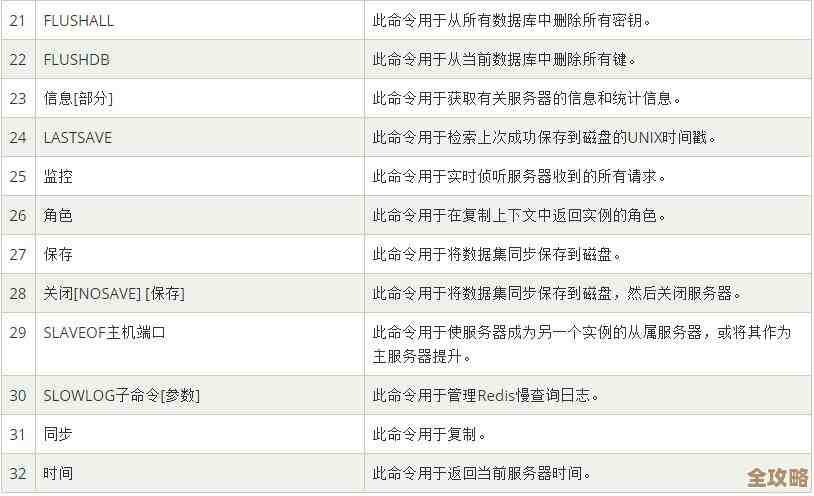

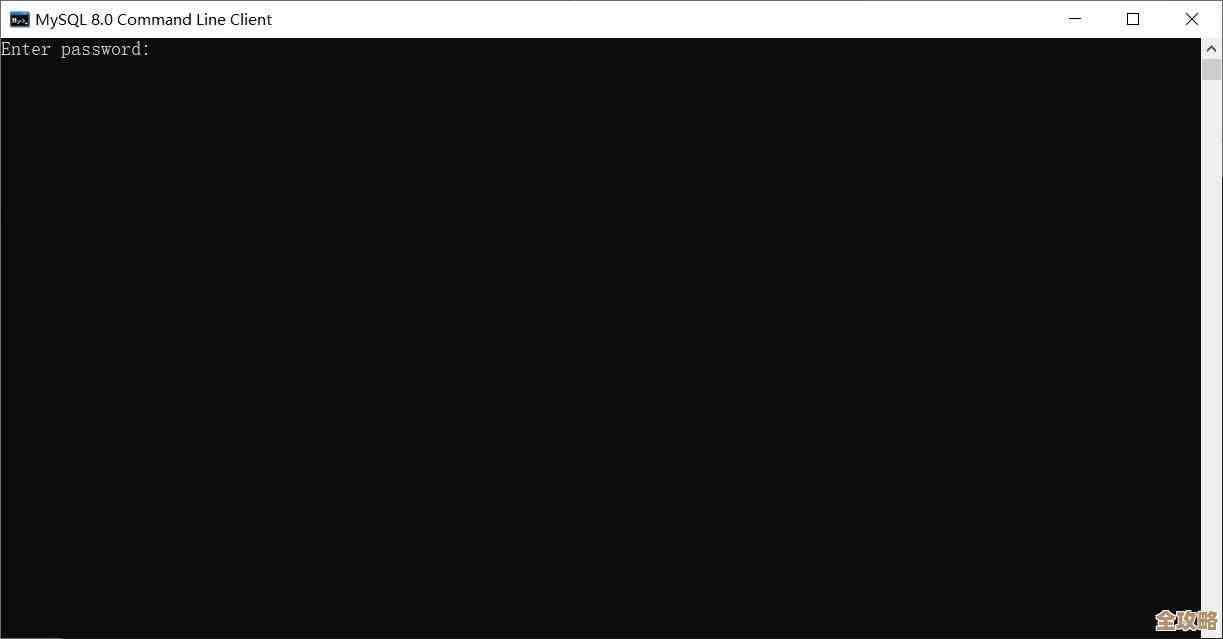

Redis服务器自身压力大: Redis是个单线程的家伙,虽然很快,但如果你的操作太频繁,或者有特别耗时的命令(比如一次性获取一个包含几万条数据的key),它就会忙不过来,后面的请求就得排队等着,这时候,你需要检查一下Redis的监控指标,比如CPU使用率、内存使用情况,以及是否有慢查询,Redis自带的SLOWLOG命令可以帮你找出那些执行时间太长的命令。

连接池配置不当: 大部分情况下,应用都不会每次操作都新建一个Redis连接,而是用一个叫“连接池”的技术来复用连接,如果连接池设置得不好,也会出问题。

- 最大连接数设得太小: 当很多用户同时访问时,连接池里的连接很快被借光了,新的请求只能等着有连接被还回来,这就造成了等待延迟。

- 最大空闲连接数设得太小: 连接用完被还回池子里后,如果空闲连接太多,可能会被销毁以节省资源,但如果设得太小,流量突然来时,又得频繁创建新连接,而创建连接本身也是需要时间的(涉及到网络握手和认证)。

客户端问题: 有时候问题不出在Redis服务器,而出在调用Redis的应用程序本身,应用程序的代码逻辑有问题,在循环里频繁地创建和关闭连接,或者有性能瓶颈导致处理Redis响应的速度变慢。

原因找到了,接下来就是对症下药:

针对网络问题: 最理想的是让应用和Redis在同一个机房、同一个内网里,这样网络延迟最低,如果用的是云服务,确保它们在同一区域(Region)和可用区(Availability Zone),如果是跨地域访问,那延迟是物理限制,可能要考虑在每个地域部署Redis实例,做数据同步。

减轻Redis服务器压力:

- 优化慢查询: 仔细分析

SLOWLOG的输出,避免使用KEYS *这种危险命令,对于大集合的操作可以考虑用SCAN命令分批进行,检查是否有些数据可以设置过期时间,让其自动清理。 - 考虑升级配置: 如果确实是数据量和并发量太大,升级Redis服务器的CPU和内存可能立竿见影。

- 使用集群模式: 当单个Redis实例不堪重负时,可以使用Redis集群(Cluster)或者哨兵(Sentinel)模式,把数据和压力分散到多个节点上。

优化连接池配置(这是成本最低、见效最快的方法之一): 根据你的实际业务流量,调整连接池的参数,比如适当调大最大连接数和最大空闲连接数,但也不是越大越好,连接数太多也会消耗服务器资源,你需要找到一个平衡点,可以参考你所用Redis客户端(如Jedis、Lettuce等)的文档进行设置。

客户端优化:

- 使用管道(Pipeline)或批量操作: 如果有很多个命令要执行,可以把它们打包成一个管道一次发送,减少网络往返次数,能极大提升效率。

- 确保代码正确使用连接池: 检查代码,确保每次操作后都正确地将连接归还给池子,避免资源泄漏。

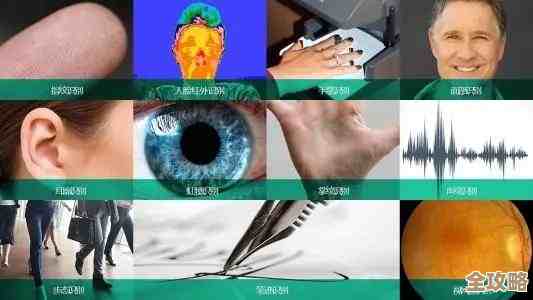

别忘了监控和告警: 解决问题后,要建立持续的监控,监控Redis的关键指标(连接数、内存、CPU、慢查询等),并设置告警,这样一旦有变慢的苗头,你就能第一时间知道,而不是等用户来投诉。

解决Redis连接慢的问题,就是一个“排查-优化-监控”的循环过程,从最简单的网络和连接池配置入手,往往能解决大部分问题,当你的Redis响应迅速,应用的性能瓶颈被打破,页面加载飞快,操作流畅顺滑,用户体验自然就“爽”起来了,速度是用户体验的基石,在这一点上多下功夫,绝对物超所值。

本文由太叔访天于2026-01-18发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://waw.haoid.cn/wenda/83252.html