调整云资源大小别踩这些坑,避免浪费和性能掉链子

- 问答

- 2026-01-17 22:13:08

- 4

调整云资源大小,听起来就是个动动鼠标、改改数字的简单事儿,但里面藏着不少容易让人栽跟头的地方,很多团队为了省钱或者提升性能去操作,结果反而造成了更大的浪费,或者让应用性能变得更不稳定,咱们今天就聊聊这些常见的坑,怎么避开它们。

第一个大坑:只看高峰,不看平时,钱都白花了。

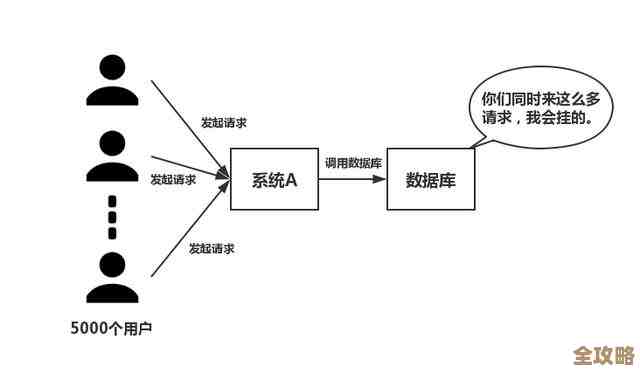

这是最典型的问题,比如你的网站或应用,可能只有在每周五晚上或者做促销活动时,访问量才会暴增,平时大部分时间都很清闲,如果你按照最高峰的流量去配置一台超级大的云服务器,那就好比为了偶尔来一趟的客人,常年租着一个几百平米的大别墅,绝大部分时间房间都是空着的,但房租可是一分不能少(来源:基于云服务按量计费的基本原则),很多云服务商提供的监控图表都能清晰地展示出这种“心电图”式的流量波动。

怎么避开? 要学会利用云的弹性,别把所有希望都寄托在一台固定大小的服务器上,现在主流的做法是使用“自动伸缩”功能,你可以设定一些规则,比如当CPU使用率连续5分钟超过70%了,就自动增加一两台服务器来分担压力;当流量降下来,CPU使用率低于30%了,再自动关掉多余的服务器,这样,你只需要为真正使用的计算时间付费,完美解决“别墅养蚊子”的问题(来源:AWS、阿里云等厂商的自动伸缩组最佳实践文档)。

第二个坑:只关心CPU和内存,忘了其他“器官”也会卡脖子。

很多人调整资源,眼睛就盯着服务器的CPU核数和内存大小,这没错,但系统性能是个木桶,最短的那块板决定了能装多少水,你给CPU升级到16核,内存加到32G,看起来猛得不行,但万一你的磁盘速度跟不上呢?如果用的还是老式的机械硬盘,或者普通云硬盘,当应用需要频繁读写数据时,磁盘就会成为瓶颈,CPU再快也得干等着,性能照样上不去(来源:系统性能优化的普遍性原则),同样,网络的带宽和延迟也很关键,特别是对于那些需要和数据库或其他服务频繁通信的应用。

怎么避开? 在决定升级之前,一定要先做全面的“体检”,利用云监控工具,不仅看CPU和内存,更要重点观察磁盘的读写速度(IOPS)、网络流量和延迟,找到真正的性能瓶颈所在,再对症下药,如果是磁盘慢,就考虑升级到更快的SSD云盘;如果是网络问题,可能就需要调整架构或者升级带宽。

第三个坑:调整完就以为万事大吉,不去验证效果。

这是非常危险的一步,你以为从2核4G升级到4核8G,性能就应该翻倍,但实际情况可能很复杂,你的应用程序本身可能存在性能问题,比如代码效率低、数据库查询语句没优化,这时候你加再多的硬件资源,效果也微乎其微,钱等于打了水漂,更糟糕的情况是,调整资源配置后,可能会引发意想不到的兼容性问题,导致应用不稳定甚至直接宕机。

怎么避开? 任何一次资源调整,都必须伴随着严格的测试,在调整之后,要立即对应用进行压力测试和全面的功能回归测试,确保性能确实得到了预期的提升,并且所有功能都正常,最好能有一个“回滚”计划,万一新配置有问题,能快速切换回之前的稳定状态,调整不是目的,保证应用稳定高效才是。

第四个坑:只缩不放,或者只放不缩,缺乏持续优化。

云资源管理不是一锤子买卖,而是一个持续的过程,业务在发展,流量模式在变化,可能半年前你设置好的自动伸缩规则,现在已经不适应新的业务场景了,你的用户量慢慢增长了,但伸缩规则还是老样子,可能导致在平时流量下资源就不够用,反应变慢,反之,如果某个功能下线了,流量减少了,但你忘了及时调低资源配置的底线,也会造成浪费。

怎么避开? 养成定期审查云资源使用情况的习惯,可以每个月或每个季度回顾一下各项服务的利用率报告,看看是否有资源长期处于低利用率状态(比如CPU常年低于10%),那就可以考虑给它“降级”了,根据业务规划,比如即将到来的大促活动,提前规划和调整伸缩策略,把成本优化当成一个持续的、日常的工作。

第五个坑:忽略了人的因素和流程。

在稍微大一点的公司里,开发团队、运维团队、财务团队可能是分开的,开发人员只管申请资源让应用能跑起来,不太关心花了多少钱;财务部门只看到月底账单吓人,又不清楚具体是哪个业务导致的,这种脱节会导致资源浪费没人管,优化没人做。

怎么避开? 建立“责任共担”的文化和机制,给每个项目或部门分配一个清晰的云成本预算,并且让他们能方便地看到自己名下资源的使用情况和费用(这叫做“分账”),让技术和业务人员都建立起成本意识,鼓励他们主动去寻找优化点,甚至可以设立一些奖励机制,对提出有效省钱方案的同学给予表扬或奖励。

调整云资源大小是个技术活,更需要细致的规划和持续的关注,核心思想就是:依据真实数据做决策,充分利用云的弹性,并且把优化当成一个习惯,这样才能真正把钱花在刀刃上,既保证体验,又控制成本。

本文由邝冷亦于2026-01-17发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://waw.haoid.cn/wenda/82663.html