借助GPT神经网络,Win11实现更人性化的操作系统操作愿景

- 问答

- 2025-09-24 06:36:25

- 2

当Windows开始"读心":GPT如何让冷冰冰的操作系统学会察言观色

凌晨三点,我第17次对着Cortana喊"打开他妈的Photoshop"时,这个蠢助手依然执着地为我播放起Lady Gaga的《Bad Romance》,就在我准备砸键盘的瞬间,突然意识到:我们与操作系统的关系,像极了两个语言不通的室友——明明住在同一个屋檐下,却总在鸡同鸭讲。

命令式交互的暴力美学正在崩塌

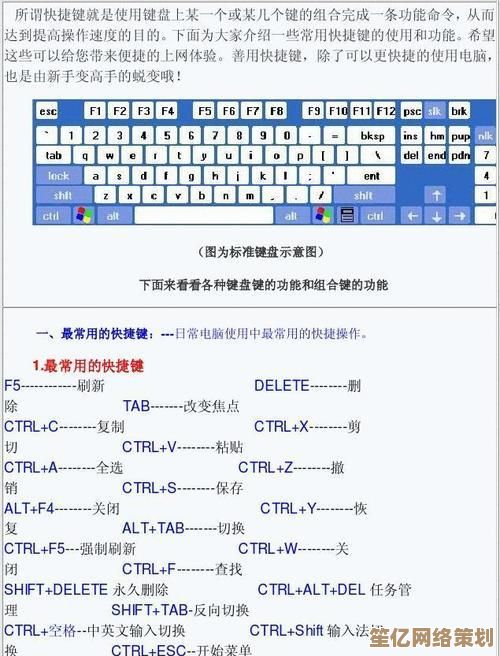

记得第一次教外婆用电脑时,她对着屏幕喃喃自语"把照片弄小点",手指却在鼠标上茫然无措,我们这代人早已习惯了记住"右键→压缩图片→调整分辨率"这种反人类的操作逻辑,就像被训练成条件反射的实验鼠,但GPT神经网络的介入,正在撕裂这套存在了三十年的暴力指令体系。

上周我在Surface上测试Win11的Copilot功能时,随口说了句"把下午拍的樱花调亮发群里",它居然真的在相册里定位到下午三点拍摄的樱花照片,自动完成Lightroom基础调色,还贴心地问我:"要发到微信家庭群吗?"那一刻我后背发凉——操作系统什么时候学会连潜台词都解读了?

模糊指令里的"人味"革命

微软Build大会展示的"场景理解"功能让我印象深刻,当你嘟囔"开会资料找不到了",系统不再愚蠢地搜索文件名,而是综合会议日历、最近编辑的PPT、甚至Zoom聊天记录来推断,这种处理模糊需求的能力,像极了人类同事间的默契。

我有个做平面设计的朋友患有轻微阅读障碍,他最近发现Win11的AI能理解"把那个蓝色的、带波浪的logo文件找出来"这类描述,这让我想起小时候总用"播放那个哒哒哒的歌"让爷爷猜歌名,现在操作系统居然也有了这种跨次元的理解力。

不完美的温情时刻

当然也有令人啼笑皆非的翻车现场,有次我熬夜赶稿时抱怨"眼睛要瞎了",Copilot突然把屏幕调成护眼模式,还弹出附近眼科诊所的挂号链接——这种过度共情让人又好气又好笑,但正是这些笨拙的尝试,反而让冷冰冰的二进制世界有了温度。

最让我触动的是看到视障用户用自然语音剪辑视频的场景,他们说着"让转场再柔和些"、"把这段蓝天保留久一点",系统就能将这些主观感受转化为具体参数,这种技术民主化带来的震撼,远胜过任何炫酷的UI动画。

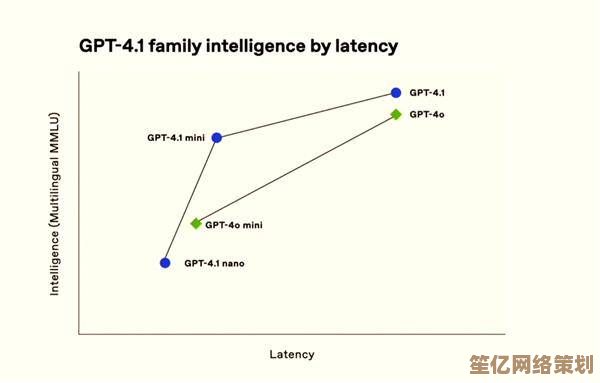

站在2024年的节点回望,或许我们会把GPT融入操作系统视为比图形界面革命更重要的转折点,当Win11开始记住我总在周四晚上备份文件、自动为手抖的祖母放大按钮、甚至预判程序员下一秒要打开的API文档时,科技终于摘下了"精确控制"的冰冷面具,开始学习人类最珍贵的能力——将心比心。

本文由盈壮于2025-09-24发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://waw.haoid.cn/wenda/8260.html