网页数据提取其实没那么难,教你快速搞定数据库信息抓取技巧

- 问答

- 2026-01-16 19:13:34

- 3

开始)

很多人一听到“网页数据提取”或者“网络爬虫”,脑子里可能立刻浮现出程序员对着黑色屏幕敲打复杂代码的场景,觉得这是非常高深的技术活,但实际上,随着工具的发展,现在很多数据抓取任务并没有想象中那么困难,即使你完全不懂编程,也能通过一些巧妙的方法和现成的工具,快速搞定你需要的信息,今天要聊的就是一些实用的、非技术化的技巧,帮你把网页上有价值的数据“搬”到自己的电脑里,比如Excel表格中。

最基础也最容易被忽略的方法:手动复制粘贴。 听起来很原始对吧?但对于数据量很小(比如只有几页、几十条记录)、结构又很简单的表格型数据,直接选中、复制、然后粘贴到Excel里,往往是最快、最直接的方式,很多政府公开数据网站、产品列表页的第一页,都适合用这种方法,这个方法最大的问题就是效率低,而且如果网页有反复制限制,可能会有点麻烦。

当手动复制太累时,浏览器自带的“开发者工具”可以帮上大忙。 这不是让你去写代码,而是利用它来观察网页的结构,以常用的Chrome浏览器为例,在网页上右键点击,选择“检查”或者“审查元素”,会打开一个侧边栏,在这个侧边栏里,你可以看到网页的HTML代码,这时候,你再把鼠标移动到网页上你想要的数据(比如一个产品价格),对应的代码就会高亮显示,通过观察,你可能会发现所有产品的价格都使用了一个相同的“标签”或者“类名”,这个发现非常关键,因为它意味着数据是以一种有规律的方式排列的,虽然你自己不写代码,但明白了这个规律,就能更好地使用下一步要说的自动化工具,这个技巧是很多网络数据抓取教程(例如一些技术博客和在线课程中)都会强调的基础步骤。

对于结构化数据的抓取,浏览器的扩展插件是真正的“神器”。 市面上有很多免费的浏览器插件,Web Scraper”或者“Instant Data Scraper”,它们的作用就是把上面提到的“发现数据规律”这个过程自动化,你只需要打开插件,在网页上用鼠标点选你需要抓取的数据项(比如点一下商品标题,再点一下价格,再点一下链接),插件会自动识别规律,然后你告诉它要翻多少页,它就能自动翻页并把所有页面的数据都抓取下来,最后导出成CSV或Excel格式,这种方法非常适合抓取电商网站的商品列表、新闻网站的标题列表、招聘网站的职位信息等页面结构整齐划一的数据,根据一些软件评测网站的介绍,这类工具极大地降低了非技术人员进行数据采集的门槛。

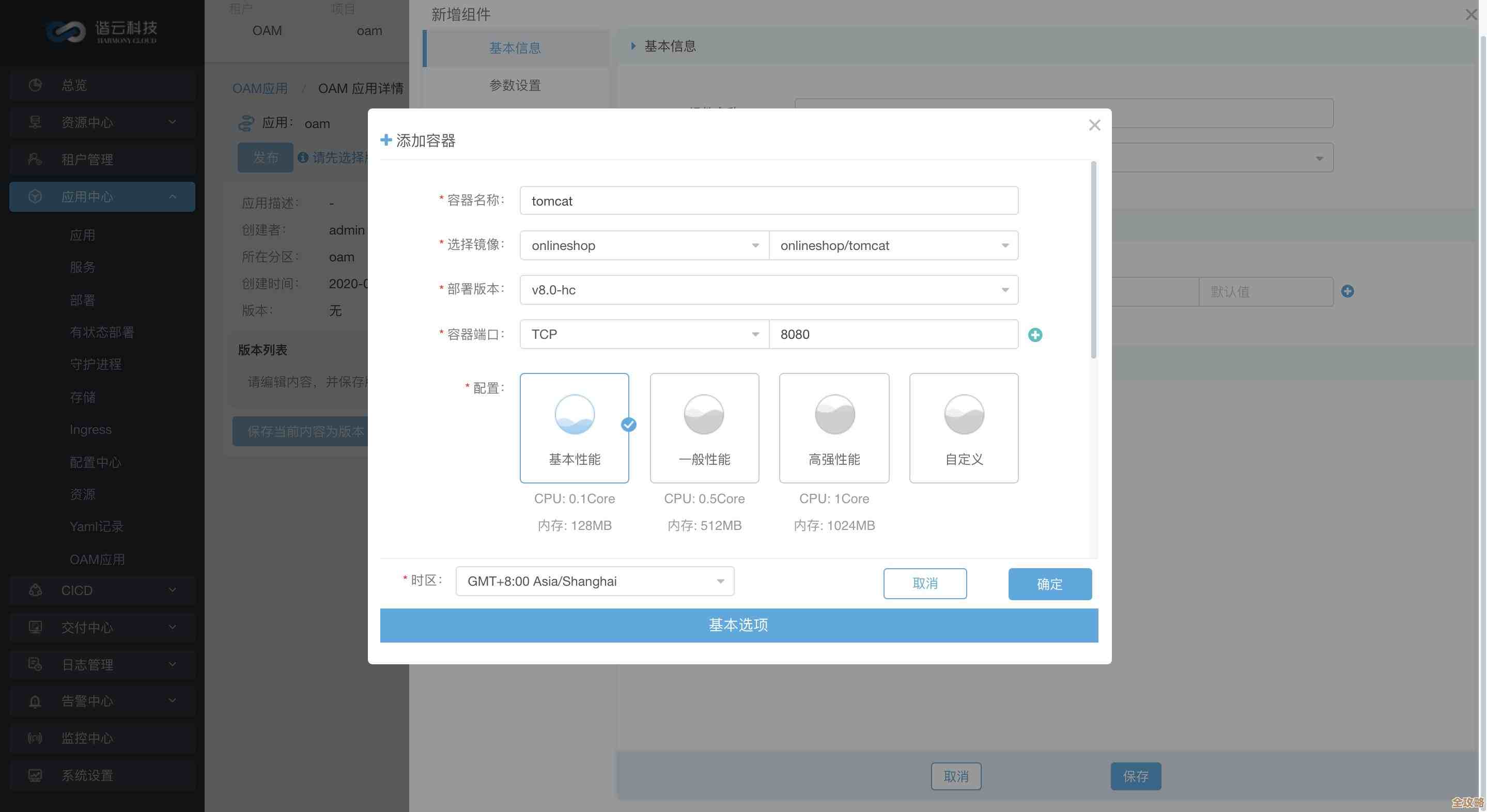

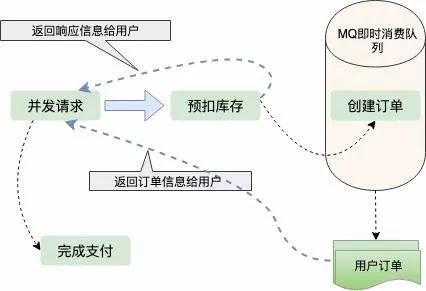

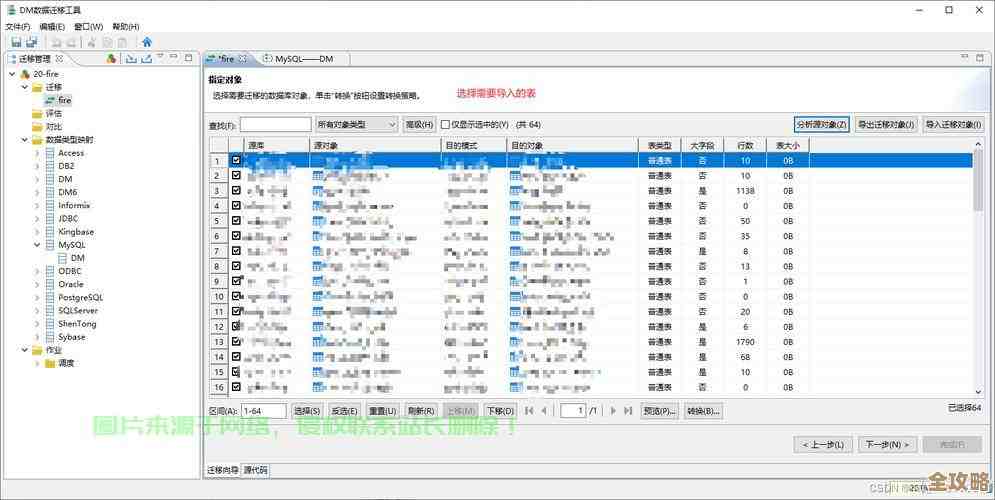

当面对更复杂的网站,或者需要定期抓取时,就需要用到一些可视化的爬虫软件了。 这类软件比浏览器插件功能更强大,可以处理需要登录的网站、点击加载更多的页面(瀑布流)、甚至是下拉菜单选择等交互操作,它们通常提供图形化界面,你通过拖拽和点击来设置抓取流程,先输入关键词”、“再点击搜索按钮”、“然后循环提取每一行数据”,这类软件(如八爪鱼采集器、后羿采集器等在其官方教程中展示的功能)本质上是在帮你生成爬虫脚本,但你不需要看到代码,只需要理解网页的逻辑流程即可,这对于需要批量获取竞争对手价格、监控舆情信息、整合多个来源数据的市场人员或研究者来说,是非常实用的工具。

必须要提一下数据抓取的“交通规则”:Robots协议和法律法规。 这不是技术问题,但比技术更重要,几乎每个网站都有一个叫做robots.txt的文件(通常在网站根目录下,比如www.example.com/robots.txt),这个文件告诉了爬虫哪些页面可以抓取,哪些不可以,在抓取任何网站的数据之前,都应该先查看这个文件,表示对网站规则的尊重,更重要的是,抓取的数据只能用于个人学习或公益研究,绝不能用于商业牟利或侵犯他人权益,大量、高频的访问可能会对网站服务器造成压力,甚至被视为攻击行为,一些公开数据API接口(如果网站提供的话)是更友好、更安全的数据获取方式。

网页数据提取并不神秘,从最笨的手工复制,到利用开发者工具观察,再到使用浏览器插件和可视化软件,有一条清晰的技术路径,你可以根据自己任务的复杂程度和频率,选择最适合的工具,关键是迈出第一步,亲手尝试一下,你会发现,把散落在网络世界的信息,有条理地收集起来,是一件非常有成就感的事情。 结束)

本文由邝冷亦于2026-01-16发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://waw.haoid.cn/wenda/81963.html