Redis里那些重复Key到底咋整,处理方法和注意点聊聊

- 问答

- 2026-01-15 15:19:19

- 2

说到Redis里出现重复Key,这事儿其实挺让人头疼的,你想着往一个叫 user:100:profile 的Key里存用户信息,结果不知道哪个环节出了岔子,可能是程序BUG,也可能是人工误操作,另一个不同的值也被写入了同一个Key,这下好了,老数据被新数据悄无声息地覆盖了,可能会导致业务逻辑出错,比如用户登录后发现信息不对,或者更糟,引发数据不一致的严重问题。

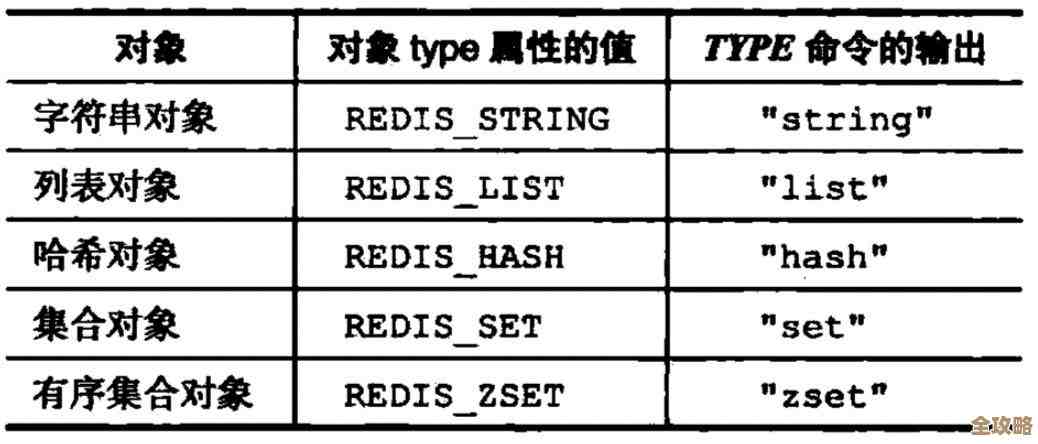

(根据Redis设计与实现的核心原理) Redis本身是个单线程的、键值对结构的数据库,它默认的行为就是“覆盖写”,也就是说,对于一个已经存在的Key,当你再次使用 SET 命令时,它不会给你任何友好的提示说“嘿,这个Key已经存在了,你确定要覆盖吗?”,而是直接、干脆地用新值替换掉旧值,这种设计是为了极致的性能,但同时也把“避免Key重复”的责任完全交给了使用它的人。

怎么来整这些重复Key呢?咱们分情况聊聊处理方法和需要注意的地方。

预防是关键:把问题扼杀在摇篮里

最好的处理就是不让它发生,这比事后补救要省心得多。

-

使用

SETNX命令(SET if Not eXists):这是最直接的防重复武器,这个命令的意思是“如果这个Key不存在,我才设置它”,如果Key已经存在,命令会返回0表示设置失败,你的程序就能立刻知道有问题,从而采取下一步动作,比如记录日志或者抛出异常,但要注意,它通常用于设置那些一旦写入就不太改变的值,比如锁或者初始化配置。 -

规范Key的命名:这是最根本的方法,制定一个清晰、不易冲突的Key命名规范,并且让所有开发人员都遵守。

- 用冒号分隔:像

业务:表名:ID,order:1001,user:email:alice@example.com,这种层次结构很清晰。 - 包含唯一标识:确保Key的核心部分(比如ID、手机号、邮箱)是全局唯一的。

- 避免使用模糊的Key名:像

temp_data,cache_obj这种,很容易在不同业务场景下被误用。

- 用冒号分隔:像

-

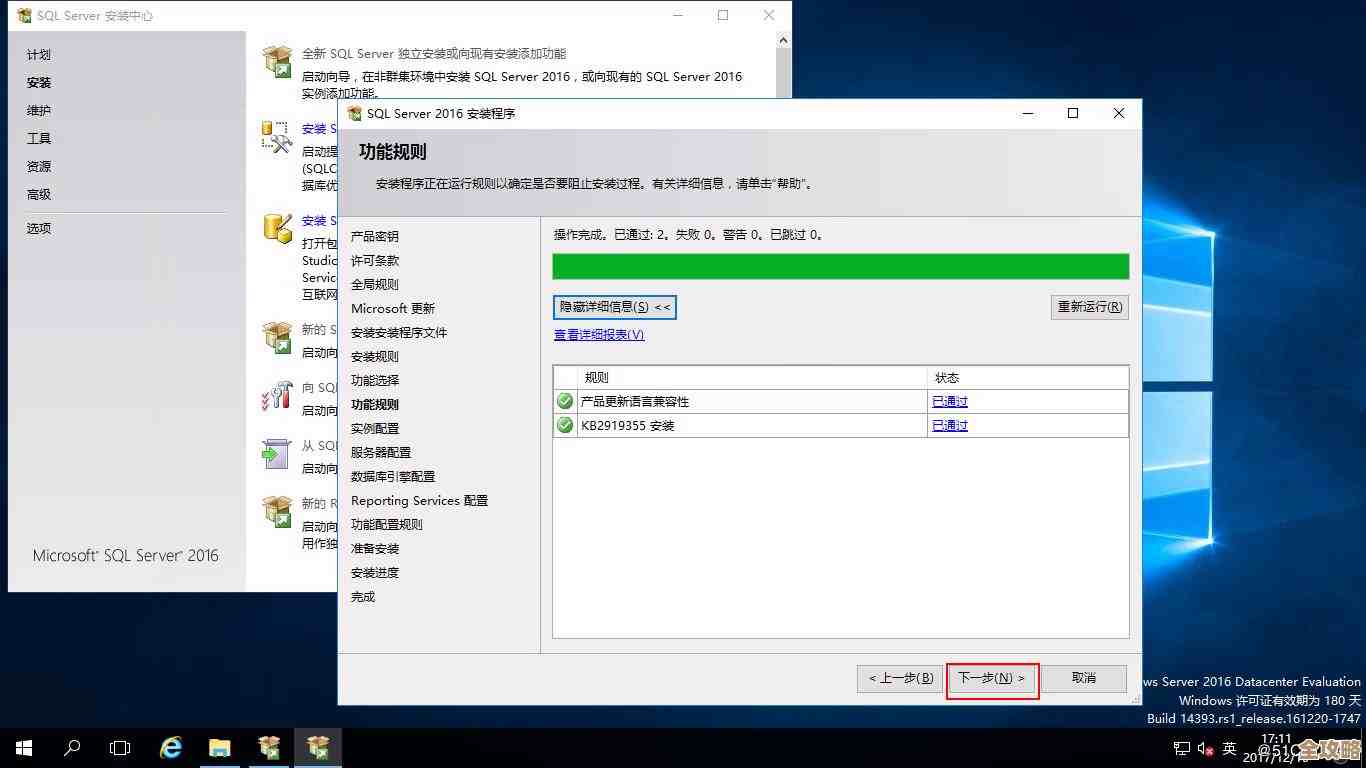

借助数据库的唯一约束:很多时候,Redis的数据是来自MySQL这类关系型数据库的,如果Redis的Key是依赖于数据库表的某个唯一字段(如主键ID),那么首先保证数据库层面这个字段是唯一的,就能从源头上减少Redis Key冲突的可能性。

发生了怎么办:事后检测与清理

如果怀疑或者已经确认环境中存在重复Key,就需要动手处理了。

-

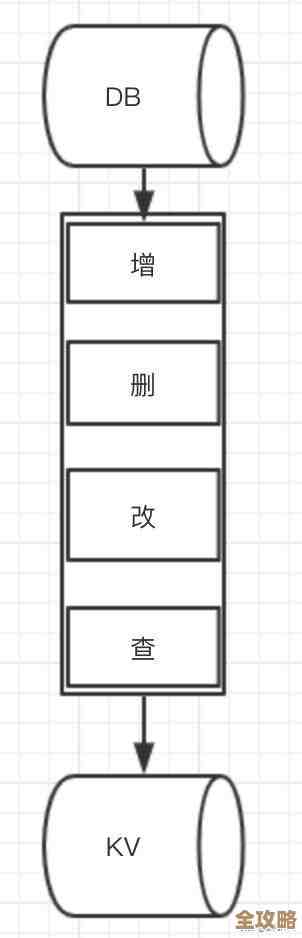

扫描和发现:Redis提供了

SCAN命令来渐进式地遍历所有Key,避免使用会阻塞服务的KEYS *命令,你可以写一个脚本,定期扫描Redis,检查是否有不符合命名规范的Key,或者通过检查Key的TTL(存活时间)等属性来发现异常。 -

版本化Key:这是一个很实用的设计技巧,在写入重要数据时,不直接覆盖老Key,而是创建一个带版本号的新Key,

user:100:profile:v2,用一个固定的、不带版本的Key(如user:100:profile:current)来指向最新的版本号,这样,即使新数据写错了,你还能快速回滚到老版本,这需要额外的逻辑来管理版本和清理旧数据。 -

谨慎处理现有数据:如果发现了一个重复Key,并且已经覆盖了数据,首先要做的是评估影响,不要急着去删除或修改,搞清楚是哪个操作、在什么时间点覆盖的,覆盖前后的值分别是什么,对业务造成了多大影响,如果可能,从数据库或备份中恢复正确的数据。

需要注意的几个点:

- 性能影响:像

SCAN这样的操作虽然非阻塞,但在海量数据下依然会消耗Redis服务器的CPU和网络带宽,最好在业务低峰期进行。 - 原子性:当你使用

SETNX然后再设置过期时间时,要注意这两个命令不是原子的,如果在这之间服务重启,可能会留下一个没有过期时间的Key,推荐使用Redis 2.6.12之后支持的SET key value NX EX seconds这种原子操作命令。 - 别依赖TTL做唯一性保证:有人认为给Key设置一个很短的TTL就能避免重复,这是不对的,如果两个请求在极短时间内先后SET同一个Key,即使TTL再短,后一个依然会覆盖前一个。

- 备份的重要性:在对生产环境的Redis进行任何大规模清理或修改操作前,务必进行备份,误操作可能导致数据丢失,有备份就等于有了后悔药。

处理Redis重复Key,思想上要“防大于治”,通过规范和技术手段尽量避免;一旦发生,要冷静评估、谨慎操作,它更像是一个管理和规范问题,而不仅仅是技术问题。

本文由畅苗于2026-01-15发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://waw.haoid.cn/wenda/81238.html