淘宝网数据库那些事儿,怎么一步步玩出行业新花样

- 问答

- 2026-01-13 20:20:16

- 7

(根据阿里巴巴官方技术博客、阿里云数据库负责人访谈、以及多位亲历早期淘宝技术发展的工程师口述整理)

说起淘宝网的数据库,那简直是一部从“小米加步枪”到“航母战斗群”的进化史,充满了各种被逼出来的智慧和新花样。

第一阶段:草创时期的“土法炼钢”

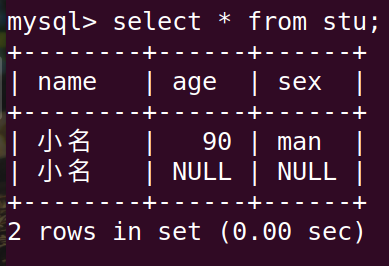

2003年淘宝刚成立的时候,哪有什么高大上的系统?整个网站就是一个简单的LAMP架构:Linux操作系统、Apache网页服务器、MySQL数据库和PHP语言,那时候的数据库,就是一台普通的服务器,上面跑着开源的MySQL,随着用户量慢慢增加,商品和用户数据越来越多,这台单薄的数据库服务器开始“喘不过气”了,读写速度变得巨慢,眼看就要撑不住了。

最早的“花样”其实是被逼出来的,工程师们想,既然一台数据库不够用,那就把它拆开!这就是最原始的“读写分离”,他们搞了一个主数据库(Master),专门负责处理写操作,比如用户下单、发布商品,然后弄好几个从数据库(Slave),这些从数据库从主库那里同步数据,专门负责读操作,比如用户浏览商品、搜索,这样一来,读写压力就被分摊了,网站暂时又能流畅运行了,这在当时,对于很多还在用单机数据库的国内网站来说,已经是很超前的玩法了。

第二阶段:业务爆炸下的“分家过日子”

好景不长,淘宝的发展速度太快了,用户量和交易量呈指数级增长,读写分离虽然缓解了压力,但所有数据还是放在一个数据库里,这个数据库变得无比庞大,就像一个越来越重的包袱,无论是备份还是扩展都极其困难。

淘宝的工程师们又玩出了新花样:“分库分表”,他们内部喜欢叫“分库分表,数据分片”,这个思路很简单,分家”,把用户数据库、商品数据库、交易数据库彻底分开,部署到不同的服务器集群上去,这就叫“垂直分库”,相当于让专业的人管专业的事。

但这还不够,就拿用户库来说,几亿用户放在一个库里还是受不了,怎么办?继续分!按照某种规则,比如用户ID的尾数,把一张巨大的用户表拆分成很多张小表(比如user_001, user_002……),然后把这些小表分散到不同的数据库服务器上,这就叫“水平分表”,这样一来,压力就被均匀地分摊到了一个庞大的数据库集群里,这个技术说起来简单,但做起来极其复杂,涉及到如何平滑迁移数据、应用程序如何路由到正确的数据库等一系列难题,淘宝在这方面踩了无数的坑,但也因此成为了全球范围内最早大规模应用并验证分库分表技术的公司之一。

第三阶段:自研之路与“去IOE”

在探索分库分表的过程中,淘宝严重依赖Oracle数据库和IBM的小型机、EMC的高端存储,这套组合就是著名的“IOE”,它性能稳定,但有个致命缺点:太贵了!而且像Oracle这种商业数据库,是封闭的“黑盒子”,扩展性差,无法满足淘宝海量数据和高并发的要求。

被“卡脖子”的淘宝,下定决心要走一条自己的路,这就是后来轰动业界的“去IOE”运动,他们用开源的MySQL替代Oracle,用普通的PC服务器替代昂贵的小型机和高端存储,但这需要解决一个核心问题:如何让MySQL能像Oracle一样稳定、高效地支撑核心业务?

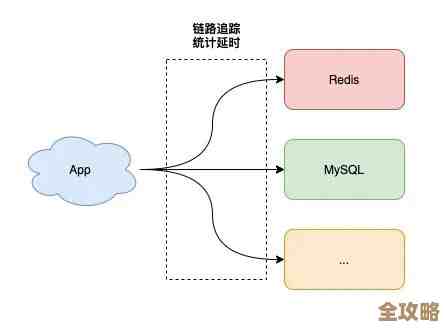

答案就是自研中间件和新的数据库系统,淘宝先后推出了TDDL(Taobao Distributed Data Layer)等中间件产品,这些中间件在应用程序和底层的MySQL数据库集群之间扮演了“智能调度官”的角色,自动处理复杂的数据分片和路由,让程序员像使用一个数据库一样方便,而背后其实是成百上千个数据库在协同工作。

第四阶段:云时代与“技术输出”

当淘宝自身的数据库技术已经非常成熟后,他们发现这套应对超大规模数据的技术,正是整个互联网行业未来都会遇到的痛点,他们把在淘宝内部经过千锤百炼的技术,比如分库分表的理念、中间件的设计思想,进行产品化封装,通过阿里云向全社会输出。

这就诞生了像 PolarDB 和 OceanBase 这样的明星产品,PolarDB是一种云原生数据库,它计算和存储分离的架构,使得扩展能力变得极其灵活,被誉为“下一代关系型数据库”,而OceanBase更是在技术上实现了巨大突破,它完全由阿里巴巴自主研发,解决了分布式数据库在保持强一致性下的高可用和高性能难题,甚至通过了国际公认的TPC-C基准测试并打破了世界纪录,证明了国产数据库也能达到世界顶尖水平。

总结一下,淘宝数据库的玩法,其实就是一部不断解决自身生存问题的创新史,从最初的读写分离,到大规模分库分表,再到壮士断腕般的“去IOE”和自研核心系统,最后到将技术红利反哺行业,每一步新花样,都不是凭空想出来的,都是被巨大的业务需求“逼”出来的实战经验,而这些经验最终改变了中国乃至世界数据库技术的格局。

本文由歧云亭于2026-01-13发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://waw.haoid.cn/wenda/80129.html