分布式环境下MemCache那些事儿,细节和原理慢慢聊给你听

- 问答

- 2026-01-13 11:00:43

- 7

MemCache是啥?为啥要用它?

想象一下,你的网站或者应用就像一个繁忙的餐厅,数据库(比如MySQL)就是后厨,每次客人(用户)点菜(请求数据),服务员(你的应用服务器)都得跑去后厨一趟,让厨师现做(执行SQL查询),客人少的时候没问题,但人一多,后厨就忙不过来了,上菜速度变慢,客人等得不耐烦。

MemCache呢,就像是餐厅门口摆的一个超级快的保温餐台,那些最受欢迎、点击率最高的菜(热点数据),比如宫保鸡丁,厨师会提前做好一大份放在这个保温餐台里,下次有客人点宫保鸡丁,服务员不用再去后厨,直接从餐台打一份送上,速度飞快!这个“保温餐台”就是MemCache,它本质上是一个分布式的内存键值缓存系统,它的主要作用就是给数据库“减负”,通过把数据临时存放在读写速度极快的内存里,来提升整个系统的响应速度。

分布式是咋回事?数据怎么放?

单个MemCache服务器的内存是有限的,存不下所有数据,就像一家餐厅一个保温餐台不够用,我们就在旁边多摆几个餐台,这就是“分布式”MemCache集群。

现在问题来了:客人点了宫保鸡丁,服务员怎么知道该去一号餐台还是二号餐台拿呢?万一跑错了,不就白费功夫了吗?这就引出了MemCache分布式环境下的核心问题:数据该存在哪个节点上?

MemCache客户端(就是你程序里用到的MemCache库)用一种非常巧妙的算法来解决这个问题,叫做一致性哈希。

传统的办法是“哈希取模”:比如我们对数据键名“宫保鸡丁”计算一个哈希值,然后除以服务器总数取余数,余数是几就存到第几台服务器,但这个方法有个大问题:万一有一台服务器宕机了,服务器总数变了,那么几乎所有的数据根据新的总数重新计算后,存放的位置都会变!这就好比一个餐台坏了,原来放在所有餐台里的菜都得重新摆放一遍,缓存会大面积失效,数据库瞬间压力山大,这叫“缓存雪崩”。

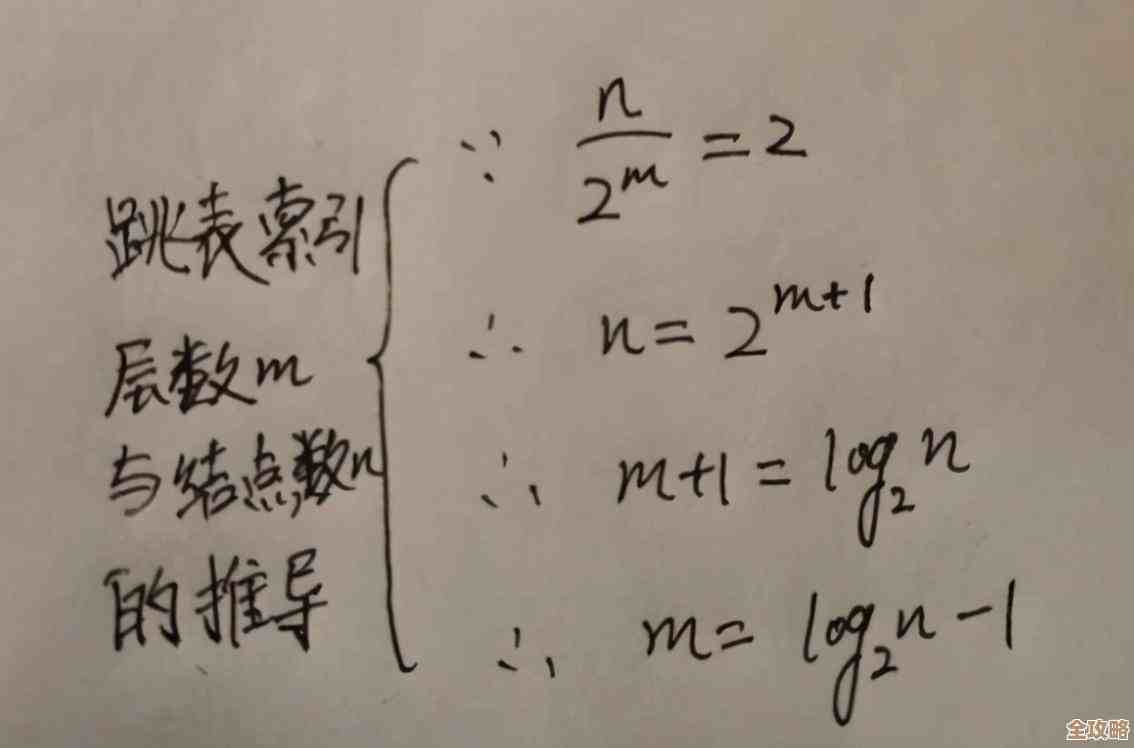

一致性哈希就聪明多了,它不再是把服务器放在一个从0到N的直线上,而是想象一个非常大的圆环(哈希环),它对每一台MemCache服务器(通过IP或端口)计算一个哈希值,把这个值映射到环上的某个点,对要存储的数据的键名也计算一个哈希值,映射到环上,从这个数据点出发,沿着环顺时针寻找,碰到的第一个服务器节点,就是这台数据该存放的地方。

这样做的好处是,当增加或减少一台服务器时,受影响的只是环上这台服务器相邻小部分区域的数据,大部分数据的位置都不会改变,从而避免了缓存大规模失效,这就好比环上新增一个餐台,只需要把逆时针方向相邻餐台的一部分菜挪过来就行了,其他餐台的菜都不用动。

集群怎么知道彼此的存在?

这里有个关键点:MemCache服务器本身是不知道集群里有其他兄弟节点的,它就是个“傻白甜”,只负责守着自己那一亩三分地内存,执行简单的“读、写、删”命令。

那谁知道整个集群的布局呢?是客户端!客户端在启动时,就需要配置好所有MemCache服务器的地址列表,客户端内部会根据这个列表,使用上面说的一致性哈希算法,构建出一个“路由表”,每次你的程序要读写缓存时,客户端会先根据键名计算出该去哪台服务器,然后直接和那台服务器通信。

这种设计的优点是服务器端非常简单、稳定,扩容缩容的逻辑由更灵活的客户端来承担,缺点是,如果集群节点有变化,你需要更新所有客户端应用的配置。

缓存失效和淘汰

内存是宝贵的,不能无限存放数据,MemCache主要用两种方式清理旧数据:

- 过期时间:你往MemCache存数据的时候,可以设置一个存活时间,比如5分钟,5分钟后,这条数据会自动被删除,这适合那些一段时间内有效的数据。

- LRU淘汰机制:当内存快满的时候,MemCache会启动清理,它默认使用LRU算法,也就是“最近最少使用”,它会优先把那些最长时间没被访问过的数据踢出去,给新数据腾地方,这就像保温餐台空间有限,如果一道菜很久没人点了,就可能被撤下来,换上新的热门菜。

分布式下的挑战

即使有了一致性哈希,分布式缓存也不是完美的,比如前面提到的,缓存雪崩:如果大量缓存同时失效(比如设置了相同的过期时间),所有请求会瞬间砸向数据库,解决办法通常是给缓存过期时间加一个随机值,让它们分散开失效。

还有缓存穿透:有人恶意请求一个根本不存在的数据,红烧外星人”,这个键在缓存里肯定没有,每次请求都会落到数据库上,解决办法可以是缓存这个“空结果”(设置一个很短的过期时间),或者使用布隆过滤器提前判断数据是否存在。

缓存击穿:某个热点key在失效的瞬间,大量请求同时过来,击穿缓存,直接访问数据库,解决办法可以用互斥锁,只让一个请求去数据库加载数据,其他请求等待。

总结一下

MemCache在分布式环境下的核心思想就是“分而治之”和“空间换时间”,通过一致性哈希把数据分散到多台机器的内存中,客户端负责智能路由,它的目标是尽可能快地从内存中返回数据,保护后方脆弱的数据源,虽然它本身功能简单,但结合良好的设计和应对策略,能在高并发系统中扮演至关重要的“加速器”角色,希望这番闲聊,能让你对MemCache的分布式玩法有个直观的理解。 综合了MemCache的通用工作原理、一致性哈希算法的常见解释,以及《大型网站技术架构》等资料中关于缓存应用的经典模式。)

本文由盈壮于2026-01-13发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://waw.haoid.cn/wenda/79888.html