MySQL报错MY-011561,ER_GRP_RPL_SRV_WAIT_TIME_OUT故障远程怎么修复分析

- 问答

- 2026-01-12 12:07:55

- 3

MySQL报错MY-011561,对应的错误信息是ER_GRP_RPL_SRV_WAIT_TIME_OUT,这个错误发生在MySQL Group Replication(MGR,MySQL组复制)环境中,根据MySQL官方文档的解释,这个错误的具体含义是:服务器在等待组通信引擎(Group Communication System, GCS)的运行时信息时发生了超时,就是MGR集群中的一个成员(节点)在尝试与组内其他成员进行必要的通信以完成某个操作(比如加入组、进行数据同步等)时,在预设的时间内没有收到预期的响应,从而导致操作失败。

要远程分析和修复这个故障,不能只盯着错误代码本身,因为它通常是一个表面现象,根源可能多种多样,远程操作意味着我们无法直接接触服务器硬件,只能通过日志和系统命令来诊断,以下是逐步的分析和修复思路。

第一步:立即检查并收集关键信息

当远程接到这个报警时,首先需要登录到出问题的MySQL实例上,查看MySQL的错误日志,错误日志通常会提供更详细的上下文,关键要记录下:

- 错误发生的具体时间点。

- 错误发生前,MySQL正在执行什么操作? 是节点启动试图加入集群?还是正常运行中突然报错?亦或是执行某个特定事务时发生?

- 错误信息中是否包含其他关联信息? 比如等待哪个具体组件超时。

根据MySQL官方文档和Percona等知名数据库社区的经验,需要立刻检查该节点的基本状态,使用SQL命令 SELECT * FROM performance_schema.replication_group_members; 查看当前整个MGR集群的成员状态,出问题的节点可能显示为 ERROR 状态,或者已经从集群中消失,这个步骤可以帮助你判断问题是局部的(仅影响该节点)还是全局的(影响整个集群)。

第二步:分析常见的根本原因及针对性修复

MY-011561错误就像一个“发烧”的症状,很多病都会引起发烧,我们需要找到病因。

-

网络问题(最常见的原因)

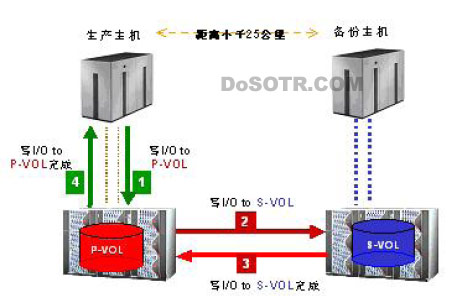

- 分析: MGR对网络延迟和稳定性要求极高,任何轻微的网络抖动、丢包、防火墙规则阻断、DNS解析问题或网络设备(如交换机、路由器)故障,都可能导致节点间心跳或消息传输超时,根据Oracle官方博客的说明,组复制依赖于一个低延迟、高带宽的网络环境。

- 远程检查:

- 使用

ping命令长时间测试到集群其他节点的网络延迟和丢包率。ping -c 100 <其他节点IP>。 - 使用

telnet <其他节点IP> 3306检查MySQL端口的连通性是否稳定。 - 使用

traceroute检查到其他节点的网络路径是否有异常。

- 使用

- 修复: 联系网络团队,排查网络设备和链路,检查并确保防火墙规则允许MGR节点之间所有必要端口(通常是3306和群组通信端口,默认为33061)的通信,如果使用云服务,检查安全组配置。

-

系统资源耗尽

- 分析: 如果节点所在的服务器CPU使用率持续100%,或内存不足导致大量交换(SWAP),或磁盘I/O响应极其缓慢,节点可能没有足够的处理能力来及时响应组内通信,从而导致超时。

- 远程检查:

- 使用

top、htop命令查看CPU和内存使用情况。 - 使用

iostat -x 1查看磁盘I/O利用率和响应时间。 - 检查

dmesg命令输出,看是否有OOM(内存溢出) killer等系统级错误。

- 使用

- 修复: 优化引发高负载的SQL查询,考虑扩容,增加CPU、内存或升级磁盘性能,调整MySQL配置参数,如

innodb_buffer_pool_size以避免过度换页。

-

Group Replication配置不当或参数不匹配

- 分析: 最重要的一个参数是

group_replication_member_expel_timeout,这个参数定义了组在怀疑一个节点失效后,等待多久才将其驱逐出集群,如果设置得过低,在遇到短暂的网络或性能压力时,健康的节点也可能被误驱逐,各个节点的group_replication_group_name、group_replication_local_address等配置必须一致且正确。 - 远程检查: 执行

SHOW GLOBAL VARIABLES LIKE 'group_replication%';并与集群中正常节点的配置进行对比。 - 修复: 如果怀疑是误驱逐,可以适当调高

group_replication_member_expel_timeout的值(默认是5秒,可以尝试增加到10或15秒),但这需要权衡故障检测的灵敏度,确保所有节点的配置文件中关键参数完全一致。

- 分析: 最重要的一个参数是

-

集群脑裂或严重分歧

- 分析: 在极端情况下,如网络发生分区,集群可能分裂成两个或多个无法通信的子组,每个子组都认为自己是主组,节点可能因为无法与“大多数”节点取得联系而出现各种超时错误。

- 远程检查: 通过分别登录不同的网络分区内的节点,执行

SELECT * FROM performance_schema.replication_group_members;,查看各自视角下的集群状态,如果看到的状态不一致,很可能发生了脑裂。 - 修复: 这是一个严重故障,需要人工干预,通常的恢复步骤是选择一个拥有最新数据的子组作为合法组,然后强制其他节点以引导模式(

group_replication_bootstrap_group=ON)重新加入这个组,这个操作有数据丢失风险,需谨慎并在测试环境演练。

第三步:尝试恢复节点

在排查并解决了上述可能的原因后,可以尝试恢复节点,通常的步骤是:

- 停止Group Replication:

STOP GROUP_REPLICATION; - 根据排查结果修正配置或等待网络/资源问题解决。

- 重新启动Group Replication:

START GROUP_REPLICATION; - 再次检查

replication_group_members视图,确认节点是否成功以ONLINE状态重新加入集群。

远程修复MY-011561错误的关键在于日志分析和系统状态检查,这个错误本身没有一键修复的方法,必须将其视为一个线索,系统地排查背后的根本原因,主要集中在网络、资源、配置这三个大方向上,由于是远程操作,与系统管理员和网络团队的紧密协作至关重要,在所有操作前,如果条件允许,对数据库进行备份或快照是一个良好的习惯。

本文由盘雅霜于2026-01-12发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://waw.haoid.cn/wenda/79300.html