云原生5G核心网到底有没有必要非得用DPU才能跑起来呢?

- 问答

- 2026-01-11 20:56:12

- 1

云原生5G核心网绝对不是非得用DPU才能跑起来。 没有DPU,5G核心网一样可以部署和运行,DPU的出现是为了解决在通用服务器上运行5G核心网时遇到的一些关键性能瓶颈和效率问题,更准确的描述是:不用DPU可以跑,但用了DPU可以跑得更好、更省、更稳。

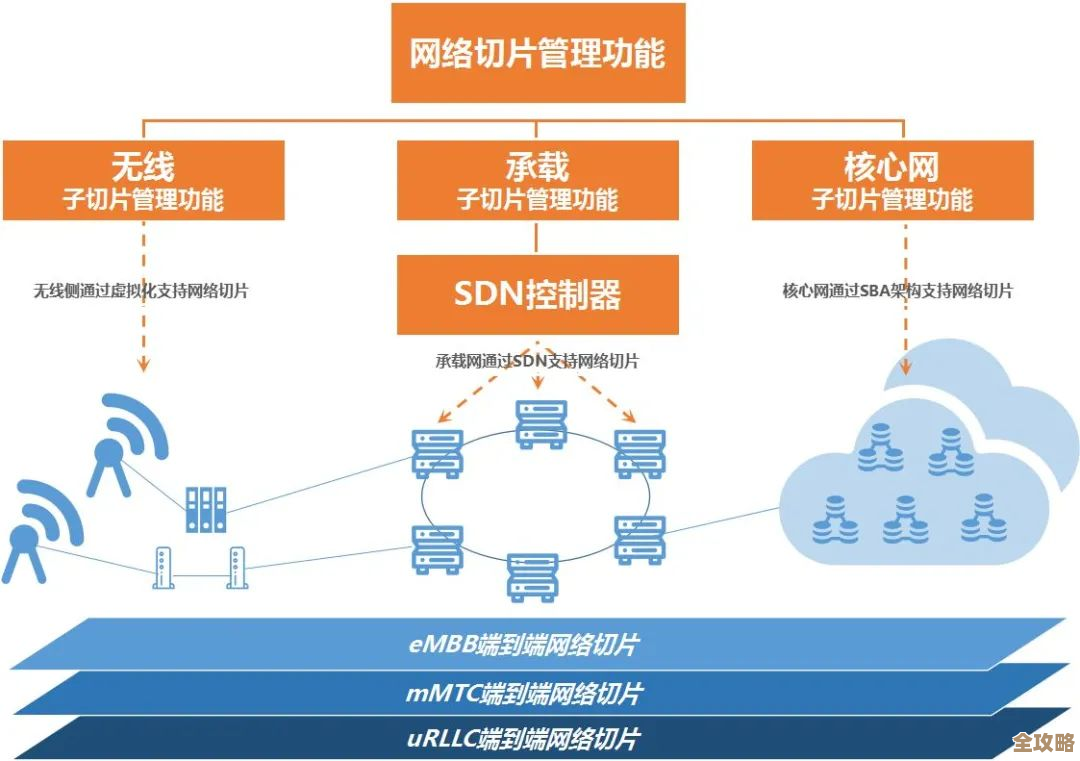

为了理解这一点,我们需要先看看云原生5G核心网带来了什么变化,传统的核心网设备是“黑盒子”,专用硬件和软件捆绑在一起,而云原生5G核心网借鉴了互联网公司的经验,把整个系统拆分成几十个甚至上百个微服务,然后把这些微服务放在由普通服务器组成的云平台上运行,这种做法好处很多,比如弹性伸缩(用户多的时候自动扩容)、快速上线新功能、降低硬件成本等。

正是这种“一切皆在通用服务器上运行”的理念,带来了新的挑战,服务器的心脏是CPU,它要处理的事情非常多:不仅要运行5G核心网的用户认证、会话管理、移动性管理等核心业务逻辑,还要处理海量的数据包转发、加密解密、流量控制等网络底层杂务。

这就好比让一个大学教授(CPU)去干两件事:一是搞科研、带学生(核心网业务逻辑),二是去门口收发快递、登记访客、还要给每个快递盒贴上防拆标签(网络数据包处理),教授当然能做这些杂事,但这会大量占用他本应用于核心工作的宝贵时间和精力,导致整体效率低下,在5G场景下,这个问题被急剧放大了:

- 流量巨大:5G的高速率意味着数据包像海啸一样涌来,CPU光是接收和发送这些包就要耗费大量计算资源。

- 延迟极其敏感:一些5G应用,如远程手术、自动驾驶,要求网络延迟极低且稳定,如果CPU正忙着处理其他任务,导致数据包在队列里等待,延迟就会波动甚至飙升。

- 安全开销大:5G强制要求用户面数据加密(UPF),加密解密是计算密集型任务,用CPU来做同样成本高昂。

这个时候,DPU就登场了。 DPU(数据处理器)可以看作是一个专为“打杂”而生的协处理器,它通常是一张插在服务器里的智能网卡,自己有专门的处理核心和硬件加速引擎,它的核心思想就是“卸载”(Offload)——把那些原本由CPU负责的网络、存储、安全等底层杂务,全部接管过来。

具体到5G核心网,尤其是最吃资源的用户面功能(UPF),DPU能卸载的关键任务包括:

- 数据包快速转发:像专业的快递分拣中心,DPU能线速处理海量数据包,直接从一个端口转到另一个端口,几乎不打扰CPU。

- 硬件加密解密:用专门的硬件电路来完成数据的加密解密,速度极快,功耗极低。

- 流量策略执行:比如限速、流量统计等,也由DPU在硬件层面完成。

这样一来,CPU就从繁重的杂务中彻底解放出来,可以专心致志地处理它擅长的核心网控制面和业务逻辑,带来的好处是立竿见影的:

- 性能飙升:数据转发延迟更低、更稳定,吞吐量更大。

- 成本降低:原本需要多台服务器CPU才能达到的性能,现在一台服务器加DPU就能实现,节省了服务器数量、机房空间和电费。

- 系统更稳定:CPU负载降低,系统更不容易因为流量突发而崩溃。

回到最初的问题:是不是非用不可?

答案取决于运营商的具体需求和场景。

-

对于初期部署、用户量不大、对性能要求不极致的场景:完全可以不用DPU,直接用强大的x86 CPU“硬扛”所有任务,是最简单直接的方案,技术门槛也低,许多开源或商业的云原生5G核心网方案都支持这种纯软件模式。

-

对于大规模商用网络、追求极致性能和TCO(总拥有成本)的场景:DPU几乎成了必选项,尤其是在面向企业专网、工业互联网等需要超低延迟和高可靠性的业务时,DPU带来的性能提升和稳定性保障是纯CPU方案难以比拟的,从长远的经济账来算,虽然DPU本身有成本,但它通过节省服务器数量带来的总成本下降往往是更划算的。

引用来源方面的考量:这个领域的观点主要来自于行业实践和技术白皮书,英伟达(NVIDIA)作为DPU的主要推动者,在其发布的诸多资料(如《DPU加速的5G核心网》等白皮书)中详细阐述了上述优势,主流电信设备商如爱立信(Ericsson)、诺基亚(Nokia)以及电信运营商如德国电信(Deutsche Telekom)等在探讨5G核心网演进时,也都将DPU智能网卡视为实现高性能和低成本的关键技术路径,在开源社区如LFN(Linux基金会网络)的讨论中,如何利用DPU加速边缘和数据中心的网络功能也是一个热点话题。

DPU对于云原生5G核心网而言,不是一个“从无到有”的必需品,而是一个“从有到优”的加速器,它解决了云化架构带来的新瓶颈,是5G核心网在追求极致效率道路上的一次重要进化,选择与否,是一场在初期投入、技术复杂度和长期性能收益之间的权衡。

本文由帖慧艳于2026-01-11发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://waw.haoid.cn/wenda/78907.html