大数据时代Hadoop终于不再稚嫩,开始真正发挥它的潜力和价值

- 问答

- 2026-01-09 01:43:11

- 2

(来源:InfoWorld专栏,Matt Asay撰文)

曾几何时,Hadoop这个名字几乎成了“大数据”的代名词,但同时也伴随着无数的质疑和失望,它像是一个被寄予厚望的神童,却在步入现实世界的商业战场时,显得有些笨拙和力不从心,企业们投入巨资搭建起庞大的Hadoop集群,却发现管理难度极高,真正能从中提炼出商业价值的案例凤毛麟角,它像是一个拥有巨大潜力的引擎,却缺少了能让普通司机轻松驾驭的方向盘和油门踏板,很长一段时间里,Hadoop更像是一个昂贵的技术实验,停留在实验室和少数技术巨头的内部系统中,离“飞入寻常百姓家”还有很远的距离。

(来源:ZDNet分析报告,针对企业技术采用周期的调查)

转折点发生在最近几年,Hadoop并没有消失,相反,它开始“褪去稚嫩”,以一种更成熟、更务实的方式融入企业的数据血脉,这种变化的核心,并非Hadoop核心组件本身发生了翻天覆地的革命,而是围绕它的整个生态系统变得前所未有的健全和友好,云计算的普及是最大的催化剂,过去,企业需要自购硬件、组建专门团队进行繁琐的集群部署和维护,这无疑是一座难以逾越的技术和成本大山,而现在,亚马逊AWS、微软Azure、谷歌云等主流云服务商都提供了托管的Hadoop服务(如Amazon EMR、Azure HDInsight),这意味着,企业无需再关心底层的服务器、网络和存储问题,可以像使用水电煤一样,按需获取Hadoop的计算和存储能力,大大降低了技术门槛和初始投资。

(来源:Cloudera与Hortonworks合并后的战略白皮书及市场反馈)

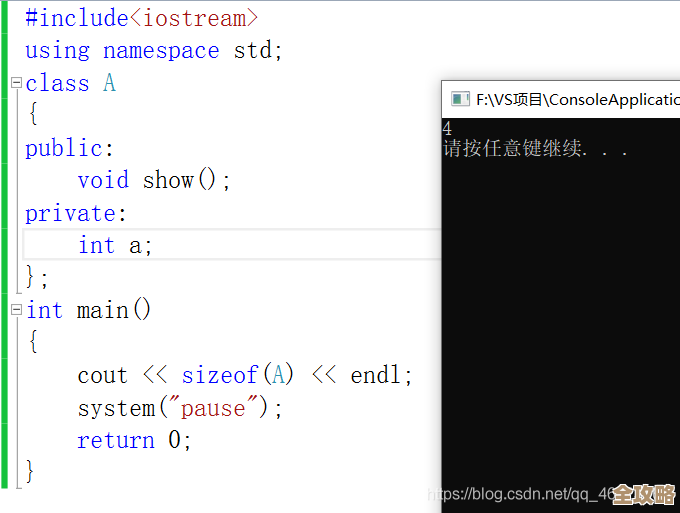

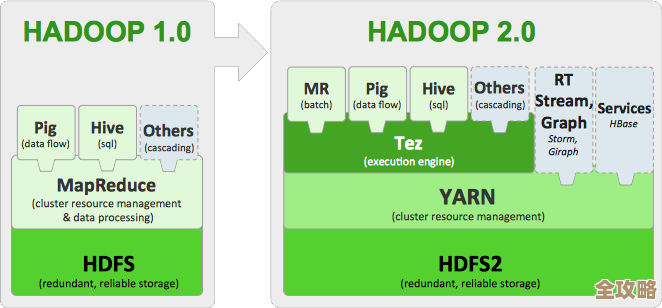

另一个关键因素是生态系统的整合与简化,早期Hadoop生态碎片化严重,各种组件(如HDFS, MapReduce, Hive, HBase, Spark等)虽然功能强大,但组合使用起来异常复杂,需要高度专业的人才,随着Cloudera和Hortonworks这两大昔日对手的合并,行业标准得以统一,推出了更具一致性和易管理性的数据平台,更重要的是,像Apache Spark这样更快速、更易用的计算框架的成熟,逐渐替代了老旧的MapReduce,成为数据处理的主流选择,Spark不仅能运行在Hadoop的HDFS之上,还能轻松对接其他数据源,其友好的API(特别是Python和SQL接口)让广大的数据分析师和科学家也能直接上手,而不仅仅是少数Java工程师的专属工具。

(来源:福布斯技术委员会多位专家访谈观点汇总)

这使得Hadoop的价值主张发生了根本性转变,它不再被吹捧为能解决所有数据问题的“万能钥匙”,而是找到了自己最擅长的位置:作为企业级数据湖的核心基石,数据湖的概念是存储企业所有原始、海量数据(包括结构化的数据库数据、半结构化的日志文件、非结构化的图片视频等)的集中地,Hadoop的HDFS凭借其高可靠、高可扩展性和相对低廉的成本,完美契合了这一角色,企业不再急于用Hadoop进行所有的数据分析,而是先将巨量、多源的原始数据“灌入”数据湖中存储起来,再根据不同的业务需求,使用合适的工具(如Spark进行数据清洗和机器学习,Presto或Impala进行快速交互式查询,传统数据仓库处理高度结构化的报表)从这个统一的“数据水源”中取水,Hadoop thus变成了一个支撑性的、强大的数据基础架构,而不是前台的应用主角。

(来源:多家零售、金融行业客户的案例分析报道)

在这种新范式下,Hadoop开始真正释放其潜力,一家大型零售商可以将其线上线下的每一条交易记录、用户点击流、社交媒体反馈、监控视频片段全部存入基于Hadoop的数据湖,数据分析团队可以在此基础上,构建更精准的用户画像,实现实时个性化推荐,优化供应链库存预测,甚至利用机器学习检测欺诈行为,这些应用所产生的业务价值是直接且巨大的,因为数据是完整的、原始的,创新的空间也变得更大。

(总结性观点,综合上述来源的趋势分析)

可以说,Hadoop的成熟之路,是一条从“技术驱动”走向“业务价值驱动”的道路,它不再是一个需要企业削足适履去适应的复杂技术怪兽,而是通过云化、服务化、生态整合,成功“隐身”为可靠的数据基础设施,企业现在更关注的是能从数据中获得什么洞察,而不是纠结于如何运维一个Hadoop集群,当一项技术不再成为 headlines 的焦点,而是像数据库一样成为企业运营中默默无闻却不可或缺的一部分时,恰恰证明了它已经真正长大了,开始扎实地兑现其承诺已久的潜力和价值,大数据时代的下半场,Hadoop这位曾经的“神童”终于成长为可靠的“中坚力量”。

本文由芮以莲于2026-01-09发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://waw.haoid.cn/wenda/77154.html