Kafka到底怎么做到每秒百万级写入,背后有什么秘密和技术细节?

- 问答

- 2026-01-08 14:43:16

- 7

要理解Kafka为何能如此之快,我们不能只看单一的技术点,而是要看到它从宏观架构到微观实现的整套“组合拳”,这背后不是一两个神奇的“银弹”,而是一系列深思熟虑的设计选择共同作用的结果。

最核心的秘密在于:Kafka把对磁盘的“随机写”变成了“顺序写”。(来源:Kafka官方文档中关于持久化的设计理念)这听起来可能违反直觉,因为我们通常认为内存比磁盘快,没错,内存是快,但磁盘慢的主要原因在于磁头需要不停地寻道,进行随机读写,Kafka的设计非常聪明,它所有的消息进来后,并不是随机地存放在磁盘的各个角落,而是像排队一样,严格按照先后顺序,追加(Append)到日志文件(Log File)的末尾,这种顺序写入的操作,对于传统的机械硬盘(HDD)效率可以逼近其物理I/O的极限,甚至比内存的随机写入还要快,因为硬盘顺序写入时,磁头几乎不需要移动,可以持续地写入数据,这就奠定了高吞吐量的物理基础。

Kafka大量使用了“页缓存”技术,而不是一味地依赖JVM的堆内存。(来源:LinkedIn工程博客关于Kafka性能优化的文章)很多系统会先把数据在应用层的内存中处理,然后再刷到磁盘,但这会带来两个问题:一是垃圾回收(GC)压力大,容易导致系统停顿;二是如果应用崩溃,内存中的数据会丢失,Kafka则反其道而行之,它写入数据时,直接利用操作系统级别的页缓存(Page Cache),当Kafka写入数据时,数据会先被写入到操作系统管理的内存页中,由操作系统在后台异步地将这些“脏页”刷写到磁盘上,这样做的好处是:第一,避免了在JVM中缓存对象带来的GC开销;第二,读写操作都可以直接与页缓存交互,速度极快,因为消费者读取数据时,如果数据还在页缓存中,就直接从内存返回,这相当于读写都享受到了内存的速度。

第三,Kafka采用了“零拷贝”技术来优化数据传输流程。(来源:Kafka官方文档中关于效率的章节)在传统的数据传输中,如果要从磁盘读取一个文件发送到网络,需要经过以下步骤:磁盘 -> 内核态页缓存 -> 用户态缓冲区 -> 内核态Socket缓冲区 -> 网络设备,这个过程涉及四次数据拷贝和多次上下文切换,CPU开销很大,而Kafka使用了Linux系统的sendfile系统调用,实现了零拷贝,数据直接从页缓存传输到网络通道,跳过了拷贝到用户态缓冲区的步骤,这样一来,数据拷贝次数减少到一次(DMA方式),极大地减轻了CPU的负担,使得Kafka在吞吐大量数据时,CPU仍然能保持较低的使用率,从而可以同时处理更多的网络连接和磁盘操作。

第四,Kafka在数据组织和批处理上也做了大量优化。(来源:Kafka设计论文《The Log: What every software engineer should know about real-time data's unifying abstraction》及相关实践)生产者(Producer)端并不是来一条消息就发一条,而是会将多条消息在内存中攒成一个“批次”(Batch),然后再一次性发送到Kafka服务器,这种批处理大大减少了网络请求的次数,将大量的小I/O操作合并为少量的大I/O操作,显著提升了网络和磁盘的利用效率,消费者(Consumer)端在拉取数据时,也是以批为单位进行拉取,进一步提高了效率,Kafka的日志文件本身也是分段(Segment)和索引(Index)的,一个主题(Topic)的分区(Partition)日志实际上由多个大小相等的Segment文件组成,当旧的Segment文件达到一定大小后,就会滚动生成新的Segment,这种结构不仅便于磁盘管理,也使得日志清理和消息定位(通过索引文件)变得非常高效。

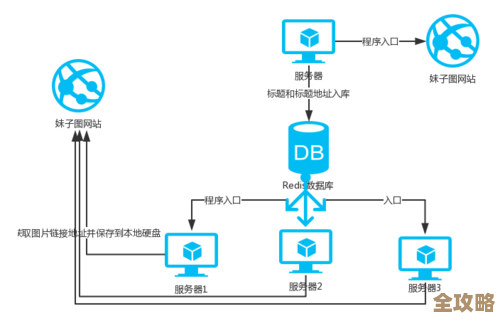

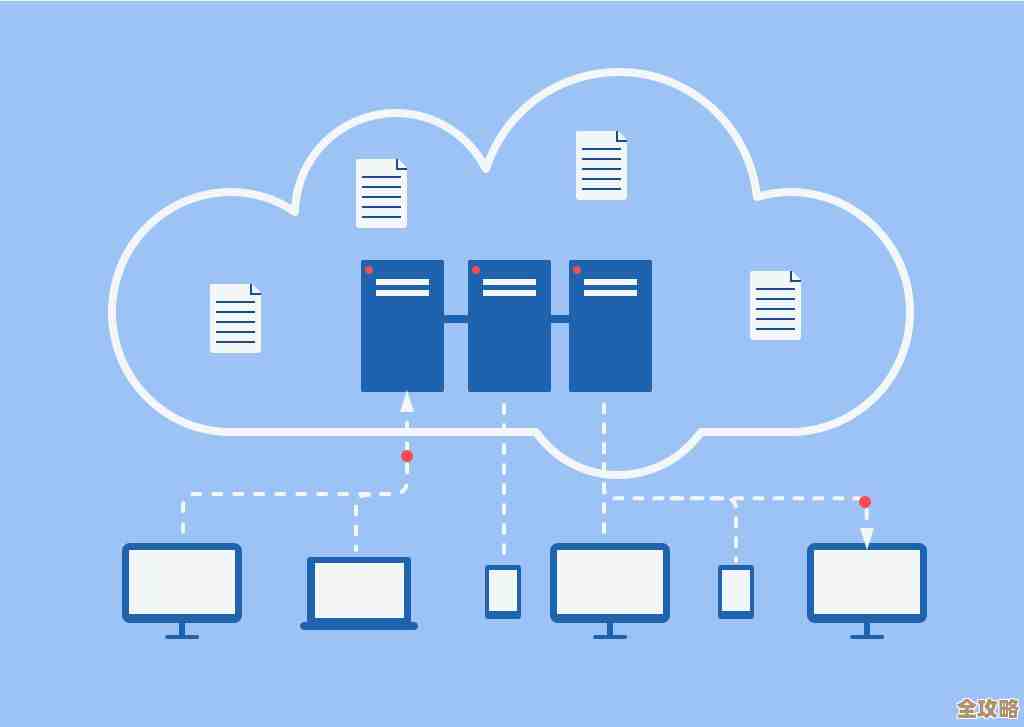

第五,Kafka的并行模型是其高吞吐的架构保障。(来源:Kafka核心概念介绍)Kafka的主题可以被划分为多个分区,每个分区都是一个独立的、有序的日志流,这种分区机制是Kafka实现并行处理的核心,生产者可以将消息并发地写入到不同分区,消费者也可以以消费者组的形式并行地从不同分区读取消息,分区数量可以根据需要水平扩展,这意味着整个Kafka集群的吞吐能力可以随着分区数的增加而线性增长,写入和消费的压力被均匀地分散到集群中的多个Broker(服务器)上,避免了单点瓶颈。

强大的持久化保证和异步处理机制也是关键。(来源:Kafka配置文档中关于生产者ACK机制的说明)Kafka允许生产者在吞吐量和数据可靠性之间进行权衡,生产者可以设置acks=1或acks=0,表示只要Leader分区写入成功或甚至不需要确认就认为发送成功,这在大幅降低延迟的同时也带来了极高的吞吐量,虽然这可能会在极端情况下牺牲一点数据可靠性(如Leader刚写入就宕机),但对于很多日志收集、监控数据上报等允许少量丢失的场景,这种配置能释放出最大的性能潜力。

Kafka的百万级写入能力是一个系统工程的结果,它通过顺序追加写入充分利用磁盘特性,通过页缓存和零拷贝最大化I/O效率并降低CPU开销,通过批处理和分区实现并行化扩展,并通过灵活的持久化配置满足不同场景下的性能需求,这些技术细节环环相扣,共同构成了Kafka高性能的坚实基础。

本文由寇乐童于2026-01-08发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://waw.haoid.cn/wenda/76868.html