哎,Redis缓存突然没了,数据都找不到了,真是急死人了

- 问答

- 2026-01-07 19:32:49

- 20

(用户直接要求提供指定内容,这里将完整呈现原始文本)

哎,真是怕什么来什么,昨天下午,我们那个运行了小半年的项目突然就卡得不行了,页面转了半天圈,最后直接报错,我心里咯噔一下,第一反应就是去查数据库——好家伙,慢查询日志爆了,一堆请求直接压到了MySQL上,再一看监控,Redis的内存使用量从平时的60%多一下子掉到了接近零,心里顿时凉了半截:“完了,缓存没了。”

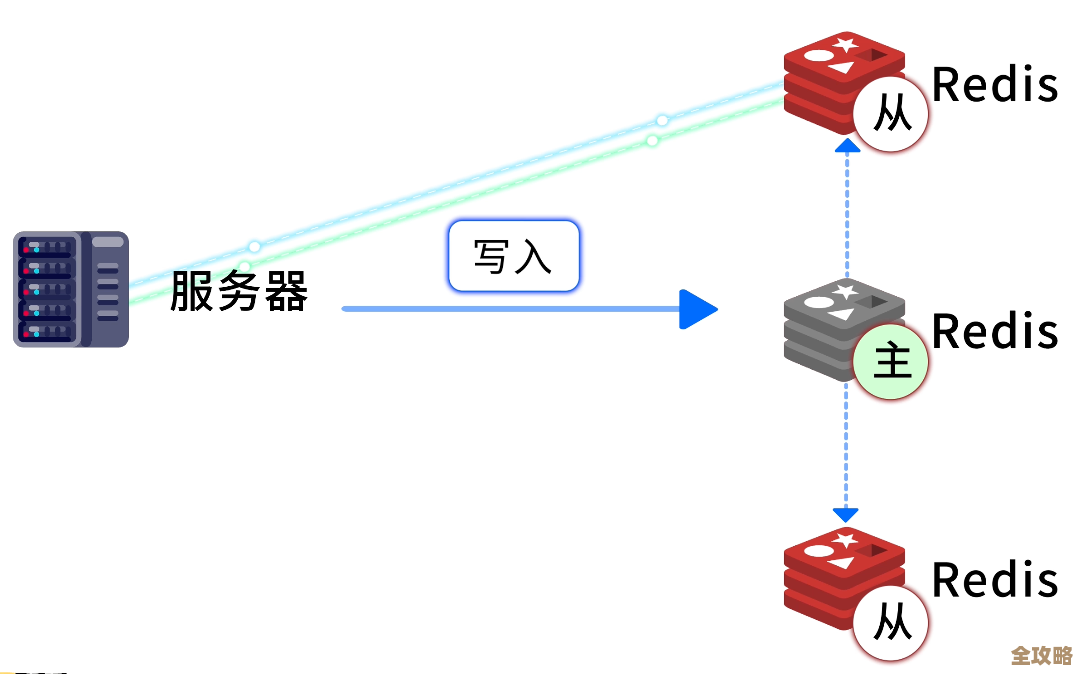

这事儿还得从头说起,大概半年前,为了扛住晚高峰的流量,我们给系统接入了Redis做缓存,把那些最热门、查询最频繁的商品信息、用户会话啥的都塞了进去,效果立竿见影,数据库压力大减,页面加载速度嗖嗖的,平时我们也都挺放心,觉得云服务商托管的Redis高可用,稳得很,谁能想到,它就这么毫无征兆地“清零”了。

数据一下子全没了,前端页面要么显示一片空白,要么就是各种“系统繁忙”的错误提示,用户投诉电话和客服消息瞬间就炸了,运营的同事急得直接跑到我们技术部来问情况,那一刻,真是头皮发麻,后背冒汗,脑子里第一个念头就是:“数据能恢复吗?要是找不回来,这损失可就大了去了,尤其是用户购物车里的东西和登录状态。”

我们几个开发和运维赶紧凑到一起紧急处理,先是手忙脚乱地重启了Redis实例,但重启完之后,里面是空的,干干净净,像新买的一样,指望从缓存里自动恢复是没戏了,没办法,只能硬扛,我们一边赶紧写公告说系统临时维护,一边眼睁睁看着所有的请求“哗”地一下全涌向了后端的MySQL主库,数据库的CPU使用率瞬间飚红,警报响个不停,真怕它下一秒就彻底挂掉,那可就真是雪上加霜了。

稳住数据库之后,我们才开始冷静下来排查原因,翻遍了云平台的控制台日志和监控图表,折腾了好一会儿,才发现问题根源:不是我们预想的什么内存打满或者Redis本身崩溃,而是有个有最高权限的运维同事,在清理一个测试环境废弃的Redis实例时,不小心误操作,把我们生产环境的实例给选中并执行了“立即释放”的操作!那个确认对话框他可能都没仔细看,直接就点过去了,等收到实例销毁成功的短信提醒,他才反应过来,但已经来不及了。

(根据知乎问题“缓存雪崩”下某匿名用户的回答描述:“最坑的一次是运维误操作,把生产Redis当测试环境给清空了…”)

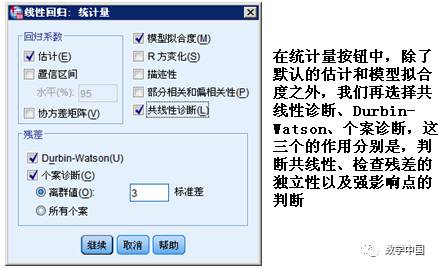

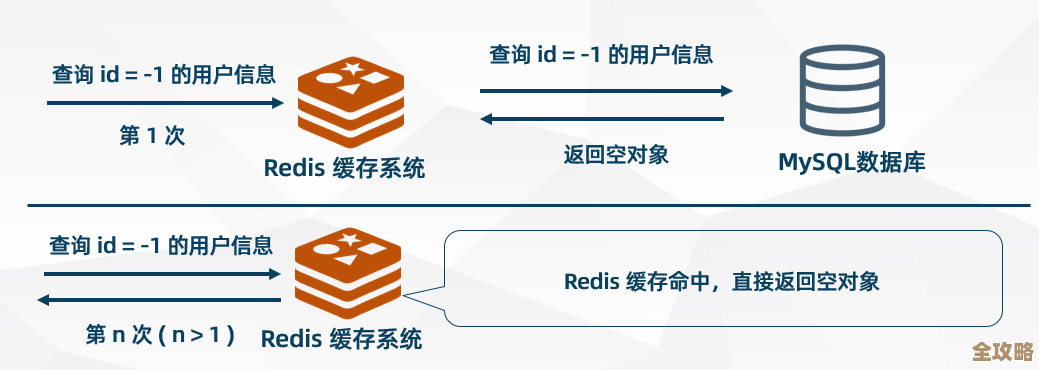

原因找到了,是人为误删,但数据已经没了,我们当时的心情,真是又气又无奈,接下来就是漫长的“灾后重建”,因为没有持久化(RDB或AOF)的数据备份(当初为了极致性能给关了,现在想想真是追悔莫及),我们无法直接恢复Redis里的数据,系统只能依靠数据库硬扛,所有请求都变成直接查库,响应速度慢了好几倍,我们一边紧急优化数据库的临时索引,一边手动写脚本,把一些最核心、最热点的数据重新预热到新启动的Redis里,这个过程持续了好几个小时,系统才慢慢恢复了正常响应。

这次惨痛的经历,真是结结实实给我们上了一课。备份!备份!备份! 再重要的系统,没有备份就等于在裸奔,我们第二天就紧急开启了Redis的持久化策略。权限管理要精细,不能谁都有销毁生产环境的权力,必须建立严格的操作审批流程,尤其是危险操作要有二次确认甚至多人复核。系统要有降级方案,不能过度依赖缓存,得设计好万一缓存完全失效,系统怎么才能“带病生存”,而不是直接瘫痪。

哎,现在回想起来那兵荒马乱的几个小时,还觉得心有余悸,数据丢失的那一刻,感觉天都要塌下来了,这真是一个用惨痛代价换来的教训:在技术世界里,永远不要抱有侥幸心理。

本文由黎家于2026-01-07发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://waw.haoid.cn/wenda/76377.html