分布式存储里DHT算法那些改进和优化的点,怎么能更好地提升性能和稳定性

- 问答

- 2026-01-06 19:06:50

- 7

在分布式存储系统中,DHT(分布式哈希表)是核心的寻址技术,它决定了数据如何分布以及如何被找到,最初的DHT设计,比如Chord、Kademlia等,解决了基本问题,但在实际大规模应用中,面临着性能、稳定性、资源消耗等多方面的挑战,研究者们提出了许多改进和优化的思路。

提升查找效率:从“跳数”到“延时”的优化

最早的DHT算法往往以“跳数”作为优化目标,即一次查询需要经过多少个中间节点,但跳数少并不完全等同于速度快,在实际网络中,节点之间的物理网络延迟差异巨大,可能一次跨洋的跳转,其延迟远高于在同一个数据中心内的三四次跳转。

一个重要的优化方向是基于网络延迟的路由优化,这个思路在微软研究院的“Vivaldi”算法中有深入探讨,其核心思想是让每个节点都去测量与它通信的其他节点的网络延迟,并据此为每个节点在虚拟空间中计算一个“坐标”,当需要路由时,节点不再是简单地选择ID最接近的邻居,而是会选择虚拟坐标上距离最近(即预估延迟最低)的邻居来转发请求,这样,查询路径虽然在逻辑跳数上可能变多,但整体的响应时间却显著降低,提升了用户体验和系统吞吐量。

增强系统稳定性:应对节点的频繁加入和离开

在真实的P2P环境中,比如BT下载网络,节点随时会下线(称为“Churn”现象),传统的DHT在节点频繁变动时,需要花费大量资源来维护路由表的正确性,否则就会导致查询失败。

针对这个问题,主要的优化点在于增强路由表的冗余性和容错能力,Kademlia算法本身的设计就比Chord有更好的容错性,因为它维护的不是一个单一后继节点,而是多个节点组成的“K桶”,即使桶里的一部分节点失效,仍然有其他备选节点可用。

进一步的优化包括:

- 主动维护与被动学习:节点不仅定期主动刷新路由表,还会从过往的查询请求中学习新的、存活的节点信息,动态更新自己的路由表,这就像一个人不仅定期联系老朋友,还会在每次社交活动中认识新朋友并记住他们。

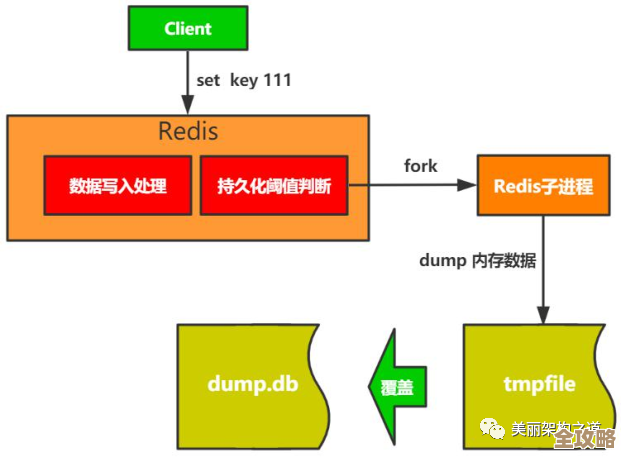

- 持久化路由状态:节点在正常退出时,可以将自己的路由表信息保存下来,下次上线时直接加载,加速路由网络的收敛速度,而不是每次上线都从零开始构建视图。

改善数据存储的均匀性与可靠性

标准的DHT通过哈希函数决定数据存放位置,理想情况下是均匀的,但如果节点之间的硬件能力(如存储空间、网络带宽)差异很大,均匀分布反而会成为问题,因为弱节点可能因负载过重而崩溃。

优化方法是引入负载均衡机制,允许高性能节点虚拟成多个“虚拟节点”,每个虚拟节点在DHT环上占据一个独立的位置,这样,一个物理节点可以承担多个虚拟节点的数据存储责任,通过控制虚拟节点的数量,就可以让能力强的节点承担更多负载,能力弱的节点承担较少负载,从而实现按能力的均衡分配,这个思想在很多实际系统如Amazon的Dynamo中得到了应用。

对于数据可靠性,DHT通常采用多副本策略,即一份数据不止存放在一个节点上,而是冗余存放在多个节点上,优化点在于副本放置策略,简单的做法是放在ID相邻的连续节点上,但这存在风险,如果这些节点同时处于同一个不稳定的网络(如同一个机房),可能会同时失效,更优的策略是考虑网络拓扑和故障域的副本放置,比如将副本分散在不同的机房、不同的网络运营商甚至不同的地理区域,最大限度地避免单点故障导致的数据不可用。

安全性与对抗恶意节点

原始的DHT设计假设所有节点都是善意的,但现实中有大量恶意节点可能发起攻击,比如试图污染数据(存储错误数据)或破坏路由(将查询引向错误方向)。

优化措施包括:

- 数据验证机制:为存储的数据附加数字签名,查询到的节点可以验证数据的真实性和完整性,拒绝恶意节点提供的假数据。

- 安全的路由表维护:在将节点加入路由表时,进行一定的“资质审查”,比如优先选择那些长期在线、行为稳定的节点,对行为异常的节点进行隔离或剔除,斯坦福大学提出的“SybilAttack”研究就深入探讨了这类身份伪造攻击及其防御思路。

结合具体应用场景的混合优化

没有放之四海而皆准的最优解,许多优秀的分布式存储系统会根据自身业务特点进行混合优化,对于需要范围查询的场景,可能会对DHT进行改造,或者将DHT与其他数据结构(如树结构)结合,对于内容分发网络(CDN)类应用,则会极度强调缓存机制,将热门数据缓存在离用户更近的边缘节点,减少对DHT核心查询路径的依赖,这本质上是牺牲一定程度的一致性来换取极高的性能。

对DHT的优化是一个持续的过程,核心思想是从理想的数学模型走向复杂的工程现实,通过引入网络感知、增加冗余、动态适应、安全加固和场景化设计,使其在性能、稳定性和可靠性上能够满足现代大规模分布式系统的严苛要求。

本文由盘雅霜于2026-01-06发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://waw.haoid.cn/wenda/75739.html