MySQL报错ER_GRP_RPL_DONOR_CONN_TERMINATION导致连接断开,远程修复方案分享

- 问答

- 2026-01-06 11:43:17

- 6

MySQL报错ER_GRP_RPL_DONOR_CONN_TERMINATION导致连接断开,远程修复方案分享

今天我们来聊一个在MySQL Group Replication(MGR)集群环境中可能遇到的让人头疼的问题:ER_GRP_RPL_DONOR_CONNECTION_TERMINATION错误,这个错误直译过来就是“组复制捐赠者连接终止”,它会导致集群节点间的连接突然断开,严重时甚至可能影响整个集群的可用性,根据知乎专栏《数据库运维实战》中的案例描述,运维人员常常会在数据库的错误日志中发现类似这样的报错信息,然后伴随着某个节点被踢出集群的情况。

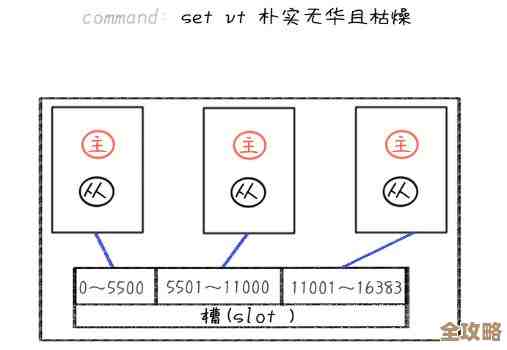

我们得简单理解一下这个错误到底是什么意思,在MGR集群里,数据是通过一种叫做“Paxos”的协议在各个节点之间同步的,当一个节点(我们称之为“新节点”或“加入者”)要加入集群,或者一个现有节点因为网络波动等原因需要重新追赶数据时,它会从一个健康的、数据较新的节点(这个节点就被称为“捐赠者”或“Donor”)那里拉取数据,CSDN博客《高可用架构故障排查笔记》里打了个比方,这就像一个新同学转学过来,需要从学习委员那里抄一份完整的课堂笔记,这个“抄笔记”的过程,在MySQL里就叫做“分布式恢复”,而ER_GRP_RPL_DONOR_CONNECTION_TERMINATION错误,就是在“抄笔记”这个过程中,连接突然断开了,可能是“新同学”(加入者)这边出了问题,也可能是“学习委员”(捐赠者)那边遇到了状况,导致笔记没抄完,连接就断了。

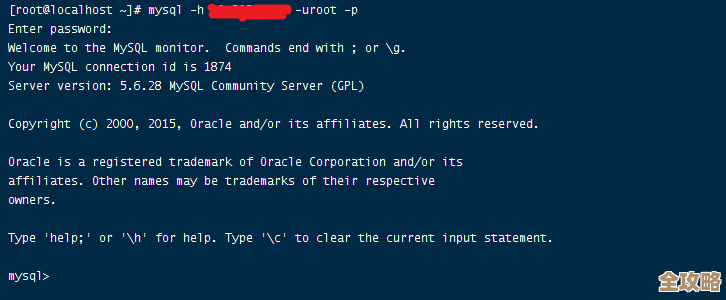

当我们通过监控系统告警或者业务方反馈发现某个节点异常,远程登录服务器查看日志确认是这个错误后,应该如何一步步排查和修复呢?以下是一些经过实践验证的远程修复思路。

第一步,也是最紧急的一步:评估影响并稳定集群。

不要一上来就急着重启出问题的节点,你需要立刻连接上当前集群中的主节点(Primary),执行SELECT * FROM performance_schema.replication_group_members;命令,查看当前集群的整体状态,确认是否真的只有一个节点被踢出,而其他节点仍然组成一个健康的集群在对外提供服务,如果主集群是健康的,那么业务影响可能暂时有限,这给了你更从容的排查时间,确保现有集群稳定是第一要务。

第二步,深入分析错误日志,定位断开的根源。 光看一个错误代码是不够的,你需要仔细阅读出错节点MySQL错误日志中,在这个错误发生前后一段时间内的详细记录,根据《数据库运维实战》的经验,重点关注以下几个方面:

- 网络问题:日志中是否有网络超时(timeout)、连接重置(connection reset)等相关的信息?这可能是机房网络抖动、防火墙规则变更、或者网卡故障导致的,这是最常见的原因之一。

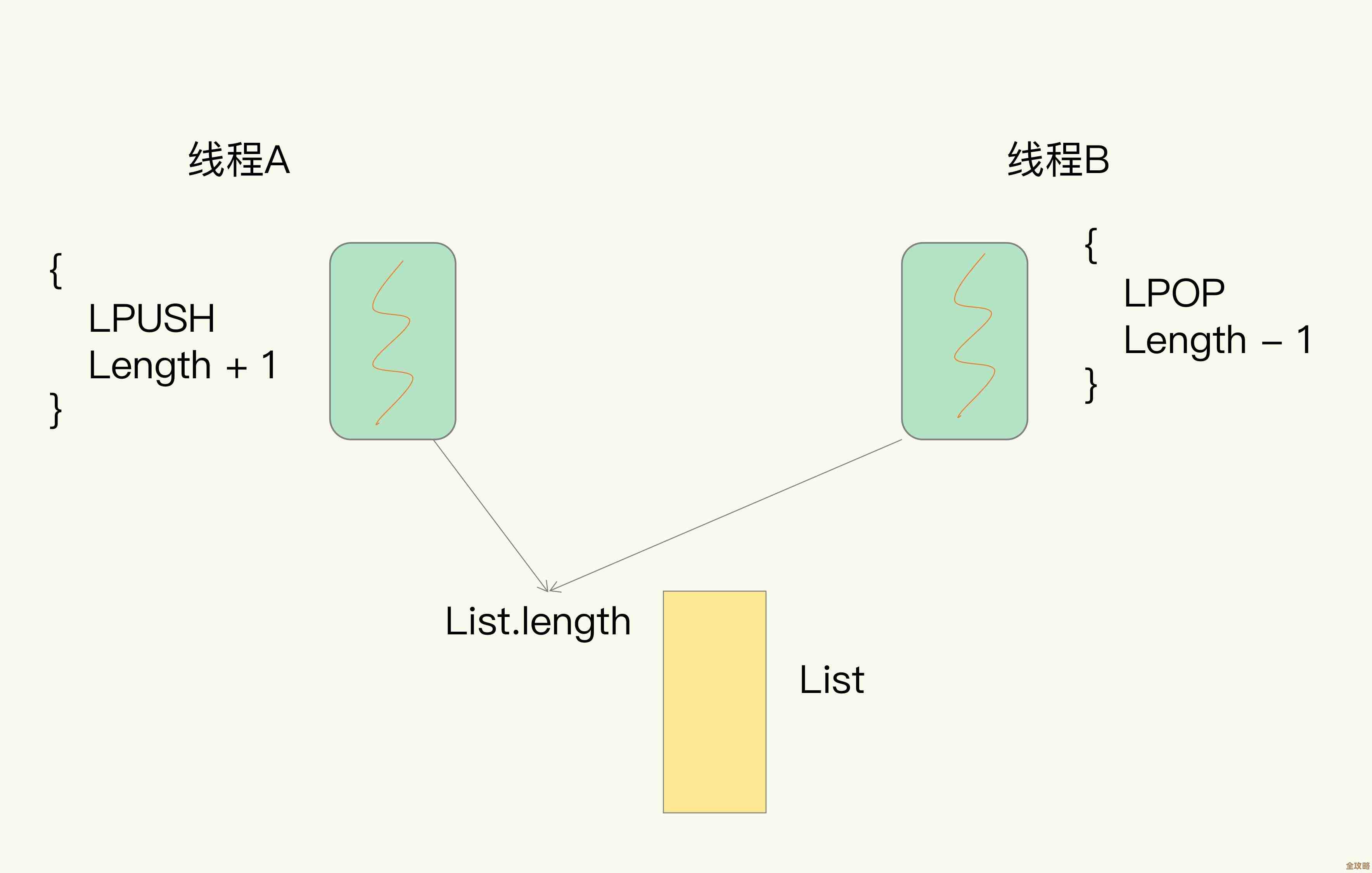

- 捐赠者节点压力:查看当时捐赠者节点的系统监控(如果可获取),看其CPU、内存、磁盘IO是否出现过载,如果捐赠者本身业务繁忙,可能无法及时响应数据传输请求,导致超时断开。

- 复制数据量过大:如果新节点缺失的数据非常多(落后了几个G甚至更多的二进制日志),在传输过程中,网络稍微不稳定就可能导致长时间等待而超时。

- 参数配置不当:一些与组复制和网络超时相关的参数可能设置不合理。

group_replication_recovery_connect_retry(重试间隔)、group_replication_recovery_retry_count(重试次数)设置得过短或过少,可能还没来得及重连成功就放弃了,还有像net_write_timeout,net_retry_count等网络超时参数也可能需要检查。

第三步,针对性地实施修复操作。 根据上面分析出的可能原因,我们可以尝试以下修复方案:

-

如果是偶发网络抖动:这可能是最简单的状况,你可以直接尝试重启这个被踢出的节点的MySQL服务,让它重新尝试加入集群,在重启前,确保你怀疑的网络问题已经恢复,很多时候,一次重启就能解决临时性的网络问题导致的中断。

-

如果怀疑捐赠者节点压力大:可以尝试手动指定一个负载较低的节点作为捐赠者,在出问题的节点的MySQL配置文件中(如my.cnf),临时添加或修改参数:

group_replication_recovery_donor = '低负载节点的IP:端口',然后重启该节点的MySQL服务,强制它从指定的、空闲一点的“学习委员”那里抄笔记。

-

如果数据差异巨大导致传输超时:对于数据落后非常多的节点,直接通过组复制恢复可能会非常困难且耗时,这时,更稳妥的办法是“放弃治疗”,直接重建这个节点,具体操作是: a. 停止该节点的MySQL服务。 b. 清空其数据目录(datadir)下的所有数据文件(务必先备份!)。 c. 像初始化一个全新从节点一样,从当前主集群的一个节点上拉取一份全新的数据快照(使用mysqldump物理备份工具,或者Percona XtraBackup工具)。 d. 使用这份新的数据快照恢复数据,然后重新配置并启动组复制,让它以一个“全新”的身份加入集群,这种方法虽然耗时较长,但成功率高,避免了在传输大量数据时再次失败。

-

检查和调整超时参数:如果上述方法效果不佳,或者这个问题反复出现,你可能需要重新审视超时参数的设置,可以适当调大

group_replication_recovery_connect_retry和group_replication_recovery_retry_count的值,给网络恢复和数据传输留出更充裕的时间,但要注意,调整参数需要权衡,设置过长可能会在出现真正故障时延长故障恢复时间。

在所有操作完成后,务必再次检查replication_group_members视图,确认节点已经成功重新加入集群,并且状态显示为ONLINE,持续观察一段时间集群的同步延迟和稳定性。

处理ER_GRP_RPL_DONOR_CONNECTION_TERMINATION错误,关键在于耐心查看日志,像侦探一样找出连接断开的根本原因——是网络、是负载、还是数据量?然后对症下药,从最简单的重启,到指定捐赠者,再到最彻底的重建节点,远程操作尤其要谨慎,确保每一步操作都不会对现有的健康集群造成二次伤害。

本文由革姣丽于2026-01-06发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://waw.haoid.cn/wenda/75548.html