Redis脏读问题怎么破,实用技巧和思路分享给你看看

- 问答

- 2026-01-02 07:30:13

- 2

Redis脏读问题,说白了就是你读到的数据可能是个“过期”的或者不准确的“假数据”,这在高并发、多服务同时操作Redis的场景下特别容易出现,想象一下,你刚在商城下单减了库存,另一个用户查询时却看到了减库存前的数量,这就是典型的脏读,要解决这个问题,得从几个方面入手,下面分享一些实用的思路和技巧。

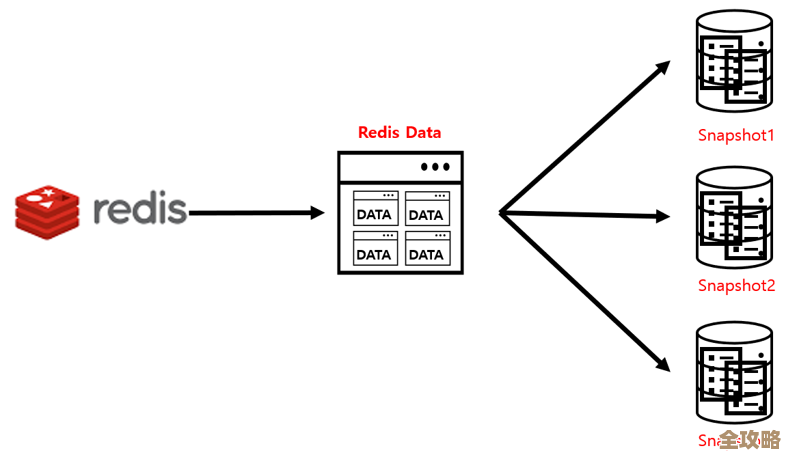

得搞清楚脏读是怎么来的。 脏读通常发生在读写分离的架构里,很多公司为了提升Redis的读取性能,会搭建主从架构,主节点(Master)负责写操作,从节点(Slave)负责读操作,但主节点把数据同步到从节点是需要时间的,虽然这个时间很短,可能就几毫秒,但在超高并发的瞬间,如果一个写操作刚在主节点完成,你立刻去从节点读,很可能读到的是同步之前的老数据,这就是最常见的“主从延迟”导致的脏读,还有一种情况是,服务A刚修改了Redis里的某个值,服务B立马去读,但服务A可能还没完成整个事务(比如后续还有数据库更新),服务B读到的就是一个中间状态的数据,这也是脏读。

知道了原因,我们就可以见招拆招了,下面是一些实用的解决思路:

第一招,最简单粗暴但也最有效的:强制读主库。 既然脏读是因为读了可能滞后的从库,那我们就让所有对数据一致性要求极高的读请求,都直接去主库读,用户下单扣减库存后,立刻查询库存余额以确认是否成功,这个查询请求就应该发往主库,很多Redis客户端框架都支持在代码中指定某个读操作走主节点,这种方法立竿见影,但代价是增加了主库的压力,失去了读写分离带来的读性能扩展优势,所以这只适用于核心、关键业务路径,不能所有读都这么干。

第二招,针对“逻辑时序”问题:用延迟双删策略。 这个技巧在缓存和数据库双写的场景下特别有用,你先更新了数据库,然后要删除Redis缓存,但如果在删除缓存后、数据库主从同步完成前,有请求过来,它可能会把数据库从库里的旧数据再次塞回缓存,导致后续请求一直读到脏数据,延迟双删的步骤是:

- 先删除Redis中的缓存。

- 再更新数据库。

- 等待一小段时间(比如几百毫秒到1秒,这个时间需要根据你数据库的主从同步时间估算)。

- 再次删除Redis缓存。 这个第二次的“延迟删”,就是为了清除可能在第一步和第二步之间,以及数据库主从同步期间,被其他请求写入缓存的旧数据,这个方法能很大程度缓解脏数据在缓存中驻留的问题。

第三招,利用Redis自身的特性:给缓存数据设置一个较短的过期时间。 这是一个兜底的策略,即便因为某些原因脏数据没有被及时清理,但只要给缓存Key设置一个较短的TTL(生存时间),比如5秒、10秒,那么脏数据最多也只会存在几秒钟,之后就会自动过期,当再次有请求时,就会从数据库重新加载最新数据到缓存,这不能杜绝脏读,但能控制脏读的影响时间窗口,是一种用“最终一致性”来妥协的方案,对业务影响相对较小。

第四招,更复杂的思路:通过消息队列异步清理。 当业务逻辑非常复杂,涉及多个数据源更新时,可以在完成所有数据更新(比如数据库事务提交后),发送一个消息到消息队列(如RocketMQ、Kafka),然后有一个专门的消费者来接收这个消息,负责去删除或更新对应的Redis缓存,这样做的好处是,将缓存清理操作与主业务逻辑解耦,确保只有在所有数据都确定更新成功后,才去清理缓存,避免了中间状态的脏数据被读取,但这套方案技术复杂度比较高,适合大型、复杂的系统。

还有一个思路是放弃缓存,直接读库。 听起来是倒退,但在某些极端场景下却是最可靠的选择,如果某个数据的正确性至关重要,比如金融账户的余额,任何一点脏读都可能造成资损,对于这个特定的查询,宁可牺牲一些性能,也要直接查询数据库,换取绝对的准确性,这需要根据业务场景做权衡。

解决Redis脏读没有银弹,核心是根据你的业务对一致性的要求级别来选择合适的策略,对于要求强一致性的核心业务,可以“强制读主”或“直接读库”;对于可以接受短暂不一致的非核心业务,可以用“延迟双删”和“设置短过期时间”来平衡性能与一致性;对于复杂系统,可以考虑“消息队列”这类更彻底的解耦方案,理解每种方法的优缺点和适用场景,才能在实际项目中做出最合适的选择。 来源:综合自常见的Redis高并发架构下的数据一致性解决方案,如主从延迟处理、缓存更新策略等业界实践。

本文由称怜于2026-01-02发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://waw.haoid.cn/wenda/72946.html