Redis缓存里那重试机制到底咋回事,怎么保证数据不丢失又不卡顿

- 问答

- 2026-01-02 05:43:31

- 5

关于Redis缓存的重试机制,以及如何保证数据不丢失又不卡顿,这其实是两个紧密相关但又需要分开来看的问题,咱们把它拆开,用大白话讲清楚。

第一部分:重试机制到底在“重试”什么?

重试不是Redis服务器自己闲着没事干,在那里反复尝试,Redis本身的设计是追求简单和速度,它不会主动去做复杂的重试,这里说的“重试”,主要是指我们使用Redis的应用程序(也就是你的业务代码)在跟Redis打交道时,遇到问题所采取的行动。

会遇到哪些问题需要重试呢?主要分两大类:

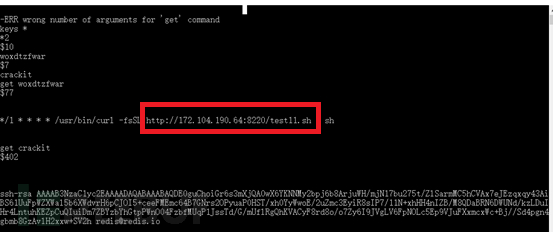

- 网络问题:你的应用程序和Redis服务器是在不同的机器上,通过网络连接的,网络总有不稳定的时候,比如网络瞬间抖动、路由器抽风、防火墙搞事情,这可能导致一次请求(比如要往Redis里存个数据)发出去后,没收到回应,你的程序这时候就蒙了:“它到底收到没?是已经存好了但回复我的消息丢了,还是它根本就没收到?” 这种不确定性是重试的主要场景。

- Redis本身暂时性故障:虽然Redis很稳定,但也不是金刚不坏之身,Redis正在进行持久化(把内存数据写到硬盘上)的瞬间,或者主从切换(一台主库挂了,把一台从库升级成新主库)的时候,它可能短时间内无法正常处理请求,会返回一个错误或者直接没响应。

当遇到这些情况时,如果你的程序直接摆烂,给用户返回一个“系统错误”,那体验就太差了,特别是对于一些关键操作,比如扣减库存、发放优惠券,一次失败可能就意味着损失,我们需要“重试机制”,也就是程序不能轻易放弃,得本着“再试一次,说不定就好了”的精神,多尝试几次。

第二部分:怎么重试才能不卡顿?—— “聪明地”重试

傻乎乎的重试很危险,如果一次请求失败,你的程序立刻、马上、不间断地连续重试100次,这会产生两个坏结果:

- 卡顿:用户点一下按钮,你的程序因为在那不停地重试,页面就一直转圈圈,用户等得不耐烦就走了。

- 雪崩效应:如果Redis是因为压力大或者短暂故障而响应慢,你这一波接一波的重试请求,就像给一个已经生病的人不断喂饭,不仅帮不了它,反而会把它彻底压垮,导致故障扩大。

保证不卡顿的关键在于 “退让” ,聪明的重试策略通常是这样的:

- 指数退避:这是最常用的策略,第一次失败后,等一小会儿(比如100毫秒)再重试;如果又失败,下次等待时间就翻倍(200毫秒);再失败,再翻倍(400毫秒)……这样等待时间会指数级增长,这给了Redis足够的喘息时间,避免请求洪峰,对你的应用程序来说,重试是在后台异步进行的,或者至少设置一个很短的重试超时时间,绝不会让用户前台一直傻等。

- 限制重试次数:不能无休止地重试下去,通常设置一个最大重试次数,比如3次或5次,重试这么多次之后如果还不行,就真的放弃了,转而执行降级方案(比如去直接查数据库,或者给用户一个友好的提示),这既给了问题恢复的机会,又避免了无限等待造成的“卡顿”。

第三部分:怎么重试才能保证数据不丢失?—— 这是更复杂的问题

首先要明确一个残酷的现实:单纯靠重试机制,无法100%保证数据不丢失。 重试主要解决的是“请求是否成功送达并执行”的不确定性问题。

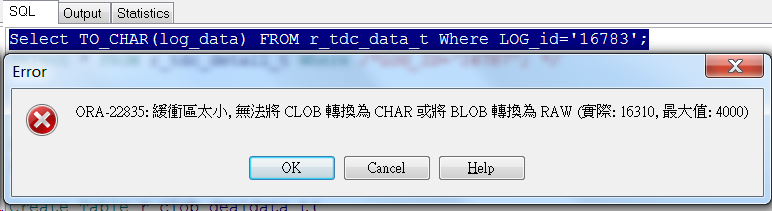

举个例子,你的程序发出一条命令:“set user_balance_123 100”,可能发生以下几种情况:

- 最好情况:Redis收到命令,成功执行,但返回成功的网络包丢了,你的程序没收到回复,以为失败了,于是重试,第二次发过去,Redis一看,“user_balance_123”这个键已经存在了,但值也是100,它可能就简单地覆盖一下(或者返回成功),最终数据是对的,重试避免了因为网络问题导致的数据不一致。

- 最麻烦的情况:你的命令是“incrby user_balance_123 100”(余额增加100),第一次请求,Redis成功执行了,余额变成了200,但回复丢了,程序重试,又发了一次“incrby user_balance_123 100”,Redis再次执行,余额变成了300,这就造成了数据错乱,比丢失还可怕!

要真正保证“不丢失”,需要结合其他机制,重试只是其中的一环:

- 幂等性设计(关键中的关键):这是解决上面那个“最麻烦情况”的法宝,意思是,让你的同一条操作指令,无论执行一次还是多次,产生的结果都一样,上面的扣减库存操作,不要用

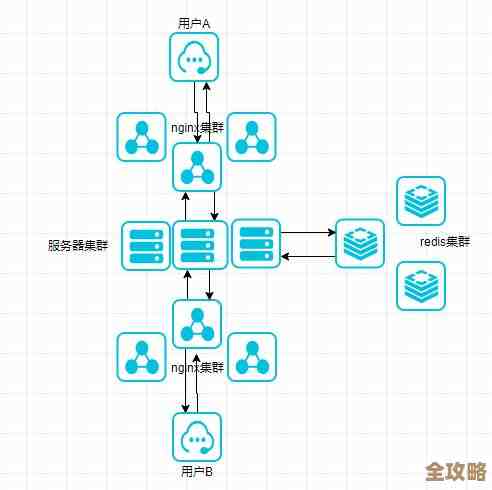

DECR(递减)命令,而是改用SET命令,直接设置一个确定的值,或者使用Redis的Lua脚本,将“判断-计算-设置”多个操作做成一个原子性的、支持幂等的复合操作,这样即使网络问题导致重试,因为操作本身是幂等的,重复执行也不会错。 - 异步写入与确认机制:对于一些极高要求的场景,比如金融交易,光靠Redis和重试可能不够,可以采用更可靠的模式:应用程序先把要变更的数据顺序写入一个非常可靠的消息队列(如Kafka、RocketMQ),这个写入本身有重试和确认机制,再有一个单独的数据同步服务从消息队列里消费消息,去更新Redis,这样即使更新Redis失败,消息还在队列里,可以不断重试,直到成功,这相当于把“保证不丢失”的责任从实时API调用转移到了可靠的消息系统上。

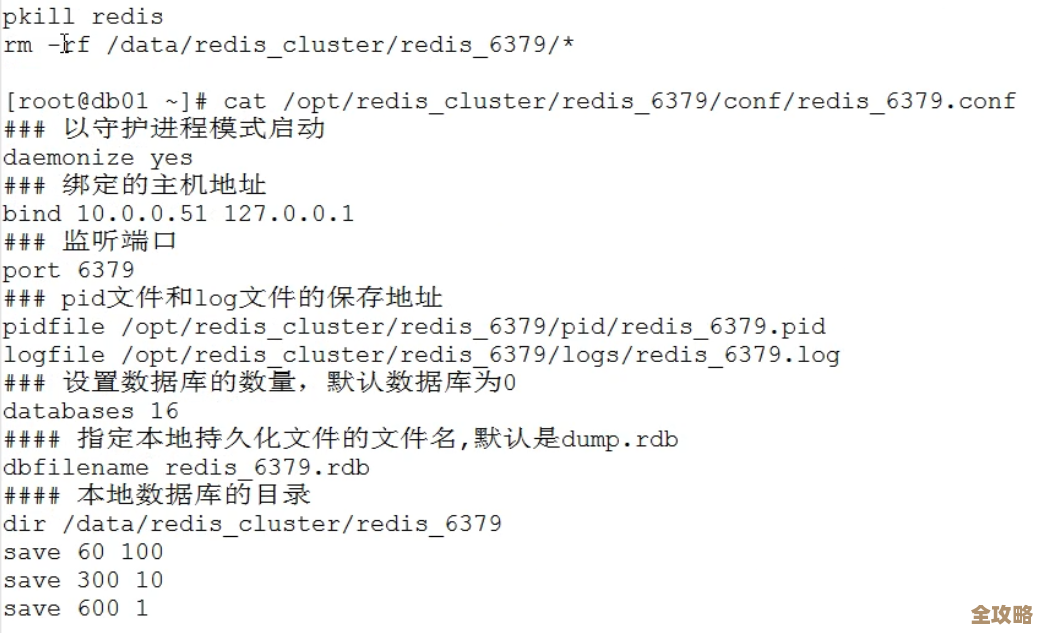

- Redis自身的持久化:Redis自己也提供了RDB快照和AOF日志两种持久化方式,可以配置为尽可能少地丢失数据(比如每秒同步一次AOF),但这主要是防止Redis进程崩溃或服务器断电导致的内存数据丢失,和我们上面讨论的“网络请求过程中的丢失”是不同维度的问题,两者结合才能构建更坚固的防线。

Redis缓存的重试机制,核心是应用程序为了应对网络或服务短暂不可用而采取的“智能重试策略”,通过指数退避和限制次数来避免卡顿和雪崩,而要保证数据不丢失,不能只依赖重试,必须结合业务操作的幂等性设计,甚至在更高要求的场景下引入异步消息队列等更稳固的架构,形成一个组合拳,简单说就是:程序要“坚韧不拔”但“懂得进退”,业务操作要“干了白干”(幂等),重要数据要有“双保险”。

本文由邝冷亦于2026-01-02发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://waw.haoid.cn/wenda/72899.html