Redis模拟三部曲的那些坑和套路,带你一步步拆解Redis背后的秘密

- 问答

- 2025-12-30 20:13:31

- 4

(引用来源:部分观点和案例灵感来源于网络技术社区如掘金、博客园上多位开发者的经验分享,特别是关于Redis实战中常见误区的总结)

Redis这个东西,现在做开发的几乎没人不用,它快得像闪电,用起来也感觉挺简单,但真要把它用好,不出岔子,那可就是另一回事了,很多人只是会个set、get,以为这就是Redis的全部了,结果一上生产环境,各种诡异的问题就冒出来了,比如内存莫名其妙就满了,或者某个关键时刻突然卡顿一下,这背后,其实就是一堆坑和套路,今天我们就来聊聊这些,不整那些高大上的术语,就用大白话拆解一下Redis背后的秘密。

第一部曲:内存管理的坑——你以为的“删除”不是真的删除

这是最容易踩的第一个坑,很多人觉得,我调用了del命令,这个键占用的内存就应该立刻释放出来,对吧?大错特错。(引用来源:Redis官方文档对内存回收机制的说明)Redis为了性能,它玩了一个“懒删除”的套路,当你删除一个键时,Redis并不会立刻把这块内存还给操作系统,而是先标记一下,说这块地方空闲了,等以后有需要的时候再复用。

这会造成什么后果呢?如果你的Redis里经常有删除大键(比如一个存了几十万个元素的Hash)的操作,你会发现,用info memory命令查看时,内存使用量(used_memory)可能降下来了,但操作系统层面看到的Redis进程占用的内存(RSS)还是居高不下,这就好像你扔掉了房间里的几个大件家具,房间看起来空了,但房子本身的面积并没变小,如果这时候主机内存紧张,Redis占着的这些“空”内存又没及时还回去,就可能引发系统开始用Swap,那速度可就一落千丈了。

套路拆解:

- 警惕大键: 尽量避免存储过大的单个键值对,别把一个包含百万字段的Hash塞进一个键里,可以考虑拆分成多个小键。

- 主动出击: 如果确实需要频繁删除大键,并且内存非常敏感,可以尝试在Redis闲时(比如凌晨)执行

MEMORY PURGE命令(如果版本支持),或者干脆重启一下Redis实例,来强制释放内存给操作系统,但这属于非常规手段。 - 监控是关键: 不能只看Redis自己报告的内存使用量,一定要监控服务器上Redis进程的实际物理内存占用。

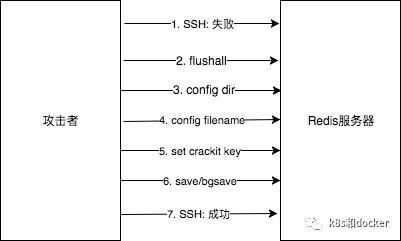

第二部曲:持久化的坑——在性能和可靠性之间走钢丝

Redis有两种主要的持久化方式:RDB(快照)和AOF(日志),这俩可不是“二选一”那么简单,选错了或者配置不当,轻则丢数据,重则服务不可用。

- RDB的坑: RDB是隔一段时间拍个快照存盘,它的套路在于,拍快照的过程是fork一个子进程来干的,如果你的Redis实例内存很大,比如有20个G,那么fork操作本身可能会造成主进程短暂的“卡顿”,因为复制父进程的内存页表需要时间,虽然现在操作系统有写时复制机制,但如果你的数据写操作非常频繁, fork过程中还是会有明显感觉,更坑的是,如果两次快照之间Redis宕机了,那么从上一次快照到宕机之间的所有数据更新就全丢了。

- AOF的坑: AOF是记录 every write operation,理论上更安全,但它也有套路,默认的每秒同步一次(appendfsync everysec)是个折中方案,但极端情况下还是会丢一秒的数据,如果设为

always,每个命令都刷盘,数据是最安全了,但性能会急剧下降,磁盘IO压力巨大,另一个大坑是AOF文件会不断增长,需要定期重写(rewrite)来瘦身,这个重写过程和RDB拍快照一样,也会fork子进程,如果AOF文件巨大,重写期间磁盘IO和内存消耗都会飙升,可能把机器拖垮。

套路拆解:

- 混合搭配: 通常建议是RDB和AOF同时开启,用RDB做冷备,用AOF保证数据实时性,这样恢复时速度比纯AOF快,数据丢失又比纯RDB少。

- 合理配置: 根据业务对数据丢失的容忍度来调整AOF同步策略,大部分场景

everysec就够了,要监控AOF文件大小,设置自动重写的触发条件。 - 硬件保障: 使用高性能的SSD硬盘来缓解AOF

always模式或重写时的IO压力。

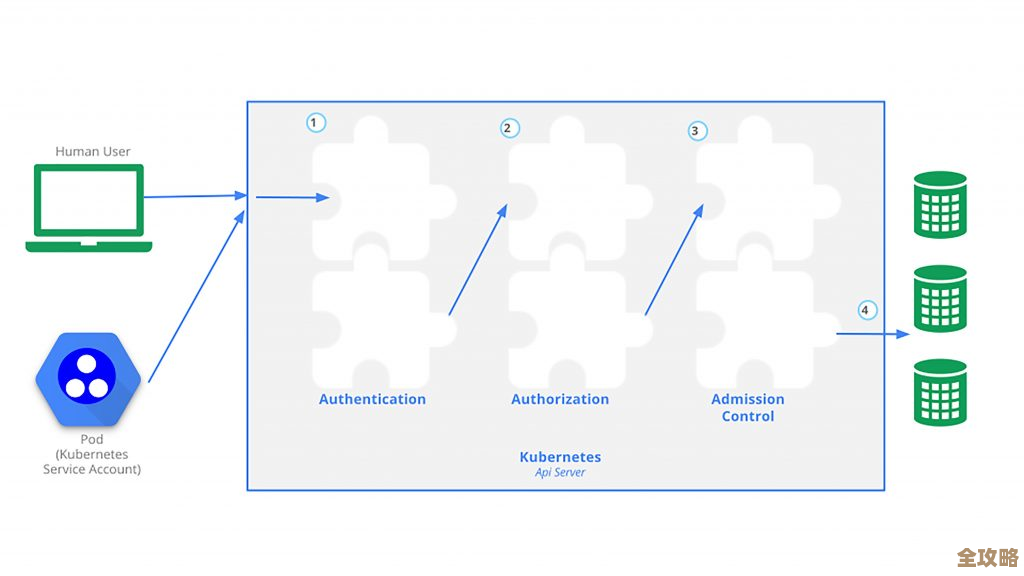

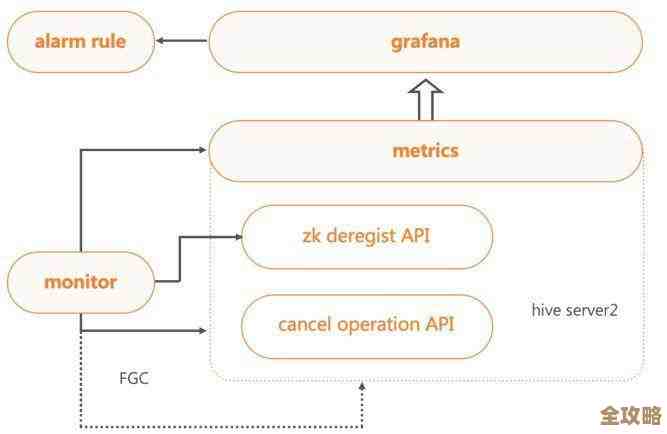

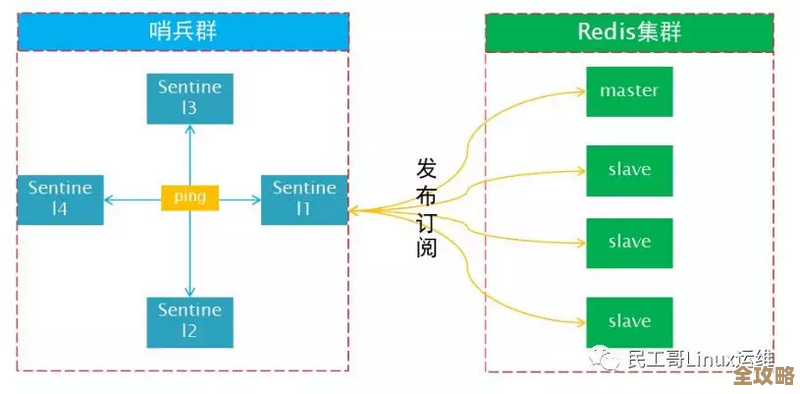

第三部曲:集群与高可用的坑——网络一抖,满地鸡毛

单机Redis有瓶颈,大家自然会用到主从复制、哨兵或者集群模式,这里面的坑就更深了。

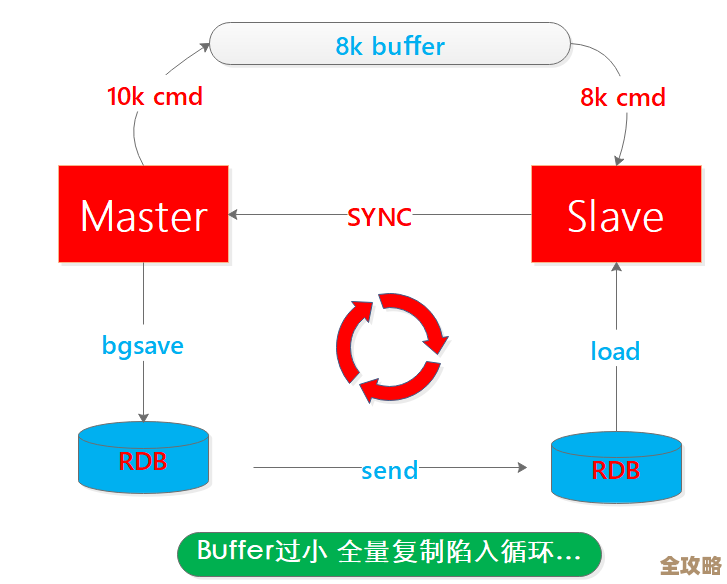

- 主从复制的坑: 主从同步不是瞬间完成的,它有一个过程,如果在数据还没完全同步到从库的时候,主库宕机了,然后哨兵把从库提升为新主库,那么还没来得及同步的那部分数据就永久丢失了,这就是“脑裂”的一种表现。(引用来源:分布式系统理论中的脑裂问题)如果从库因为网络问题或者本身压力大,导致了严重的复制延迟(秒级甚至分钟级),这时候主库挂了,你切换到一个拥有“老旧”数据的从库,也会导致数据不一致。

- 集群模式的坑: Redis Cluster把数据分片存储,看起来很美好,但它的套路在于,对客户端的要求变高了,客户端必须支持集群协议,知道哪个键在哪台机器上,如果你用了不支持集群的客户端,或者用了类似

keys *这样的命令(在集群中只会返回当前节点的键),结果会让你懵掉,集群扩容、缩容是个技术活,操作不当容易导致数据迁移失败或者服务中断。

套路拆解:

- 理解延迟: 必须清醒认识到主从复制是有延迟的,业务设计上不能依赖“写后立刻读从库一定能读到最新数据”这个假设。

- 监控复制状态: 严密监控主从之间的复制偏移量(offset),确保从库没有落后太多。

- 客户端选型: 使用成熟的、经过验证的支持Redis Cluster的客户端,并了解其重试、故障转移机制。

- 预演操作: 对集群的变更操作(如扩容)一定要在测试环境充分演练,准备好回滚方案。

Redis的秘密就在于,它用简单的接口掩盖了内部复杂的内存管理、持久化权衡和分布式协调机制,避开这些坑的套路,归根结底就是:别把它当黑盒,要了解其工作原理;根据你的业务场景(数据量、性能要求、数据可靠性要求)去做有针对性的配置和监控;永远对生产环境保持敬畏。 这把“瑞士军刀”才能真正为你所用,而不是变成一个随时可能引爆的炸弹。

本文由盈壮于2025-12-30发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://waw.haoid.cn/wenda/71465.html