聊聊算法工程师眼中那些让ChatGPT跑起来的技术细节和秘密

- 问答

- 2025-12-29 08:22:25

- 4

(引用来源:李沐等AI研究者的技术分享、OpenAI技术报告解读、开源社区如Hugging Face的讨论)

要让ChatGPT这样的模型顺利跑起来,背后是一系列庞大而精密的工程系统在支撑,从一个算法工程师的视角来看,这远不止是有一个聪明的模型架构那么简单,最直观的挑战就是“大”,ChatGPT背后的模型参数规模高达千亿级别,如此庞大的模型,根本无法装入单个GPU的显存中,这就引出了第一个核心技术:模型并行。

模型并行就像是一群人合力扛一根巨大的木头,一个人扛不动,就把它分成几段,每个人扛一段,同时前进,在技术上,这意味着需要将整个神经网络模型切割成多个部分,分别放置在不同的计算卡上,当用户输入一个问题时,这个问题的数据会依次流过这些不同的计算卡,每一张卡负责完成自己那部分模型的计算,然后将结果传递给下一张卡,这个过程需要极其精细的同步和高速的网络互联,任何一张卡速度慢了,都会成为瓶颈,拖累整个系统,这不仅仅是软件算法,更是对硬件架构的深度优化。

光是把模型装进去还不够,还得让它能“学得进”海量的数据,这就是第二个关键点:海量数据的预处理和高效训练,我们平时听到的“用了多少TB的文本数据”听起来只是个数字,但背后是巨大的数据清洗、去重、格式化的工作,算法工程师需要设计复杂的流水线,确保喂给模型的数据是高质量、多样且无毒的,训练这样一个模型一次,可能需要成千上万个GPU连续运行数周甚至数月,这期间,任何一个节点的硬件故障都可能导致训练中断,因此需要有一套强大的容错机制,能够从最近的检查点快速恢复训练,而不是从头再来,这就像是一场超级马拉松,不仅要跑得快,还要确保中途有完善的补给和医疗保障。

模型训练完成,只是万里长征第一步,真正的考验在于“推理”,也就是让模型实时回答用户的问题,这是第三个,也是普通用户最能直接感知到的技术难点,千亿参数的模型,如果每次推理都要动用全部参数,那么响应速度会非常慢,成本也高得无法承受,工程师们采用了多种“秘密武器”来加速。

一个重要的技术是量化,简单说,就是在保证模型效果下降不多的前提下,降低模型计算和存储的精度,原本用32位浮点数表示的权重,可以转换为16位甚至8位整数,这能大幅减少显存占用和计算量,从而提高响应速度、降低能耗。

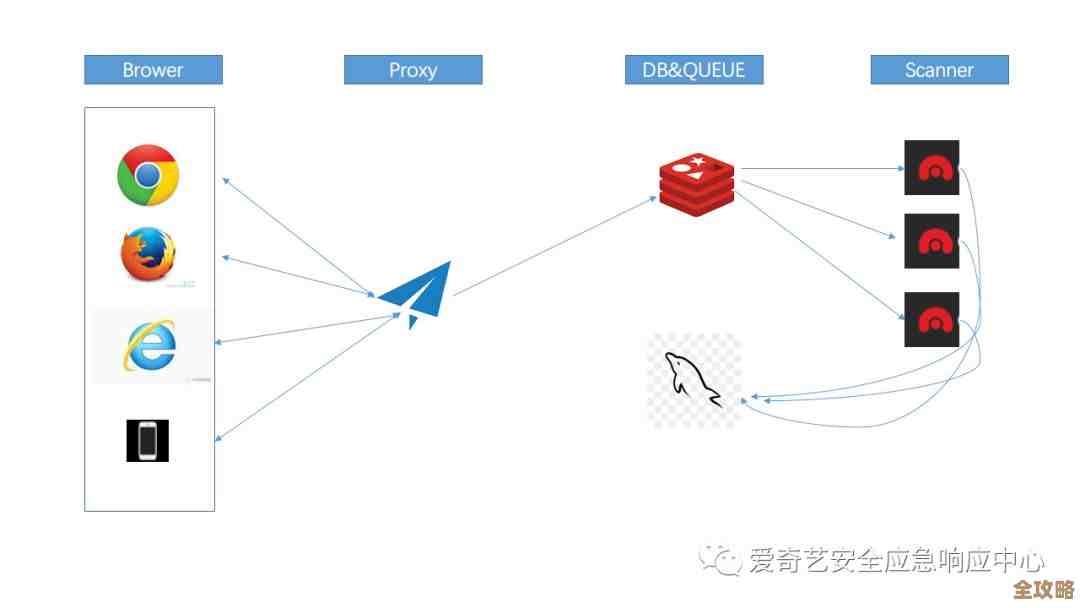

另一个关键技术是动态批处理,对于在线服务,用户的请求是零散、实时到达的,服务器不会等到凑够一大批问题才一起处理,而是会动态地将短时间内到达的多个请求“打包”成一个微批次,一次性送给GPU计算,这样可以极大提高GPU的计算利用率,避免资源闲置,这就像快递员不会每有一个包裹就送一趟,而是会规划一条路线,一次性送完一个区域的所有包裹。

还有注意力机制的精简,Transformer模型的核心是注意力机制,但其计算量会随着输入文本长度的增加呈平方级增长,如果用户输入一篇长文,计算会非常耗时,工程师们会使用各种优化的注意力算法,比如窗口注意力(只关注相邻的词)、或者采用对长文本更高效的模型结构变体,来平衡效果和速度。

整个系统还有一个看不见的“大脑”——调度器,它负责接收全球数以亿计的用户请求,然后将这些请求智能地分配到背后成千上万个模型实例上,它需要做负载均衡,避免某些机器过载而其他机器闲置;它需要做故障转移,当某台服务器宕机时,能无缝地将请求导向健康的机器;它还需要根据流量高峰和低谷,动态地扩缩容模型实例的数量,以节约成本,这个调度系统本身的复杂度和可靠性,直接决定了ChatGPT服务的稳定性和可扩展性。

在算法工程师眼中,ChatGPT的流畅运行,是一个融合了模型架构创新、分布式系统工程、高性能计算、硬件软件协同设计等众多领域顶尖技术的巨大成就,它不仅仅是一个聪明的算法模型,更是一个庞大、复杂且高度优化的工业级系统工程。

本文由黎家于2025-12-29发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://waw.haoid.cn/wenda/70541.html