聊聊ChatGPT背后的技术秘密和它到底怎么运作的那些事儿

- 问答

- 2025-12-29 08:00:59

- 3

聊聊ChatGPT背后的技术秘密和它到底怎么运作的那些事儿

要理解ChatGPT,我们可以把它想象成一个超级“语言模仿大师”和“知识缝合怪”,它的核心能力不是像人类一样“思考”或“理解”,而是通过分析海量的文本数据,学习到我们人类说话、写作的模式和规律,这个过程主要可以分为三个关键步骤:海量学习、微调对齐和对话生成。

第一步:海量学习——喂给它整个互联网的文本

在ChatGPT诞生之前,它的“大脑”基础——一个叫做GPT的模型,已经经历了一个近乎疯狂的学习过程,根据公开的技术论文和行业报道(来源:OpenAI发布的GPT相关论文及技术博客),研究人员用了从互联网上收集的巨量文本数据来训练它,这些数据可能包括维基百科、新闻文章、书籍、学术论文、论坛讨论等等,总字数可能达到了万亿级别。

这个学习过程,技术上叫做“预训练”,你可以想象成,我们把全世界图书馆和网站上的文字资料都塞给这个模型,但并不是让它去记忆具体的事实(比如法国首都是巴黎),而是让它玩一个“填空游戏”,我们不断地把一句话遮住一个词,然后让它猜被遮住的是什么,输入“今天天气真好,阳光____”,模型的任务就是预测最可能出现的词是“明媚”还是“灿烂”之类的。

通过无数次这样的练习,模型逐渐学会了词语之间的关联、句子的语法结构、甚至不同文体(比如新闻和小说)的风格差异,它构建了一个极其复杂的“概率地图”,知道了在什么样的上下文里,什么样的词最有可能出现,这就好比一个从未见过世界的孩子,通过听无数人说话,自己总结出了语言的规则,这个阶段的模型,已经能写出通顺的句子,但它还不可控,可能会生成不准确、甚至有偏见或有害的内容,因为它只是机械地模仿了互联网上的所有内容,包括其中的糟粕。

第二步:微调对齐——教它做个“有用”的AI

一个只是会模仿互联网的模型是危险且不实用的,因为它可能满口胡言或者输出不良信息,第二步就是“调教”它,让它变得有用、无害、符合人类的对话习惯,这个过程叫做“微调”和“对齐”。

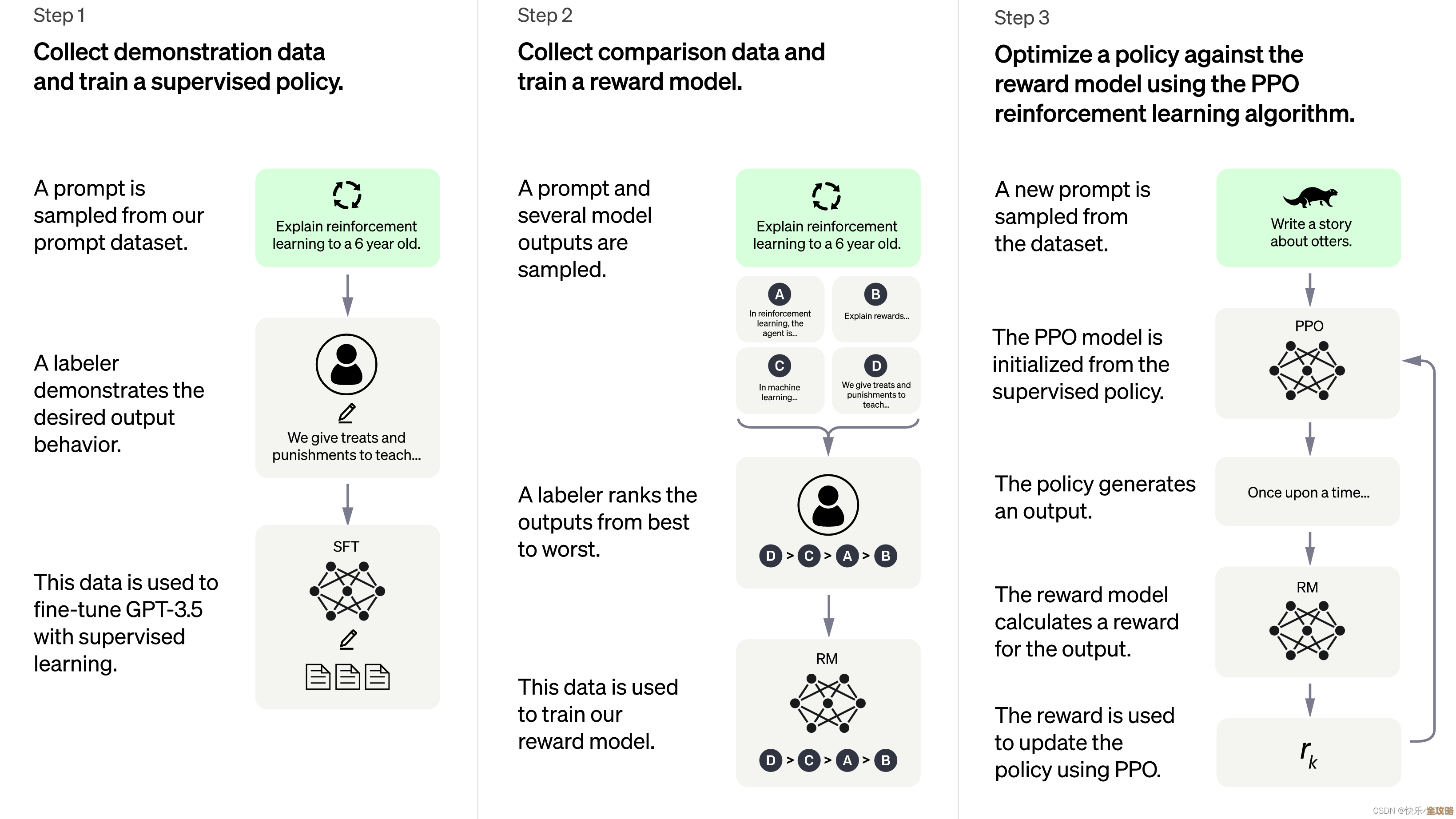

这里用到了一个很巧妙的方法,叫做“从人类反馈中强化学习”(RLHF),根据OpenAI的解释(来源:OpenAI关于InstructGPT和ChatGPT的博客),这个过程大致分三小步:

- 示范学习: 会雇佣一批人类培训师,培训师们会编写高质量的对话样例,比如用户问“解释一下相对论”,培训师就写一个清晰、准确的回答,然后用这些“标准答案”教模型,让它初步学会如何响应人类的指令。

- 比较排序: 让模型对同一个问题生成多个不同的回答,人类培训师会对这些回答从好到坏进行排序,对于“怎么烤蛋糕”这个问题,一个详细列出步骤的回答是最好的,一个敷衍的回答是差的,一个胡说八道的回答是最差的,这样,模型就获得了成千上万条“哪个回答更好”的偏好数据。

- 强化学习: 利用上面的偏好数据,训练一个“奖励模型”,这个模型能像裁判一样,自动判断ChatGPT生成的回答能得多少分,让最初的ChatGPT在这个“裁判”的监督下不断自我练习,目标是让自己的回答能获得尽可能高的奖励分,通过这种反复优化,ChatGPT就慢慢学会了生成更受人类喜欢、更有帮助、更安全的回答。

经过这个阶段的“调教”,ChatGPT才从一个“语料复读机”变成了一个看起来彬彬有礼、乐于助人的“对话伙伴”。

第三步:对话生成——和你聊天时,它到底在干嘛?

当你在对话框里打下一段话并按下回车时,ChatGPT内部瞬间完成了一系列复杂操作:

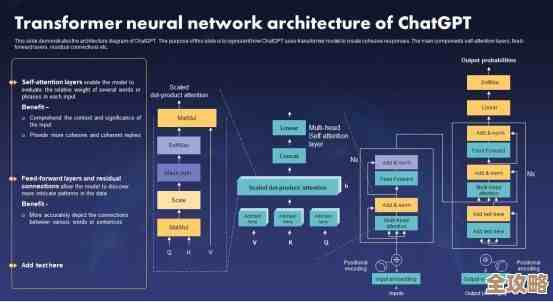

- 理解输入: 它会把你的话分解成它能够处理的 tokens(可以粗略理解为词或字片段),并分析其结构和意图。

- 启动“预测”模式: 它回到第一步学到的老本行——预测下一个词,它以前面所有的对话(包括你的问题和它自己之前说过的话)为上下文,从数万个可能的词汇中,计算每一个词出现的概率。

- 不是选最高分,而是“抽签”: 这里有个关键点,它通常不会直接选择概率最高的那个词,因为那样的话,每次问同样的问题,答案会一模一样,非常死板,所以它会采用一种带随机性的“抽签”方式,概率高的词被抽中的机会大,但概率低的词也有机会,这正是ChatGPT回答富有变化和创造性的来源。

- 循环往复: 选中第一个词后,它会把这个词加到上下文中,再去预测第二个词,如此循环,像滚雪球一样,直到生成一个完整的回答,或者达到长度限制。

你得到的每一个回答,都是这个巨型模型在万亿级参数的支持下,进行数亿次计算,一个字一个字“猜”出来的,它没有情感,没有意识,但它通过学习和优化,成功地模拟出了一场逼真、有趣的对话,这就是ChatGPT背后最核心的技术秘密和运作方式。

本文由畅苗于2025-12-29发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://waw.haoid.cn/wenda/70531.html