Redis连接池老是满,搞得服务卡顿又难受,真心头疼啊

- 问答

- 2025-12-27 19:55:39

- 2

Redis连接池老是满,搞得服务卡顿又难受,真心头疼啊,这个问题就像个磨人的小妖精,平时看着没事,一到关键时候就跳出来捣乱,整个服务的响应速度立马就跟老牛拉破车一样,慢得让人心急火燎,我估摸着,不少搞后端开发的朋友都遇到过这档子事儿,今天就来好好唠唠这个让人“头疼”的问题,都是大白话,说说咱的亲身经历和琢磨出来的道道。

症状表现:服务怎么就“卡顿又难受”了?

这问题最直观的感受就是,用户那边页面转圈圈转个没完,或者APP直接弹个提示说“服务繁忙,请稍后再试”,查后台日志,满眼都是获取数据库连接超时的错误,或者干脆直接报错说“连接池耗尽”(PoolExhaustedException),这感觉就像高峰期去银行,就开了一个窗口,后面排了上百号人,队伍一动不动,大厅里怨声载道,咱们的服务也一样,业务线程(好比办理业务的客户)都在那儿干等着拿到一个珍贵的Redis连接(好比银行窗口),等不到就卡住了,后续的请求也跟着堵成一锅粥,整个服务的吞吐量骤降,延迟飙升,用户体验直接跌到谷底。

追根溯源:连接池为啥会“满”?

好端端的池子,里面的连接怎么就“供不应求”了呢?根据网上各路大神的分析和咱自己踩坑的经验,主要原因大概出在这么几个地方:

- 连接泄露(最常见也是最讨厌的):这是最坑爹的情况,简单说,就是代码里从连接池借走了连接(比如执行一个Redis命令),用完了却忘记还回去了,这就像从公共工具箱里拿了把扳手,用完之后随手一扔,忘了放回原处,一次两次没事,次数多了,工具箱里的扳手就越来越少了,直到被人借光,后面的人想用也没得用,在代码里,可能就是

try-catch块没写好,在异常情况下没有正确关闭连接;或者用了框架,但对资源释放的生命周期没搞清楚。 - 并发量突增,池子太小:平时业务平稳,连接池大小设置(比如默认的8个)勉强够用,突然搞个促销活动,或者某个热点事件导致请求量翻了好几倍,这时候,有限的连接瞬间就被抢光了,新的请求只能排队等待,如果等待时间也设置了,超时了就直接报错,这就好比平时小区门口只有一个早点摊够用,突然来了个旅行团,所有人都涌过去买煎饼果子,队伍自然就排到马路上了。

- 慢查询拖垮了整个池子:某个Redis操作执行得特别慢,比如一个模糊删除

keys *命令操作了一个超大的键集合,或者一个复杂的Lua脚本执行了很长时间,这个慢查询会长时间占用一个连接不释放,如果同时有几个这样的慢查询,就会占用多个连接,连接池里的连接总数是固定的,被这些“慢吞吞”的家伙占着茅坑不拉屎,其他正常的、快速的请求就只能干瞪眼,整个池子的效率都被拉低了,这就像高速公路上有几辆龟速行驶的大卡车,把后面所有的快车都堵得严严实实。 - 网络波动或Redis服务端不稳定:如果网络状况不好,经常丢包、延迟高,或者Redis服务器本身负载很高、响应慢,也会导致客户端每个操作耗时变长,间接地,这就相当于每个连接被占用的时间变长了,连接周转不开,同样会导致池子很快被耗光。

- 连接池配置不合理:除了最大连接数设小了,可能其他参数也没调好,比如最大等待时间设得太短,请求刚排一会队就放弃了;或者连接空闲超时时间设得太长,一些本该被回收的连接一直占着名额。

排查思路:怎么找出那个“罪魁祸首”?

当问题发生时,不能干着急,得有条理地查。

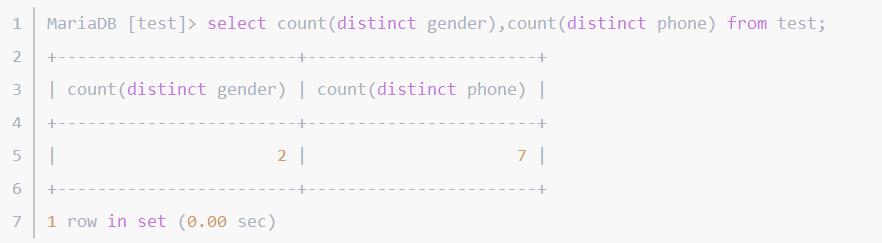

- 第一步:看监控,如果有监控系统,先看Redis服务端的QPS、CPU使用率、慢查询日志,再看客户端应用服务器的CPU、内存,以及连接池的关键指标:活跃连接数、空闲连接数、等待获取连接的线程数、连接获取耗时,如果活跃连接数持续顶到最大值,同时等待线程数很高,那基本就是连接池满了。

- 第二步:查日志,重点看错误日志,找到那些连接超时的报错堆栈,分析是在执行什么业务逻辑时发生的,有时候堆栈信息能帮你定位到是哪个方法、哪个服务调用导致的。

- 第三步:代码审查,怀疑连接泄露的话,就重点检查所有操作Redis的代码块,确保每一个

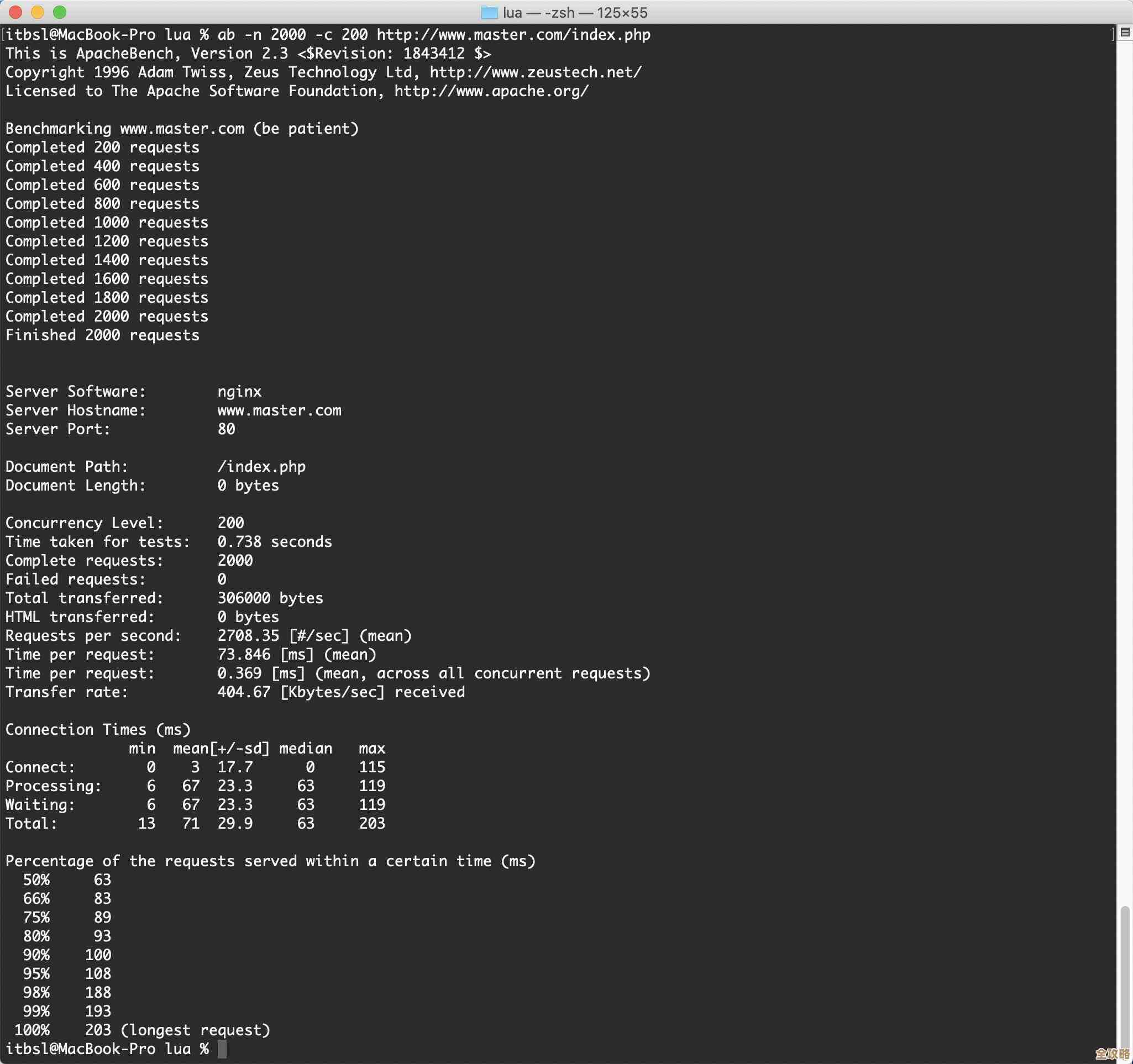

getResource()或类似获取连接的操作,都在finally块中有对应的close()或返还连接的操作,现在一般都用连接池客户端,它通常会自动归还,但如果你的用法不对,比如在高层一次性获取连接,然后层层传递,底层又关闭了,可能就会出问题,或者使用Jedis时,没注意区分Jedis实例和连接池的关系。 - 第四步:模拟压测,在测试环境,用压测工具模拟高并发场景,观察连接池的使用情况,这样可以更主动地发现容量不足或慢查询等问题。

解决之道:如何让服务“顺畅”起来?

找到原因后,就可以对症下药了:

- 针对连接泄露:严格规范代码写法,强制使用

try-with-resources语法(Java)或类似的机制,确保连接一定被关闭,进行代码审查,重点检查资源释放逻辑,也可以考虑使用一些静态代码分析工具来辅助检测潜在泄露。 - 针对池子太小:合理调整连接池参数,根据业务的平均并发量和峰值并发量,适当调大

maxTotal(最大连接数)、maxIdle(最大空闲连接数)等参数,但也不能无脑调大,因为每个连接都会占用服务器资源,连接数太多也会给Redis服务端带来压力,需要在资源和性能之间找平衡。 - 针对慢查询:优化Redis使用方式,这是治本的方法之一,坚决避免使用

keys、flushall等危险命令,用scan代替,检查大的Hash、List等复杂结构的操作是否高效,给Redis命令设置超时时间,避免无限期等待,对大数据量操作考虑分批处理。 - 加强监控与告警:对连接池的关键指标建立监控大盘,并设置告警规则,比如当活跃连接数超过最大值的80%、或者有大量等待线程时,就立即发出告警,这样可以在问题影响扩大前及时干预。

- 降级与熔断:在客户端实现降级策略,当获取Redis连接失败或超时时,可以考虑返回本地缓存的数据、默认值,或者直接跳过这个非关键操作,保证主流程不被阻塞,起码服务不会完全不可用。

Redis连接池满了这个问题,看似简单,背后往往藏着代码bug、配置不当、容量规划或使用习惯上的问题,它不是一个能一劳永逸解决的事情,需要我们在日常开发中保持对资源的敬畏之心,写好每一行代码,配好每一个参数,并建立起有效的监控防线,才能让Redis这个性能利器真正地为我们所用,而不是时不时跳出来让我们“头疼”。

本文由黎家于2025-12-27发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://waw.haoid.cn/wenda/69601.html