Redis缩容到底是咋回事,原理复杂但又挺关键,得好好搞懂才行

- 问答

- 2025-12-27 02:07:53

- 3

你问Redis缩容是咋回事,这事儿确实挺关键的,尤其是在公司里用到Redis集群的时候,说它原理复杂,是因为它不像我们想象中“直接关掉几台机器”那么简单,背后涉及到数据迁移、高可用、服务不中断等一系列问题,咱们就把它掰开揉碎了,用大白话讲清楚。

为啥要缩容?

这好理解,就像你开饭店,生意好的时候加了十张桌子(相当于给Redis集群加了十台服务器),后来生意回归平淡,空着那么多桌子占地方还费电(服务器是成本),你就想撤掉几张,对应到Redis,可能就是业务高峰过去了,或者优化了代码使得对Redis的需求没那么大了,又或者就是为了节省成本,需要减少集群中服务器的数量。

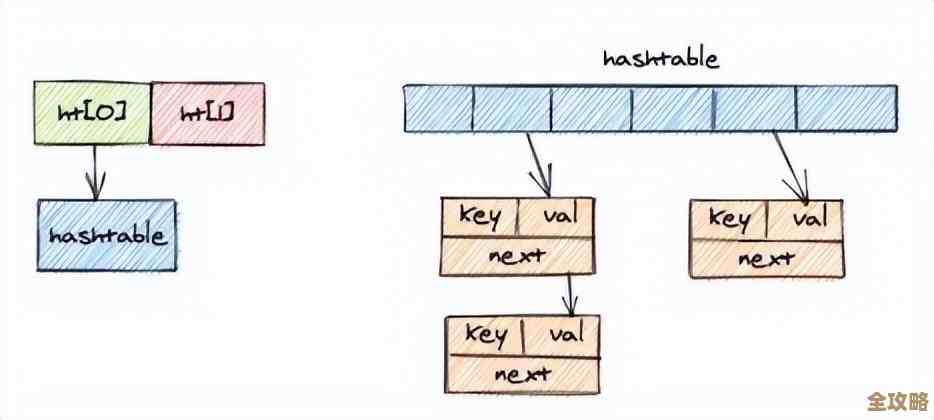

缩容的核心难题:数据怎么办?

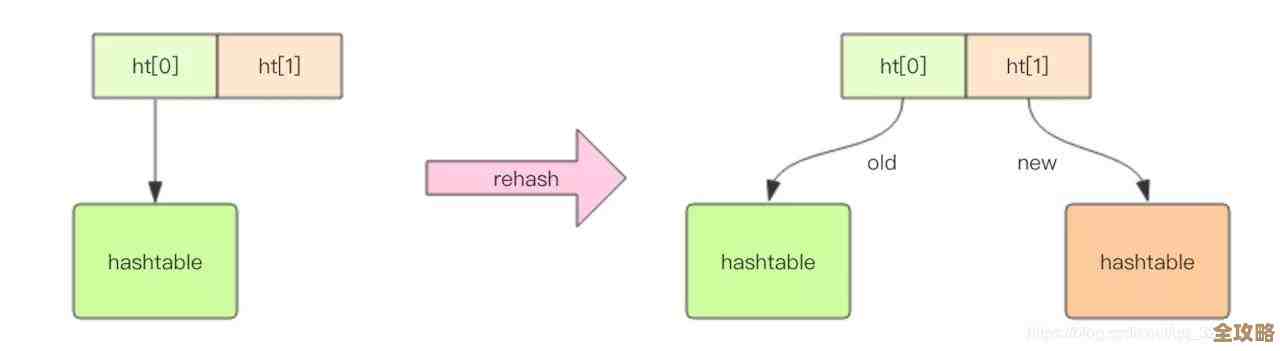

Redis集群的数据是分片存储的,也就是把海量数据分成很多份,每一份放在不同的服务器上,比如你有三个节点,数据可能被大致平均分成三份,各自保管,现在你要缩容,比如从三个节点变成两个节点,那原来第三个节点上的数据不能丢啊,得给它找个新家,这个“找新家”的过程,就是数据迁移,这是缩容最核心、最复杂的一步。

Redis集群的缩容过程(以主流方案为例)

主流的方式是使用像Codis或者Redis Cluster这样的集群方案,它们处理缩容的思路是“平滑”的,目标是尽可能不让正在使用的业务方感知到。

-

标记节点为“下线中”:运维人员会通过管理工具,告诉集群:“喂,我准备要移除编号为03的这台机器了。” 集群一听,就会把03号机器标记为“准备下线”的状态。关键点来了:从这一刻起,集群就不会再分配新的数据写入请求到03号机器了,对于03号机器上已经存在的数据,正常的读写请求还是可以过来的,这是为了保证服务不中断。

-

数据迁移(最核心的步骤):集群会自动开始一个“搬家”工程,它会扫描03号机器上存储的所有数据,计算这些数据应该被迁移到剩下的哪台机器上(比如01号或02号),就开始一点点地把这些数据拷贝到新的机器上,这个搬家过程是细水长流的,不是一下子全搬,而是一条一条数据地搬。

- 搬家时的读写怎么办? 这又是另一个精妙之处,当某条数据正在从03号机器往01号机器迁移的过程中,如果有一个读写请求过来,集群会怎么做?聪明的做法是:它会临时“拦截”这个请求,当迁移开始时,03号机器上要搬走的数据会被暂时锁定,如果这时有写请求过来,集群会先让这个写操作在03号机器上完成,同时,这个写命令也会被转发到01号机器(新家)上去执行,等这条数据完全迁移完毕,之后所有针对这条数据的请求,就会直接发到01号机器,03号机器上的旧数据最终会被删除,这样就保证了在迁移过程中,数据不会错乱,永远是唯一的、最新的。

-

确认迁移完成与节点下线:集群会持续检查,直到03号机器上所有需要迁移的数据都安全地搬到了新家,当确认数据迁移完毕,03号机器上已经没有“属于集群”的数据后,集群就会正式将03号机器从集群成员列表中剔除,这时候,你就可以放心地关掉03号机器的电源,或者拿去干别的事情了。

缩容需要注意的风险和坑

虽然过程设计得很平滑,但搞不好还是会出问题:

- 网络和性能压力:数据迁移本身会占用大量的网络带宽和服务器本身的CPU、内存资源,如果你在业务高峰期搞缩容,迁移流量可能会挤占正常业务的资源,导致请求变慢,所以缩容通常选择在业务低峰期进行。

- 慢操作引发的问题:如果03号机器上存了一些特别大的数据(比如一个巨大的List或Hash),迁移它可能需要较长时间,在这段时间里,针对这条数据的操作可能会被阻塞一小下,如果客户端有超时设置,就可能感受到卡顿。

- 规划不当的后果:缩容后,剩下的机器需要承担之前所有机器的负载,如果你从10台缩到2台,但这两台机器的内存、处理能力不足以支撑全部流量,那就会导致新瓶颈,比如内存不够用(OOM)、响应变慢,甚至雪崩。

总结一下

Redis缩容根本不是简单地关机拔线,而是一个精心设计的“在线搬家”流程,它的核心思想是:先找好新家,然后一边维持旧家的正常营业,一边悄无声息地把家具(数据)一件件搬过去,并且确保在搬运过程中,如果有人要来用家具,也能正确无误地处理。 整个过程力求平滑,保证数据不丢、服务不停。

理解了这一点,你就能明白为什么这事儿“得好好搞懂才行”,操作不当,轻则导致服务抖动,用户体验变差;重则可能引发数据不一致甚至丢失,造成线上事故,在实际操作前,必须在测试环境充分演练,制定详细的方案和回滚计划,选择合适的时间窗口,并做好监控,这样才能确保缩容这个关键操作万无一失。

(参考资料:本文内容综合自《Redis设计与实现》一书中对Redis Cluster的讲解、Redis官方文档中关于集群管理的部分,以及业界如Codis等项目在实践中的常见处理方式。)

本文由黎家于2025-12-27发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://waw.haoid.cn/wenda/69139.html